ロボットの Txt ファイルを WordPress に追加する方法 (3 つの簡単なステップで)

公開: 2022-09-21WordPress サイトへの robots.txt ファイルの追加は、いくつかのステップで実行できる簡単なプロセスです。 robots.txt ファイルは、ウェブサイトのどのページをインデックスに登録し、どのページを無視する必要があるかを検索エンジンのクローラーに伝えるテキスト ファイルです。 特定のページをインデックスから除外することで、サイトの検索エンジン最適化 (SEO) を改善できます。 robots.txt ファイルを WordPress に追加するには、いくつかの方法があります。 最も簡単な方法は、Yoast SEO や All in One SEO Pack などのプラグインを使用することです。これにより、robots.txt ファイルが自動的に生成されます。 または、自分で robots.txt ファイルを作成し、FTP 経由で WordPress サイトにアップロードすることもできます。 どちらの方法を選択する場合でも、robots.txt ファイルを公開する前に必ずテストして、意図したとおりに機能することを確認してください。

特定のキーワードの検索エンジンでのプレゼンスを取得することは、サイトが SERP に確実に表示されるようにするため、Web サイトの所有者にとって不可欠です。 ウェブマスターは、特別なファイルである robots.txt に指示を挿入することで、検索エンジン ロボットがウェブサイトの内外で費やす時間を設定できます。 このチュートリアルでは、「robots.txt」ファイルを WordPress Web サイトに追加して、検索エンジンがサイトの特定の部分にアクセスできないようにする方法を紹介します。 FileZilla を使用して Cloudways プラットフォームに接続します。 /applications/ [FOLDER NAME]/public_html に robots.txt という新しいファイルを作成できます。 ファイルをテキスト エディターで開きます (メモ帳を使用することをお勧めします)。 ワイルドカード設定により、特定の種類のファイルをダウンロードできます。

アスタリスク (* が処理できるオプション/選択に制限はありません。さらに、特定の拡張子が選択されている場合は、オフにできるファイルの数を制限できます。Robots.txt は、SEO に使用する素晴らしいファイルです。目的. WordPress サイトのどの部分を SERP に表示するかはあなた次第です. サイトにサイトマップがある場合は、検索エンジンがサイトを見つけやすくするために URL を含める必要があります. ディレクトリは、多くの場合、インデックスを作成する必要はありませんその結果、ページのインデックス作成が大幅に高速化されます。

そのため、検索エンジンが特定の部分をインデックスに登録しないようにするには、ウェブサイトのスクリプトに robots.txt を含める必要があります。 サイトが正しく構成されていない場合 (delete / など)、Google によってインデックスが削除されます。 あなたも用心する必要があります。 タスクを完了する機会があります。 このタイプのファイルを使用しているかどうか、およびその設定について教えてください。

txt は、使用する最も簡単なファイル形式の 1 つです。 ロボットは、表示したいページに基づいて「許可」(つまり、インデックスを作成) および「拒否」(つまり、拒否) するようにプログラムされています。 後者は、スパイダーにクロールさせたくないページをリストするために一度だけ使用されます。

txt という名前のテキスト ファイルを Web サイトで使用して、Web クロール ボットに指示を与えることができます。 Google やその他の検索エンジンは、ウェブ ロボットとも呼ばれるウェブ クローラーを使用して、ウェブサイトをアーカイブおよび分類します。 ロボット検索は通常、ボットで使用されます。

robots.txt は、インターネット上のファイルに追加できます。 Web サイトのディレクティブを表示するには (サイトにロボットが含まれている場合)、任意のルート ドメインの末尾に URL をテキストで送信します。

ロボットの Txt ファイルを WordPress のどこに配置すればよいですか?

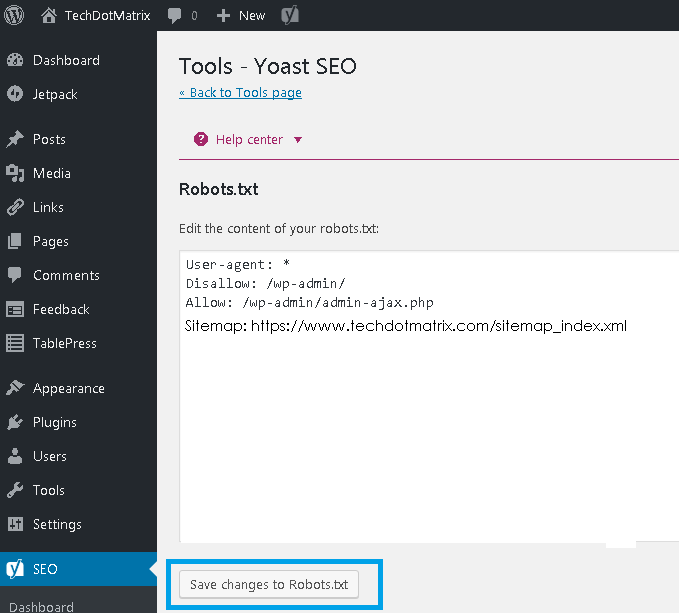

クレジット: www.techdotmatrix.com

クレジット: www.techdotmatrix.comFTP クライアントの左側のセクションに移動して、 FTP ロボットのリストを作成します (ここでは Filezilla を使用しています)。 以前に作成した txt ファイルをコンピューターに保存しました。 右クリックして [アップロード] を選択すると、アップロードできます。 ファイルはすぐにアップロードされ、WordPress のルート ディレクトリに表示されます。

robots.txt ファイルは WordPress のルート ディレクトリにあり、テキスト ファイルです。 検索エンジン ボットに、Web サイトのどのページをクロールする必要があるかを知らせるために、クロールする必要があるページとクロールしないページのリストが表示されます。 インデックス作成ではなく、クロールを回避するようにファイルに指示することができます。 悪いボットが Web サイトを破壊した場合、優れたセキュリティ プラグインが不可欠です。 WordPress は、それを使用するすべての Web サイトに対して仮想 robots.txt ファイルを作成します。 何かを変えたい場合、選択肢は 3 つあります。 ウェブサイトを最適化するための最も人気のあるツールの 1 つである Yoast SEO プラグインは、優れた選択肢です。

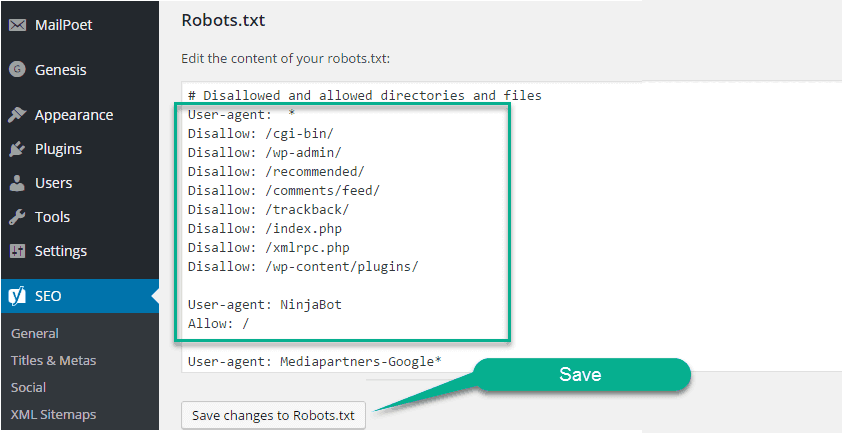

別の無料の SEO プラグインである All in One SEO は、さまざまな追加機能を提供します。 以前に FTP を使用したことがある場合は、robots.txt ファイルをサーバーにアップロードできることをご存知でしょう。 robots.txt ファイルには、後でルールとディレクティブを追加できる Robots.txt という新しいセクションが表示されます。 User-agent と Disallow はどちらも、このファイルに含まれるディレクティブです。 単一のボット (Bingbot など) を指定する場合、またはディレクティブをすべてのボットに適用する場合は、アスタリスク (User-agent: *) を入力します。 過剰なクロール リクエストはサーバーに過負荷をかけ、クロール遅延ディレクティブが使用されます。 このディレクティブをサポートするクローラーがないため、注意して使用することをお勧めします。

Sitemap ディレクティブを使用すると、検索エンジンは XML サイトマップ ファイルに誘導されます。 次のセクションでは、robots.txt ディレクティブの使用方法を示す 2 つのサンプル スニペットを示します。 各 WordPress サイトのルート ディレクトリには robots.txt ファイルがあります。 その中で、クローラーは、Web サイトのどのセクションを検索する必要があるかについて指示を受けます。 彼らは地面を這うべきであるか、または這うべきではありません。 話し合いの中で、ファイルの物理バージョンを作成する方法とそれを編集する方法について説明しました。

WordPress ウェブサイトに robots.txt ファイルを追加する必要がありますか?

WordPress がインストールされるとすぐに、自動的に robots.txt ファイルが生成されます。 検索エンジンのインデクサーは、このディレクトリをファイルして、サイトのどのページをインデックスに登録するかを決定します。 ほとんどの場合、WordPress Web サイトに robots.txt ファイルを追加する必要はありません。 ただし、検索エンジンのランキングを上げるために、robots.txt ファイルを追加して検索エンジンのインデックスを管理できます。

WordPress でロボットの Txt ファイルを開くにはどうすればよいですか?

クレジット: www.hitechwork.com

クレジット: www.hitechwork.comWordPress で robots.txt ファイルを開く方法はいくつかあります。 1 つの方法は、WordPress のインストール フォルダーに移動し、ファイルをテキスト エディターで開くことです。 もう 1 つの方法は、 WP Robots Txtなどのプラグインを使用して、WordPress 管理領域内からファイルを編集することです。

ほとんどすべての Web サイトに robots.txt ファイルがありますが、ほとんどの人はその機能や使用方法を理解していません。 このガイドでは、ファイルとその制限を見て、Web サイトのアクセスを管理する方法を学習します。 ページにリンクが張られていても、robots.txt によってブロックされていれば、検索エンジンによってインデックスされる可能性があります。 Google は、サイト内のマークされた領域にはアクセスしません。 Google ウェブマスター アナリストの John Mueller 氏によると、Google によってブロックされていないページに noindex タグを追加することができます。 人気の Yoast SEO プラグインを使用して、SEO テンプレートを作成 (および後で編集) できます。 Yoast のインターフェイスを右クリックして、robots.txt ファイルを適切な場所に配置します。

同様に、All in One SEO プラグインでこのタイプの統合を実装できます。 WordPress の robots.html ファイルで指定する必要があるさまざまなタイプのディレクティブの詳細については、引き続きお読みください。 ルールを追加する前に、まずルールを適用するユーザー エージェントを選択し、続いて [許可しない] と [許可する] を使用して適用するルールの数を選択する必要があります。 フォルダーとその子フォルダーへのアクセスを禁止し、特定の子の特定のフォルダーへのアクセスを許可することは、フォルダーとその子フォルダーへのアクセスを制限する場合に有効です。 [許可] を選択すると、特定のフォルダー内の特定のファイルへのアクセスを許可できますが、フォルダー全体へのアクセスは禁止されます。 WordPress は、クエリを処理するときに、?s= という名前のクエリ パラメータを使用します。 アクセスのブロックを構成するには、次のルールを追加するだけです。

ソフト 404 エラーは、この機能を使用したり、発生した場合にブロックしたりすることで回避することもできます。 米国以外の特定の地域をターゲットにしている場合でも、Googlebot の入国をブロックする必要はありません。 Google は、目に見えない文字を含むコマンドが理解されていないことに苛立っています。 残念ながら、これにより robots.txt ファイルの最初の行が無効になります。 これは、Disallow コマンドと呼ばれる robots.txt ファイルで noindex タグを使用することとは異なります。 一方、Bots.txt はインデックスを作成しませんが、クロールを防止します。 これを使用して、特定のルールを追加することで、検索エンジンや他のボットが Web サイトと対話する方法を構成できます。 WordPress をまったく使用しないほとんどの人にとって、デフォルトの virtual robots.html ファイルを変更する必要はありません。 ただし、特定のボットまたはプラグインに問題がある場合は、独自のルールを追加できます.

robots.txt ファイルをサイトに追加する方法

WordPress を使用している場合は、新しいページの追加ウィザードを使用して、このファイルをサイトに簡単に追加できます。 次に、[ファイル URL] フィールドに、robots.txt ファイルの URL を入力します。 このファイルは、ダッシュボードの [ページの管理] メニュー項目をクリックして、WordPress ページに追加することもできます。

WordPress を使用していない場合は、別の方法で robots.txt をサイトに追加する必要がある場合があります。 コンピュータに FTP クライアントがインストールされている場合は、このファイルを簡単に追加できます。 コンピューターにファイル マネージャーがインストールされている場合は、簡単に追加できます。

WordPress のロボット Txt ファイルは必要ですか?

クレジット: pressidium.com

クレジット: pressidium.com問題の特定の WordPress サイトと、そのサイトのコンテンツや機能の種類によって異なるため、この質問に対する決定的な答えはありません。 ただし、一般的には、WordPress に robots.txt ファイルが厳密に必要というわけではありませんが、場合によっては便利です。 たとえば、WordPress サイトに機密情報や機密情報が多数含まれている場合、robots.txt ファイルを使用して、検索エンジンがこのコンテンツをインデックスに登録しないようにすることができます。

robots.txt ファイルは単純なテキスト ファイルで、ウェブサイトをいつどこでクロールしてはならないかを検索エンジンに伝えます。 この機能を使用すると、検索エンジンがサイト上のさまざまなファイルやフォルダーにアクセスするのを防ぐことができます。 この記事では、プラグインを作成する方法を紹介し、推奨するプラグインをいくつか提供して、自分で作業できるようにします. すべての検索エンジンには、検索結果に Web クローリング ユーザー エージェントが含まれています。 たとえば、Googlebot は、Google の検索エンジン用にウェブサイトのコンテンツをインデックスに登録します。 これらのユーザー エージェントごとにカスタム手順を構成するオプションがあります。 ドメイン名の後に「/robots.txt」と入力すると、robots.txt ファイルにアクセスできます。

リンクをたどって、スラッシュを引き換えた後、ロボットにサイトのページを表示しないように指示できます。 予算クロールは、検索エンジン ボットがセッションでクロールできる URL の数として定義されます。 すべての Web サイトには、特定のクロール バジェットが設定されています。 Web サイトに多数のページがある場合は、ボットが最も価値のあるページを最初にクロールしているかどうかを確認する必要があります。 WordPress の Yoast SEO プラグインを使用すると、ダッシュボードから robots.txt ファイルを簡単に作成できます。 次に、Filezilla などの FTP クライアントを使用して、ファイルを手動でアップロードします。 ファイルを Web サイトに表示する場合は、ファイルがルート フォルダーにあることを確認してください。

作成するには、ファイルがない場合はメモ帳などのテキスト エディターを使用する必要があります。 robots.txt ファイルは、常に Web サイトのルートに配置する必要があります。 検索エンジンは、このファイルがあるかどうかに関係なく、引き続きサイトをクロールしてインデックスに登録します。 Google Search Console で robots.txt ファイルをテストするのは簡単です。 [今すぐプロパティを追加] をクリックすると、数分でウェブサイトを Google 検索に追加できます。 各 Web サイトで特定のクロール バジェットを維持することが重要です。 セッション中にボットがアクセスする必要があるページ数を考慮する必要があります。 セッション中にボットがサイトのすべてのページのクロールを完了していない場合、ボットはサイトに戻り、次のセッションでクロールを再開します。 簡単な解決策は、検索ボットによる不要なページ、メディア ファイル、プラグイン、テーマ フォルダーなどのクロールをブロックして、クロール クォータを節約することです。

簡単に言うと、次の行を robots.txt ファイルに追加します: Agents: users. Googlebot サービスは現在使用中です。 robots.txt ファイルがない場合、Googlebot はページをクロールし、検索エンジンで自動的にインデックスに登録します。

SEO を改善するために Robots.txt ファイルを追加する必要がある理由

robots.txt ファイルをダウンロードすると、ウェブサイトの検索エンジンのランキングを上げることができます。 クローラーは、コンテンツが許可されているかどうかとその理由を確認するために、Web サイトのルートでこのファイルを探します。

Robots.txt ワードプレスの編集

robots.txt ファイルを編集するには、WordPress ダッシュボードに移動し、[設定] タブをクリックします。 そこから、robots.txt ファイルを編集できる「読み取り」セクションが表示されます。

robots.txt ファイルは、検索エンジンにサイトの移動を許可するだけでなく、サイトをクロールする方法も伝えます。 サイトの不要なページをクロールしないようにボットに指示すると、読み込み速度が向上し、検索エンジンで上位にランクされる可能性があります。 この投稿では、WordPress を使用して robots.html ファイルを編集する方法を紹介します。 robots.txt ファイルは、いくつかの理由で必要です。 ウェブサイトをロードするときに、robots.txt の代わりにメタ noindex タグを使用する場合。 なぜそれが私たちの生活の中でそれほど重要なのか. このシステムでは、Web サイトとやり取りする検索エンジンや他のボットを指定できますが、検索エンジンや他のボットによるコンテンツのインデックス作成を明示的に禁止するわけではありません。

AIOSEO を使用して、WordPress で robots.html ファイルを段階的に編集する方法を見てみましょう。 ルール ビルダーを使用すると、ロボットがアクセスする可能性がある、またはアクセスしない可能性のある特定のページに対して独自のルールを作成できます。 カスタム ルールを作成する場合、[ユーザー エージェント] フィールドにユーザー エージェント ( Googlebot クローラーなど) を入力できます。 どのボットを許可または拒否するかを決定した後、[ディレクトリ パス] フィールドにディレクトリ パスまたはファイル名を入力する必要があります。 新しいルールを保存すると、Robots.txt プレビュー セクションに表示されます。 [ロボットを開く] をクリックすると、robots.txt ファイルが表示されます。 このテキストは、利用可能になり次第、モバイル デバイスに送信されます。 ルールの詳細を入力するだけで、ルールを変更できます。 ルールを削除するいくつかの例は、別のセクションで示されます。

WordPress のデフォルトの Robots.txt

WordPress サイトを作成し、カスタム robots.txt ファイルを作成しない場合、サイトは次の内容を含むデフォルトの robots.txt ファイルを自動的に生成します: User-agent: * Disallow: / The first line, User-agent: * 、すべてのWeb クローラーに適用されます。 2 行目の Disallow: / は、サイトのどのページもインデックスに登録しないようにすべての Web クローラーに指示します。 これは最も制限の厳しい設定であり、ほとんどの WordPress サイトでは推奨されません。

よく構造化された robots.txt ファイルを使用すると、検索エンジン ボットを Web サイトに誘導できます。 彼らはそれを見ている間、それらの部屋から距離を保つように言われています. 技術的なウィザードでなくても、コーディングの知識がなくても、必要に応じてこのファイルを作成できます。 WordPress Web サイトを作成すると、仮想 robots.txt ファイルが作成されます。 ボットは、このファイルに基づいて管理者および WP-includes ディレクトリにアクセスできなくなります。 変更するには、最初に新しいファイルを作成してから、ルート フォルダーにアップロードする必要があります。 WordPress で robots.txt を編集するには、プラグインまたは手動の 2 つの方法があります。

この例では、Bing の検索ボットがサイトをクロールするのを防ぐための新しいルール セットを作成しました。 このファイルの指示は、ほぼ確実にほとんどのボットで実行されますが、強制しようとしているわけではありません。 WordPress 用の Yoast SEO プラグインをインストールして有効にすると、WordPress ダッシュボードから robots.txt ファイルを直接編集できるようになります。 オールインワン SEO パックは、 WordPress SEOに関して注目すべきもう 1 つの SEO パックであり、使い方も非常に簡単です。 Yoast はそれに似た製品ですが、はるかに軽量です。 メモ帳や TextEdit に数行のテキストを入力して robots.txt ファイルを作成するのと同じくらい簡単です。 ファイルをテストするには、FTP 経由でアップロードしてから、Google Search Console を使用します。

オールインワン SEO パックには、「悪い」ボットをブロックするために使用できるツールが含まれています。 サイトの可視性を高めたい場合は、検索エンジン ボットが最も関連性の高い情報をクロールすることが重要です。 WordPress robots.txt ファイルを使用すると、ボットがサイトと対話する方法を簡単に指定できます。 関連性のある有用なコンテンツを検索エンジンに提示しやすくなります。

WordPress の robots.txt ファイルを更新する方法

Web サイトのルートに物理ファイルが含まれていない場合、WordPress は仮想 robots.txt ファイルを生成します。 仮想ファイルを有効にするには、最初に次の手順に従ってオーバーライドする必要があります。 ブラウザーを開き、Web サイトのルート ディレクトリに移動します。

robots.txt ファイルを確認します。

ファイルに必要な変更を加えてください。

ファイルを保存したかどうかを確認します。

ウェブサイトをリロードする必要があります。

robots.txt ファイルは、左側のサイドバーの [プラグイン] メニューに移動して検索することで更新できます。 メニューから [設定] を選択して、robots.txt ファイルに変更を加えます。