Comment ajouter un fichier Txt Robots à WordPress (en 3 étapes simples)

Publié: 2022-09-21L'ajout d'un fichier robots.txt à votre site WordPress est un processus simple qui peut être effectué en quelques étapes. Un fichier robots.txt est un fichier texte qui indique aux robots des moteurs de recherche quelles pages de votre site Web ils doivent indexer et lesquelles ils doivent ignorer. En excluant certaines pages de l'indexation, vous pouvez améliorer l'optimisation des moteurs de recherche (SEO) de votre site. Il existe plusieurs façons d'ajouter un fichier robots.txt à WordPress. Le plus simple est d'utiliser un plugin comme Yoast SEO ou All in One SEO Pack, qui générera automatiquement un fichier robots.txt pour vous. Alternativement, vous pouvez créer vous-même un fichier robots.txt et le télécharger sur votre site WordPress via FTP. Quelle que soit la méthode que vous choisissez, assurez-vous de tester votre fichier robots.txt avant de le mettre en ligne pour vous assurer qu'il fonctionne comme prévu.

Obtenir une présence dans les moteurs de recherche pour des mots-clés spécifiques est essentiel pour les propriétaires de sites Web car cela garantit que leur site apparaît dans le SERP. Les webmasters peuvent définir le temps que les robots des moteurs de recherche passent sur et hors des sites Web en insérant des instructions dans robots.txt, un fichier spécial. Dans ce didacticiel, je vais vous montrer comment ajouter un fichier "robots.txt" à votre site Web WordPress pour empêcher les moteurs de recherche d'accéder à des parties spécifiques de votre site. Connectez-vous à la plateforme Cloudways en utilisant FileZilla. Vous pouvez créer un nouveau fichier appelé robots.txt dans /applications/ [NOM DU DOSSIER]/public_html. Ouvrez le fichier dans un éditeur de texte (Notepad est une bonne alternative). Les paramètres génériques permettent le téléchargement de certains types de fichiers.

Il n'y a pas de limite aux options/sélections qu'un astérisque (* peut gérer. De plus, si une extension spécifique est sélectionnée, vous pouvez limiter le nombre de fichiers pouvant être désactivés. Robots.txt est un fichier fantastique à utiliser pour le référencement. C'est à vous de décider combien de parties de votre site WordPress vous souhaitez voir apparaître dans le SERP. Si votre site a un sitemap, vous devez inclure une URL pour aider les moteurs de recherche à le localiser. Les répertoires ne sont souvent pas obligés d'être indexés par les moteurs de recherche. Par conséquent, une page peut être indexée beaucoup plus rapidement.

Par conséquent, vous devez inclure robots.txt dans les scripts de votre site Web afin que les moteurs de recherche s'abstiennent d'indexer certaines parties. Si votre site est configuré de manière incorrecte (comme supprimer /), il sera désindexé par Google. Vous devriez être prudent, aussi. Vous avez la possibilité de terminer la tâche. S'il vous plaît dites-moi si vous utilisez ce type de fichier et quels sont les paramètres pour cela.

txt est l'un des formats de fichiers les plus simples à utiliser. Les robots sont programmés pour « Autoriser » (c'est-à-dire les indexer) et « Interdire » (c'est-à-dire les rejeter) en fonction des pages qu'ils veulent voir. Ce dernier ne sera utilisé qu'une seule fois pour lister les pages sur lesquelles vous ne voulez pas que les araignées rampent.

Un fichier texte nommé txt peut être utilisé par un site Web pour fournir des instructions aux robots d'exploration Web. Google et d'autres moteurs de recherche utilisent des robots d'exploration Web , également appelés robots Web, pour archiver et classer les sites Web. Une recherche de robot est généralement utilisée dans les bots.

Robots.txt peut être ajouté à un fichier sur Internet. Pour voir les directives du site Web (si le site a des robots), envoyez l'URL à la fin de n'importe quel domaine racine.

Où puis-je mettre le fichier Txt des robots WordPress ?

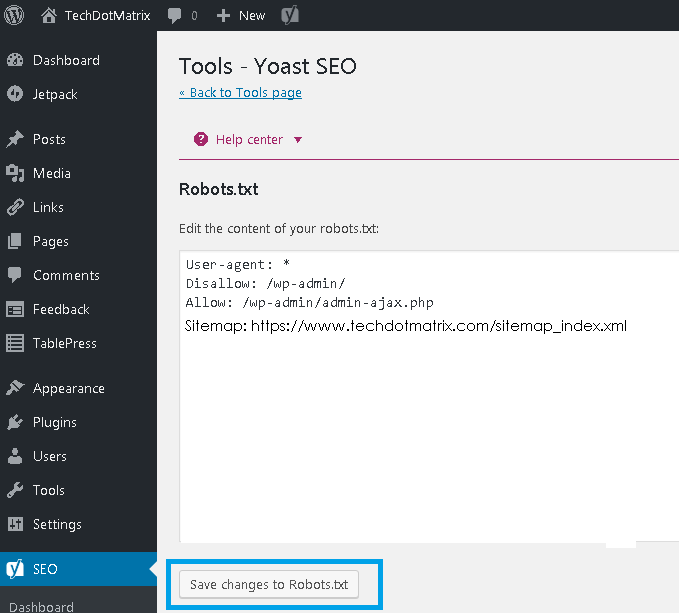

Crédit : www.techdotmatrix.com

Crédit : www.techdotmatrix.comCréez une liste de vos robots FTP en vous rendant dans la section de gauche de votre client FTP (nous utilisons Filezilla). Vous avez enregistré un fichier txt que vous avez précédemment créé sur votre ordinateur. Vous pouvez le télécharger en cliquant dessus avec le bouton droit de la souris et en sélectionnant Télécharger. Le fichier sera téléchargé en quelques instants et vous pourrez le voir dans votre répertoire racine WordPress.

Le fichier robots.txt se trouve dans votre répertoire racine WordPress et est un fichier texte. Pour donner aux robots des moteurs de recherche une idée des pages de votre site Web qu'ils doivent explorer, il affiche une liste des pages qui doivent et ne doivent pas être analysées. Il est possible de demander au fichier d'éviter l'exploration plutôt que l'indexation. Dans les cas où de mauvais robots ont corrompu votre site Web, un bon plugin de sécurité est essentiel. WordPress crée un fichier robots.txt virtuel pour chaque site Web qui l'utilise. Si vous voulez changer quelque chose, vous avez trois options. Le plugin Yoast SEO , l'un des outils les plus populaires pour optimiser les sites Web, est un excellent choix.

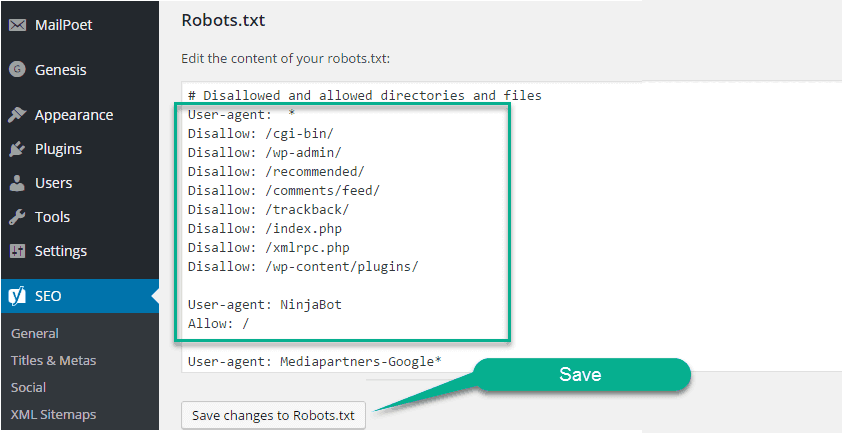

All in One SEO, un autre plugin SEO gratuit, fournit une variété de fonctionnalités supplémentaires. Si vous avez déjà utilisé FTP, vous savez que vous pouvez télécharger des fichiers robots.txt sur votre serveur. Vous verrez une nouvelle section dans le fichier robots.txt appelée Robots.txt où vous pourrez ajouter des règles et des directives au fichier par la suite. User-agent et Disallow sont les deux directives contenues dans ce fichier. Si vous souhaitez spécifier un seul bot (par exemple Bingbot), ou si vous souhaitez que les directives s'appliquent à tous les bots, saisissez un astérisque (User-agent : *). Des requêtes d'exploration excessives surchargent le serveur, ce qui entraîne l'utilisation d'une directive Crawl-delay. Étant donné qu'aucun robot d'exploration ne prend en charge cette directive, il est préférable de l'utiliser avec prudence.

Les moteurs de recherche seront dirigés vers votre fichier de sitemap XML si vous utilisez la directive Sitemap. Dans les sections suivantes, nous allons vous montrer deux exemples d'extraits illustrant l'utilisation des directives robots.txt. Chaque site WordPress a un fichier robots.txt dans son répertoire racine. Dans ce document, les robots d'exploration recevront des instructions sur les sections de votre site Web qu'ils doivent rechercher. Ils doivent, ou ne doivent pas, ramper sur le sol. Au cours de notre discussion, nous avons couvert les moyens de créer une version physique du fichier et comment le modifier.

Devez-vous ajouter un fichier Robots.txt à votre site Web WordPress ?

Dès que WordPress est installé, il génère automatiquement un fichier robots.txt. Un indexeur de moteur de recherche classe ce répertoire pour déterminer quelles pages d'un site sont indexées. Les fichiers Robots.txt n'ont pas besoin d'être ajoutés aux sites Web WordPress dans la plupart des cas. Cependant, pour augmenter votre classement dans les moteurs de recherche, vous pouvez ajouter un fichier robots.txt pour gérer l'index des moteurs de recherche.

Comment ouvrir un fichier Txt Robots dans WordPress ?

Crédit : www.hitechwork.com

Crédit : www.hitechwork.comIl existe plusieurs façons d'ouvrir un fichier robots.txt dans WordPress. Une façon consiste simplement à accéder à votre dossier d'installation WordPress et à ouvrir le fichier dans un éditeur de texte. Une autre façon consiste à utiliser un plugin comme WP Robots Txt pour modifier le fichier depuis la zone d'administration de WordPress.

Il existe un fichier robots.txt sur presque tous les sites Web, mais la plupart des gens ne comprennent pas ce qu'il fait ni comment l'utiliser. Dans ce guide, nous examinerons le fichier et ses restrictions pour savoir comment gérer l'accès à votre site Web. Même si une page a des liens pointant vers elle, elle peut toujours être indexée par les moteurs de recherche si elle est bloquée par robots.txt. Google n'accèdera pas aux zones marquées de votre site. Une balise noindex peut être ajoutée à une page qui n'a pas été bloquée par Google, selon John Mueller, Google Webmaster Analyst. Vous pouvez utiliser le populaire plugin Yoast SEO pour créer (et plus tard modifier) un modèle SEO. Placez votre fichier robots.txt au bon endroit en cliquant avec le bouton droit sur l'interface de Yoast.

De même, vous pouvez implémenter ce type d'intégration dans le plugin All in One SEO. Veuillez continuer à lire pour plus d'informations sur les différents types de directives qui doivent être spécifiées dans votre fichier WordPress robots.html. Avant d'ajouter des règles, vous devez d'abord sélectionner à quel agent utilisateur la règle doit s'appliquer, puis le nombre de règles à appliquer à l'aide de Disallow et Allow. Interdire l'accès à un dossier et à ses dossiers enfants mais autoriser l'accès au dossier spécifique d'un enfant spécifique peut être une bonne idée si vous souhaitez restreindre l'accès à un dossier et à ses dossiers enfants. Autoriser vous permet d'accorder l'accès à un fichier spécifique dans un dossier spécifique mais vous empêche d'accéder à un dossier entier. WordPress utilise un paramètre de requête nommé ?s= lors du traitement des requêtes. Il vous suffit d'ajouter la règle suivante pour configurer un blocage à l'accès.

Les erreurs Soft 404 peuvent également être évitées en utilisant cette fonctionnalité, ainsi qu'en les bloquant si elles se produisent. Même si vous ciblez une région spécifique en dehors des États-Unis, il n'est pas nécessaire d'empêcher Googlebot d'entrer dans le pays. Google est irrité qu'une commande avec un caractère invisible ne soit pas comprise. Dommage que cela invalide la première ligne de notre fichier robots.txt. Ce n'est pas la même chose que d'utiliser une balise noindex dans les fichiers robots.txt, qui sont appelés commandes Disallow. Bots.txt, d'autre part, n'indexe pas, mais il empêche l'exploration. Vous pouvez l'utiliser pour configurer la manière dont les moteurs de recherche et les autres robots interagissent avec votre site Web en ajoutant des règles spécifiques. Il n'est pas nécessaire de modifier le fichier robots.html virtuel par défaut pour la plupart des personnes qui n'utilisent pas du tout WordPress. Vous pouvez cependant ajouter vos propres règles si vous rencontrez des problèmes avec un bot ou un plugin spécifique.

Comment ajouter un fichier Robots.txt à votre site

Si vous utilisez WordPress, vous pouvez facilement ajouter ce fichier à votre site en utilisant l'assistant Ajouter une nouvelle page. Ensuite, dans le champ URL du fichier, saisissez l'URL du fichier robots.txt. Ce fichier peut également être ajouté à une page WordPress en cliquant sur l'élément de menu Gérer les pages dans le tableau de bord.

Si vous n'utilisez pas WordPress, vous devrez peut-être ajouter robots.txt à votre site d'une manière différente. Si vous avez un client FTP installé sur votre ordinateur, vous pouvez facilement ajouter ce fichier ; si vous avez un gestionnaire de fichiers installé sur votre ordinateur, vous pouvez facilement l'ajouter.

Ai-je besoin d'un fichier WordPress Robots Txt ?

Crédit : pressidium.com

Crédit : pressidium.comIl n'y a pas de réponse définitive à cette question, car cela dépend du site WordPress spécifique en question et du type de contenu ou de fonctionnalité dont il dispose. En général, cependant, un fichier robots.txt n'est pas strictement nécessaire pour WordPress, bien qu'il puisse être utile dans certains cas. Par exemple, si un site WordPress contient beaucoup d'informations sensibles ou confidentielles, un fichier robots.txt peut être utilisé pour empêcher les moteurs de recherche d'indexer ce contenu.

Le fichier robots.txt est un simple fichier texte qui indique aux moteurs de recherche où et quand il ne doit pas explorer votre site Web. Vous pouvez empêcher les moteurs de recherche d'accéder à différents fichiers et dossiers sur votre site en utilisant cette fonctionnalité. Dans cet article, nous allons vous montrer comment en créer un et vous donner quelques plugins que nous recommandons, vous permettant de faire le travail vous-même. Chaque moteur de recherche inclut un agent utilisateur d'exploration Web dans ses résultats de recherche. Googlebot, par exemple, indexe le contenu de votre site Web pour le moteur de recherche de Google. Vous avez la possibilité de configurer une instruction personnalisée pour chacun de ces agents utilisateurs. Le fichier robots.txt est accessible en tapant "/robots.txt" après le nom de domaine.

Vous pouvez demander au robot de ne voir aucune page du site après avoir utilisé la barre oblique en suivant le lien. Un crawl budgétaire est défini comme le nombre d'URL qu'un robot de moteur de recherche peut parcourir au cours d'une session. Chaque site Web aura un budget de crawl spécifique en place. Si vous avez beaucoup de pages sur votre site Web, vous devriez vérifier si le bot explore d'abord vos pages les plus précieuses. Le plugin Yoast SEO de WordPress vous permet de créer facilement des fichiers robots.txt à partir de votre tableau de bord. Ensuite, utilisez un client FTP comme Filezilla pour télécharger le fichier manuellement. Si vous souhaitez afficher le fichier sur votre site Web, assurez-vous qu'il se trouve dans le dossier racine.

Pour en créer un, vous devrez utiliser un éditeur de texte comme le Bloc-notes si le fichier n'y est pas. Le fichier robots.txt doit toujours se trouver à la racine de votre site Web. Les moteurs de recherche continueront d'explorer et d'indexer votre site, que vous disposiez ou non de ce fichier. Il est simple de tester votre fichier robots.txt dans la Google Search Console. En cliquant sur "Ajouter une propriété maintenant", vous pouvez ajouter votre site Web à la recherche Google en quelques minutes. Il est essentiel de maintenir un budget de crawl spécifique sur chaque site Web. Vous devez tenir compte du nombre de pages qu'un bot doit visiter au cours d'une session. Si le bot ne termine pas l'exploration de toutes les pages de votre site au cours de la session, il reviendra sur votre site et reprendra l'exploration lors de la session suivante. Une solution rapide consiste à empêcher les robots de recherche d'explorer les pages inutiles, les fichiers multimédias, les plugins, les dossiers de thèmes, etc., économisant ainsi votre quota d'exploration.

Pour faire simple, ajoutez la ligne suivante à votre fichier robots.txt : Agents : users. Le service Googlebot est actuellement utilisé. Si vous n'avez pas de fichier robots.txt, Googlebot explorera vos pages et les indexera automatiquement dans le moteur de recherche.

Pourquoi vous devriez ajouter un fichier Robots.txt pour améliorer votre référencement

Vous pouvez augmenter le classement de votre site Web dans les moteurs de recherche en téléchargeant un fichier robots.txt. Les robots rechercheront ce fichier à la racine de votre site Web pour voir si le contenu est autorisé ou non et pourquoi.

Modifier Robots.txt WordPress

Si vous souhaitez modifier votre fichier robots.txt, vous pouvez le faire en vous rendant sur votre tableau de bord WordPress puis en cliquant sur l'onglet « Paramètres ». De là, vous trouverez la section "Lecture" où vous pourrez modifier votre fichier robots.txt.

Un fichier robots.txt, en plus d'indiquer aux moteurs de recherche où votre site est autorisé à aller, leur indique également comment l'explorer. Si vous demandez à vos robots de ne pas explorer les pages inutiles de votre site, vous pouvez augmenter sa vitesse de chargement et éventuellement vous classer plus haut dans les moteurs de recherche. Dans cet article, nous vous montrerons comment modifier votre fichier robots.html à l'aide de WordPress. Le fichier robots.txt est requis pour certaines raisons. Lors de l'utilisation d'une balise meta noindex au lieu de robots.txt lors du chargement d'un site Web. Pourquoi c'est si important dans nos vies. Bien que le système vous permette de spécifier quels moteurs de recherche et autres bots interagissent avec votre site Web, il n'interdit pas explicitement aux moteurs de recherche ou autres bots d'indexer votre contenu.

Voyons comment éditer les fichiers robots.html dans WordPress étape par étape en utilisant AIOSEO. Le générateur de règles vous permet de créer vos propres règles pour des pages spécifiques que les robots peuvent ou non visiter. Lors de la création d'une règle personnalisée, vous pouvez saisir l'agent utilisateur (par exemple, Googlebot crawler ) dans le champ Agents utilisateur. Vous devez entrer le chemin du répertoire ou le nom du fichier dans le champ Chemin du répertoire après avoir déterminé quels bots doivent être autorisés ou refusés. Si vous enregistrez vos nouvelles règles, elles seront visibles dans la section Aperçu Robots.txt. Vous pouvez voir votre fichier robots.txt en cliquant sur Open Robots. Ce texte sera envoyé sur votre appareil mobile dès qu'il sera disponible. En tapant simplement les détails de vos règles, vous pouvez les modifier. Quelques exemples de règles de suppression seraient présentés dans une section distincte.

Robots.txt par défaut pour WordPress

Si vous créez un site WordPress et ne créez pas de fichier robots.txt personnalisé, votre site générera automatiquement un fichier robots.txt par défaut qui comprend les éléments suivants : User-agent : * Disallow : / La première ligne, User-agent : * , s'applique à tous les robots d'exploration Web . La deuxième ligne, Disallow: /, indique à tous les robots d'indexation de ne pas indexer les pages de votre site. C'est le paramètre le plus restrictif et il n'est pas recommandé pour la plupart des sites WordPress.

L'utilisation d'un fichier robots.txt bien structuré vous permettra de diriger les robots des moteurs de recherche vers votre site Web. On leur dit de garder leurs distances avec ces pièces pendant qu'ils les regardent. Même si vous n'êtes pas un assistant technique, vous pouvez créer ce fichier pour répondre à vos besoins, même si vous ne connaissez aucun codage. Lorsque vous créez un site Web WordPress, il crée un fichier robots.txt virtuel pour vous. Les bots ne peuvent pas accéder aux répertoires administrateur et WP-includes basés sur ce fichier. Pour apporter des modifications, vous devez d'abord créer un nouveau fichier, puis le télécharger dans le dossier racine. Robots.txt peut être modifié dans WordPress de deux manières : via un plugin ou manuellement.

Nous avons créé un nouvel ensemble de règles pour empêcher le robot de recherche de Bing d'explorer notre site dans cet exemple. Vos instructions dans ce fichier seront presque certainement suivies par la plupart des bots, mais vous n'essayez pas de les forcer à le faire. Après avoir installé et activé le plugin Yoast SEO pour WordPress, vous pourrez modifier les fichiers robots.txt directement depuis le tableau de bord WordPress. Le pack SEO tout-en-un est l'autre pack SEO à surveiller en matière de référencement WordPress , et il est également très simple à utiliser. Yoast est un produit similaire, mais il est beaucoup plus léger. C'est aussi simple que de taper quelques lignes de texte dans le Bloc-notes ou TextEdit pour créer un fichier robots.txt. Pour tester le fichier, téléchargez-le via FTP, puis utilisez Google Search Console.

Le pack SEO All In One comprend un outil qui peut être utilisé pour bloquer les "mauvais" bots. Si vous souhaitez augmenter la visibilité de votre site, il est essentiel que les robots des moteurs de recherche explorent les informations les plus pertinentes. Les fichiers WordPress robots.txt permettent de spécifier simplement comment vos bots interagissent avec votre site. Il leur sera plus facile de présenter un contenu pertinent et utile aux moteurs de recherche.

Comment mettre à jour votre fichier WordPress Robots.txt

Si la racine du site Web ne contient pas de fichier physique, WordPress génère un fichier robots.txt virtuel. Pour activer le fichier virtuel, vous devez d'abord le remplacer en suivant ces étapes : Ouvrez votre navigateur et accédez au répertoire racine de votre site Web.

Vérifiez le fichier robots.txt.

Veuillez apporter les modifications nécessaires au fichier.

Vérifiez si vous avez enregistré le fichier.

Votre site Web doit être rechargé.

Le fichier robots.txt peut être mis à jour en allant dans le menu "Plugins" dans la barre latérale gauche et en le recherchant. Apportez des modifications au fichier robots.txt en sélectionnant "Paramètres" dans le menu.