Como adicionar um arquivo Txt de robôs ao WordPress (em 3 etapas simples)

Publicados: 2022-09-21Adicionar um arquivo robots.txt ao seu site WordPress é um processo simples que pode ser feito em algumas etapas. Um arquivo robots.txt é um arquivo de texto que informa aos rastreadores de mecanismos de pesquisa quais páginas do seu site devem ser indexadas e quais devem ser ignoradas. Ao excluir determinadas páginas da indexação, você pode melhorar a otimização do mecanismo de pesquisa (SEO) do seu site. Existem algumas maneiras diferentes de adicionar um arquivo robots.txt ao WordPress. A maneira mais fácil é usar um plugin como Yoast SEO ou All in One SEO Pack, que irá gerar automaticamente um arquivo robots.txt para você. Como alternativa, você mesmo pode criar um arquivo robots.txt e enviá-lo para o seu site WordPress via FTP. Seja qual for o método escolhido, certifique-se de testar seu arquivo robots.txt antes de torná-lo ativo para garantir que ele esteja funcionando conforme o esperado.

Obter uma presença nos mecanismos de pesquisa para palavras-chave específicas é essencial para os proprietários de sites, pois garante que seu site apareça na SERP. Os webmasters podem definir a quantidade de tempo que os robôs dos mecanismos de pesquisa passam dentro e fora de sites inserindo instruções em robots.txt, um arquivo especial. Neste tutorial, mostrarei como adicionar um arquivo 'robots.txt' ao seu site WordPress para impedir que os mecanismos de pesquisa acessem partes específicas do seu site. Conecte-se à plataforma Cloudways usando o FileZilla. Você pode criar um novo arquivo chamado robots.txt em /applications/ [FOLDER NAME]/public_html. Abra o arquivo em um editor de texto (o Bloco de Notas é uma boa alternativa). As configurações de curinga permitem o download de certos tipos de arquivos.

Não há limite para as opções/seleções que um asterisco (* pode manipular. Além disso, se uma extensão específica for selecionada, você pode limitar o número de arquivos que podem ser desativados. Robots.txt é um arquivo fantástico para usar em SEO Você decide quantas partes do seu site WordPress deseja que apareçam na SERP. Se o seu site tiver um mapa do site, você deve incluir um URL para ajudar os mecanismos de pesquisa a localizá-lo. Frequentemente, os diretórios não precisam ser indexados pelos motores de busca. Como resultado, uma página pode ser indexada muito mais rápido.

Como resultado, você deve incluir o robots.txt nos scripts do seu site para que os mecanismos de pesquisa se abstenham de indexar determinadas partes. Se seu site estiver configurado incorretamente (como delete /), ele será desindexado pelo Google. Você também deve ser cauteloso. Você tem a oportunidade de completar a tarefa. Por favor, diga-me se você usa esse tipo de arquivo e quais são as configurações para ele.

txt é um dos formatos de arquivo mais simples de usar. Os robôs são programados para “Permitir” (ou seja, indexá-los) e “Não permitir” (ou seja, rejeitá-los) com base nas páginas que desejam ver. O último será usado apenas uma vez para listar as páginas nas quais você não deseja que os spiders rastreiem.

Um arquivo de texto chamado txt pode ser usado por um site para fornecer instruções aos bots de rastreamento da web. O Google e outros mecanismos de pesquisa usam o rastreador da Web , também conhecido como robôs da Web, para arquivar e categorizar sites. Uma pesquisa de robô é normalmente usada nos bots.

Robots.txt pode ser adicionado a um arquivo na Internet. Para ver as diretivas do site (se o site tiver robôs), envie a URL para o final de qualquer domínio raiz.

Onde coloco o arquivo txt de robôs WordPress?

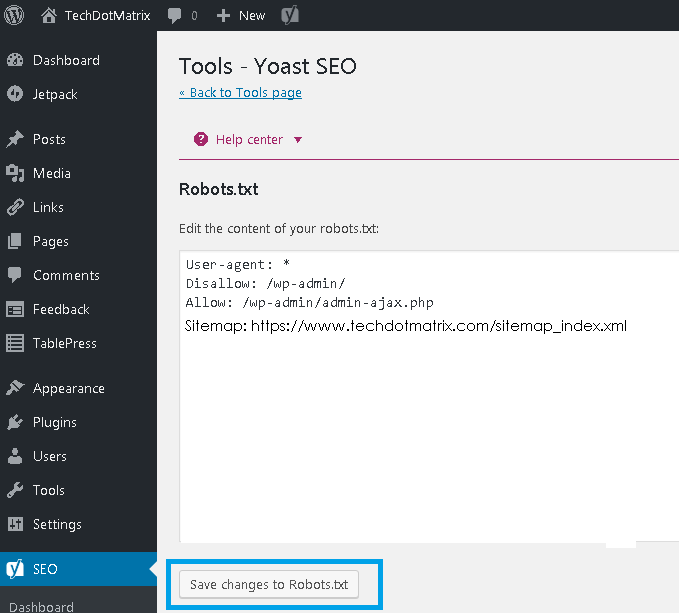

Crédito: www.techdotmatrix.com

Crédito: www.techdotmatrix.comCrie uma lista de seus robôs FTP indo para a seção à esquerda do seu cliente FTP (estamos usando o Filezilla). Você salvou um arquivo txt que você criou anteriormente em seu computador. Você pode carregá-lo clicando com o botão direito do mouse e selecionando Carregar. O arquivo será carregado em instantes e você poderá vê-lo em seu diretório raiz do WordPress.

O arquivo robots.txt está localizado no diretório raiz do WordPress e é um arquivo de texto. Para dar aos bots de busca uma ideia de quais páginas do seu site eles devem rastrear, ele exibe uma lista de quais páginas devem e não devem ser rastreadas. É possível instruir o arquivo para evitar rastreamento, em vez de indexação. Nos casos em que bots ruins corromperam seu site, um bom plug-in de segurança é essencial. O WordPress cria um arquivo robots.txt virtual para cada site que o utiliza. Se você quiser mudar alguma coisa, você tem três opções. O plugin Yoast SEO , uma das ferramentas mais populares para otimizar sites, é uma excelente escolha.

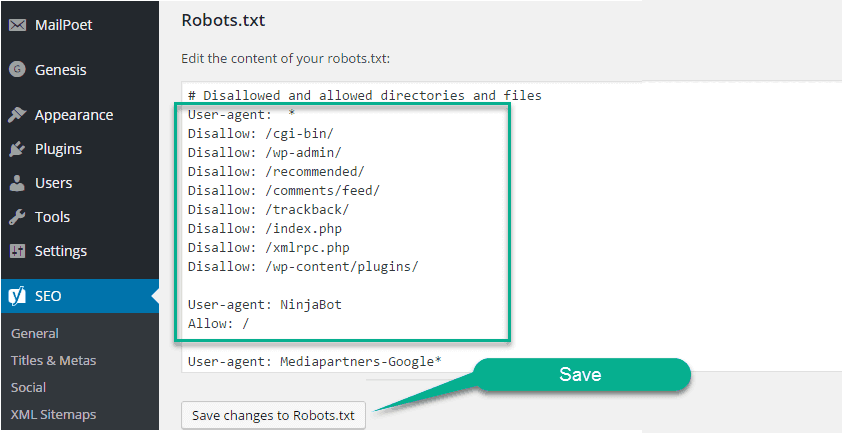

O All in One SEO, outro plugin de SEO gratuito, oferece uma variedade de recursos adicionais. Se você já usou FTP antes, sabe que pode fazer upload de arquivos robots.txt para seu servidor. Você verá uma nova seção no arquivo robots.txt chamada Robots.txt, na qual poderá adicionar regras e diretivas ao arquivo posteriormente. User-agent e Disallow são diretivas contidas neste arquivo. Se você deseja especificar um único bot (por exemplo, Bingbot), ou se deseja que as diretivas se apliquem a todos os bots, insira um asterisco (User-agent: *). Solicitações de rastreamento excessivas sobrecarregam o servidor, resultando no uso de uma diretiva de atraso de rastreamento. Como não há rastreadores que suportem essa diretiva, é melhor usá-la com cautela.

Os mecanismos de pesquisa serão direcionados para o arquivo XML do sitemap se você usar a diretiva Sitemap. Nas seções a seguir, mostraremos dois snippets de amostra que demonstram o uso das diretivas robots.txt. Cada site WordPress tem um arquivo robots.txt em seu diretório raiz. Nele, os rastreadores receberão instruções sobre quais seções do seu site eles devem pesquisar. Eles devem, ou não, rastejar sobre o chão. Durante nossa discussão, abordamos maneiras de criar uma versão física do arquivo e como editá-lo.

Você deve adicionar um arquivo Robots.txt ao seu site WordPress?

Assim que o WordPress for instalado, ele gerará automaticamente um arquivo robots.txt. Um indexador de mecanismo de pesquisa arquiva esse diretório para determinar quais páginas em um site são indexadas. Os arquivos Robots.txt não precisam ser adicionados aos sites do WordPress na maioria dos casos. No entanto, para aumentar as classificações do seu mecanismo de pesquisa, você pode adicionar um arquivo robots.txt para gerenciar o índice do mecanismo de pesquisa.

Como faço para abrir um arquivo txt de robôs no WordPress?

Crédito: http://www.hitechwork.com

Crédito: http://www.hitechwork.comExistem algumas maneiras de abrir um arquivo robots.txt no WordPress. Uma maneira é simplesmente acessar a pasta de instalação do WordPress e abrir o arquivo em um editor de texto. Outra maneira é usar um plugin como o WP Robots Txt para editar o arquivo dentro da área de administração do WordPress.

Há um arquivo robots.txt encontrado em quase todos os sites, mas a maioria das pessoas não entende o que ele faz ou como usá-lo. Neste guia, veremos o arquivo e suas restrições para saber como gerenciar o acesso ao seu site. Mesmo que uma página tenha links apontando para ela, ela ainda poderá ser indexada pelos mecanismos de pesquisa se for bloqueada pelo robots.txt. O Google não acessará as áreas marcadas em seu site. Uma tag noindex pode ser adicionada a uma página que não foi bloqueada pelo Google, de acordo com John Mueller, analista de webmasters do Google. Você pode usar o popular plugin Yoast SEO para criar (e depois editar) um modelo de SEO. Coloque seu arquivo robots.txt no local apropriado clicando com o botão direito do mouse na interface do Yoast.

Da mesma forma, você pode implementar esse tipo de integração no plugin All in One SEO. Continue lendo para obter mais informações sobre os diferentes tipos de diretivas que devem ser especificadas em seu arquivo robots.html do WordPress. Antes de adicionar regras, você deve primeiro selecionar a qual User-agent a regra deve ser aplicada, seguido de quantas regras aplicar usando Disallow e Allow. Não permitir o acesso a uma pasta e suas pastas filhas, mas permitir o acesso à pasta específica de um filho específico pode ser uma boa ideia se você quiser restringir o acesso a uma pasta e suas pastas filhas. Permitir permite que você conceda acesso a um arquivo específico dentro de uma pasta específica, mas impede que você acesse uma pasta inteira. O WordPress usa um parâmetro de consulta chamado?s= ao lidar com consultas. Você só precisa adicionar a seguinte regra para configurar um bloqueio de acesso.

Erros soft 404 também podem ser evitados usando esse recurso, bem como bloqueando-os se ocorrerem. Mesmo se você estiver segmentando uma região específica fora dos Estados Unidos, não é necessário bloquear a entrada do Googlebot no país. O Google está irritado porque um comando com um caractere invisível não está sendo entendido. É uma pena que isso invalide a primeira linha do nosso arquivo robots.txt. Não é o mesmo que usar uma tag noindex em arquivos robots.txt, que são chamados de comandos Disallow. Bots.txt, por outro lado, não indexa, mas impede o rastreamento. Você pode usá-lo para configurar como os mecanismos de pesquisa e outros bots interagem com seu site adicionando regras específicas. Não é necessário alterar o arquivo virtual robots.html padrão para a maioria das pessoas que não usam o WordPress. Você pode, no entanto, adicionar suas próprias regras se tiver problemas com um bot ou plug-in específico.

Como adicionar um arquivo Robots.txt ao seu site

Se você estiver usando o WordPress, poderá adicionar facilmente esse arquivo ao seu site usando o assistente Adicionar nova página. Em seguida, no campo URL do arquivo, insira o URL do arquivo robots.txt. Este arquivo também pode ser adicionado a uma página do WordPress clicando no item de menu Gerenciar Páginas no painel.

Se você não usa o WordPress, pode ser necessário adicionar o robots.txt ao seu site de uma maneira diferente. Se você tiver um cliente FTP instalado em seu computador, poderá adicionar este arquivo facilmente; se você tiver um gerenciador de arquivos instalado em seu computador, poderá adicioná-lo facilmente.

Preciso de um arquivo txt de robôs WordPress?

Crédito: pressidium.com

Crédito: pressidium.comNão há uma resposta definitiva para essa pergunta, pois depende do site específico do WordPress em questão e do tipo de conteúdo ou funcionalidade que ele possui. Em geral, no entanto, um arquivo robots.txt não é estritamente necessário para o WordPress, embora possa ser útil em alguns casos. Por exemplo, se um site WordPress tiver muitas informações sensíveis ou confidenciais, um arquivo robots.txt pode ser usado para impedir que os mecanismos de pesquisa indexem esse conteúdo.

O arquivo robots.txt é um arquivo de texto simples que informa aos mecanismos de pesquisa onde e quando não devem rastrear seu site. Você pode impedir que os mecanismos de pesquisa acessem diferentes arquivos e pastas em seu site usando esse recurso. Neste artigo, mostraremos como criar um e forneceremos alguns plugins que recomendamos, permitindo que você faça o trabalho sozinho. Cada mecanismo de pesquisa inclui um agente de usuário de rastreamento da Web em seus resultados de pesquisa. O Googlebot, por exemplo, indexa o conteúdo do seu site para o mecanismo de pesquisa do Google. Você tem a opção de configurar uma instrução personalizada para cada um desses agentes do usuário. O arquivo robots.txt pode ser acessado digitando '/robots.txt' após o nome do domínio.

Você pode instruir o robô a não visualizar nenhuma página no site após resgatar a barra seguindo o link. Um rastreamento de orçamento é definido como o número de URLs que um bot de mecanismo de pesquisa pode rastrear em uma sessão. Cada site terá um orçamento de rastreamento específico. Se você tiver muitas páginas em seu site, verifique primeiro se o bot está rastreando suas páginas mais valiosas. O plugin Yoast SEO do WordPress permite que você crie facilmente arquivos robots.txt a partir do seu painel. Em seguida, use um cliente FTP como o Filezilla para carregar o arquivo manualmente. Se você deseja exibir o arquivo em seu site, verifique se ele está na pasta raiz.

Para criar um, você precisará usar um editor de texto como o Bloco de Notas se o arquivo não estiver lá. O arquivo robots.txt deve estar sempre localizado na raiz do seu site. Os mecanismos de pesquisa continuarão a rastrear e indexar seu site, independentemente de você ter esse arquivo ou não. É simples testar seu arquivo robots.txt no Google Search Console. Ao clicar em "Adicionar propriedade agora", você pode adicionar seu site à Pesquisa Google em questão de minutos. É fundamental manter um orçamento de rastreamento específico em cada site. Você deve contabilizar o número de páginas que um bot deve visitar durante uma sessão. Se o bot não concluir o rastreamento de todas as páginas do seu site durante a sessão, ele retornará ao seu site e retomará o rastreamento na próxima sessão. Uma solução rápida é impedir que os bots de pesquisa rastreiem páginas desnecessárias, arquivos de mídia, plugins, pastas de temas e assim por diante, economizando assim sua cota de rastreamento.

Para simplificar, adicione a seguinte linha ao seu arquivo robots.txt: Agents: users. O serviço Googlebot está atualmente em uso. Se você não tiver um arquivo robots.txt, o Googlebot rastreará suas páginas e as indexará automaticamente no mecanismo de pesquisa.

Por que você deve adicionar um arquivo Robots.txt para melhorar seu SEO

Você pode aumentar a classificação do seu site no mecanismo de pesquisa baixando um arquivo robots.txt. Os rastreadores procurarão esse arquivo na raiz do seu site para ver se o conteúdo é permitido ou não e por quê.

Editar Robots.txt WordPress

Se você deseja editar seu arquivo robots.txt, pode fazê-lo acessando o painel do WordPress e clicando na guia “Configurações”. A partir daí, você encontrará a seção “Leitura”, onde poderá editar seu arquivo robots.txt.

Um arquivo robots.txt, além de informar aos mecanismos de pesquisa onde seu site pode ir, também informa como rastreá-lo. Se você instruir seus bots a não rastrear páginas desnecessárias em seu site, você pode aumentar sua velocidade de carregamento e possivelmente ter uma classificação mais alta nos mecanismos de pesquisa. Neste post, mostraremos como editar seu arquivo robots.html usando o WordPress. O arquivo robots.txt é necessário por alguns motivos. Ao usar uma meta tag noindex em vez de robots.txt ao carregar um site. Por que isso importa tanto em nossas vidas. Embora o sistema permita que você especifique quais mecanismos de pesquisa e outros bots interagem com seu site, ele não proíbe explicitamente que mecanismos de pesquisa ou outros bots indexem seu conteúdo.

Vamos dar uma olhada em como editar arquivos robots.html no WordPress passo a passo usando AIOSEO. O construtor de regras permite que você crie suas próprias regras para páginas específicas que os robôs podem ou não visitar. Ao criar uma regra personalizada, você pode inserir o User Agent (por exemplo, o rastreador do Googlebot ) no campo User Agents. Você deve inserir o caminho do diretório ou o nome do arquivo no campo Caminho do diretório após determinar quais bots devem ser permitidos ou negados. Se você salvar suas novas regras, elas ficarão visíveis na seção Visualização do Robots.txt. Você pode ver seu arquivo robots.txt clicando em Open Robots. Este texto será enviado para o seu dispositivo móvel assim que estiver disponível. Apenas digitando os detalhes de suas regras, você pode modificá-las. Alguns exemplos de regras de exclusão seriam mostrados em uma seção separada.

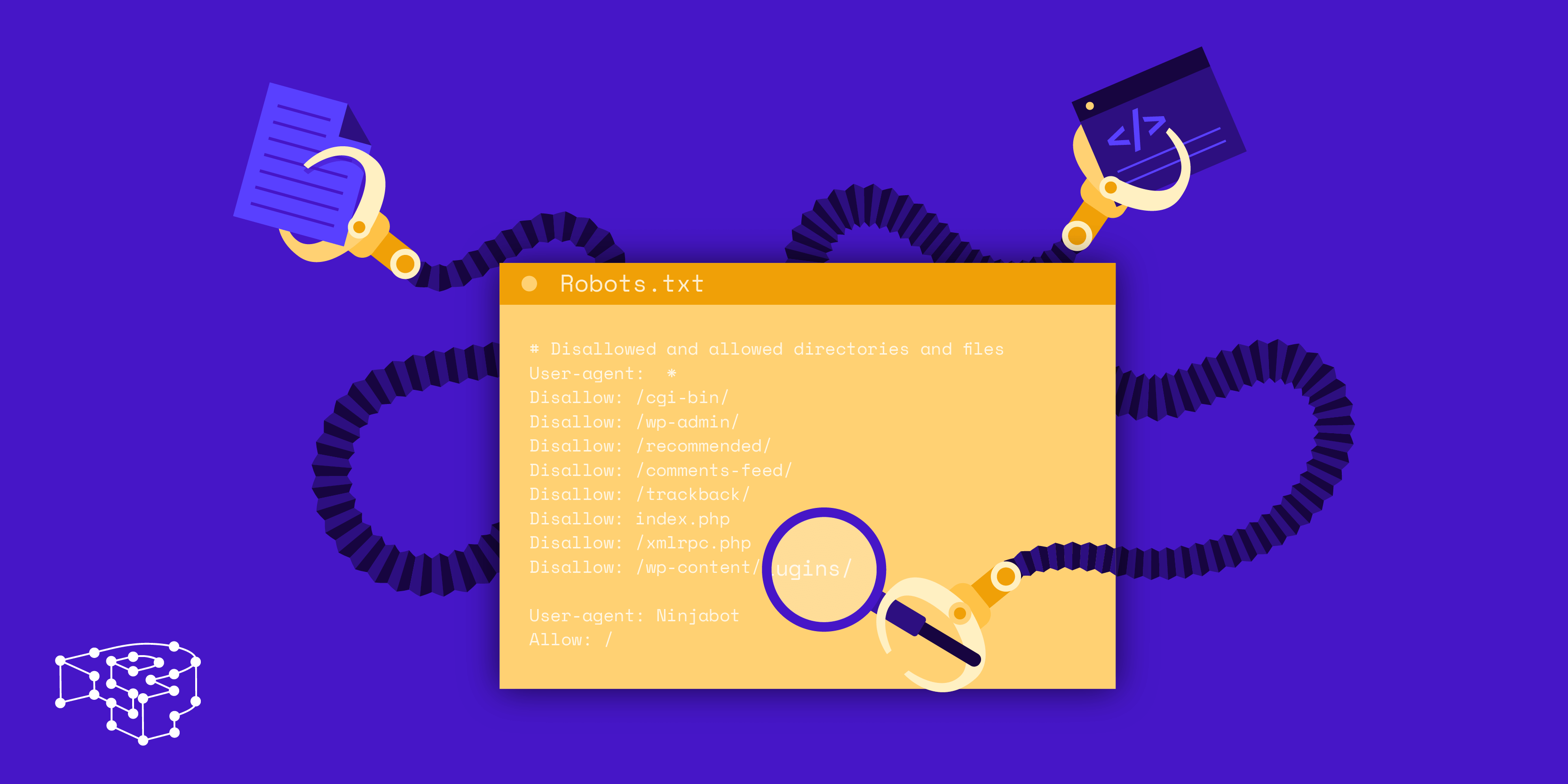

Robots.txt padrão para WordPress

Se você criar um site WordPress e não criar um arquivo robots.txt personalizado, seu site gerará automaticamente um arquivo robots.txt padrão que inclui o seguinte: User-agent: * Disallow: / A primeira linha, User-agent: * , se aplica a todos os rastreadores da Web . A segunda linha, Disallow: /, instrui todos os rastreadores da Web a não indexar nenhuma página em seu site. Esta é a configuração mais restritiva e não é recomendada para a maioria dos sites WordPress.

O uso de um arquivo robots.txt bem estruturado permitirá que você direcione os bots dos mecanismos de pesquisa para o seu site. Eles estão sendo instruídos a manter distância desses quartos enquanto olham para eles. Mesmo que você não seja um assistente técnico, você pode criar este arquivo para atender às suas necessidades, mesmo que não conheça nenhuma codificação. Quando você cria um site WordPress, ele cria um arquivo virtual robots.txt para você. Os bots são impedidos de acessar o administrador e os diretórios incluídos no WP com base nesse arquivo. Para fazer alterações, você deve primeiro criar um novo arquivo e depois carregá-lo na pasta raiz. Robots.txt pode ser editado no WordPress de duas maneiras: através de um plugin ou manualmente.

Criamos um novo conjunto de regras para impedir que o bot de pesquisa do Bing rastreie nosso site neste exemplo. Suas instruções neste arquivo quase certamente serão seguidas pela maioria dos bots, mas você não está tentando forçá-los a fazê-lo. Depois de instalar e ativar o plugin Yoast SEO para WordPress, você poderá editar arquivos robots.txt diretamente do painel do WordPress. O All-in-One SEO Pack é o outro pacote de SEO a ser observado quando se trata de SEO para WordPress , e também é muito simples de usar. Yoast é um produto semelhante a ele, mas é muito mais leve. É tão simples quanto digitar algumas linhas de texto no Bloco de Notas ou TextEdit para criar um arquivo robots.txt. Para testar o arquivo, carregue-o via FTP e use o Google Search Console.

O All In One SEO Pack inclui uma ferramenta que pode ser usada para bloquear bots “ruins”. Se você deseja aumentar a visibilidade do seu site, é fundamental que os bots dos mecanismos de pesquisa rastreiem as informações mais relevantes. Os arquivos robots.txt do WordPress simplificam a especificação de como seus bots interagem com seu site. Será mais fácil para eles apresentar conteúdo relevante e útil para os motores de busca.

Como atualizar seu arquivo WordPress Robots.txt

Se a raiz do site não contém um arquivo físico, o WordPress gera um arquivo virtual robots.txt. Para habilitar o arquivo virtual, você deve primeiro substituí-lo seguindo estas etapas: Abra seu navegador e navegue até o diretório raiz do seu site.

Verifique o arquivo robots.txt.

Faça as alterações necessárias no arquivo.

Verifique se você salvou o arquivo.

Seu site deve ser recarregado.

O arquivo robots.txt pode ser atualizado acessando o menu 'Plugins' na barra lateral esquerda e procurando por ele. Faça as alterações no arquivo robots.txt selecionando 'Configurações' no menu.