Jak dodać plik tekstowy robota do WordPressa (w 3 prostych krokach)

Opublikowany: 2022-09-21Dodanie pliku robots.txt do witryny WordPress to prosty proces, który można wykonać w kilku krokach. Plik robots.txt to plik tekstowy, który informuje roboty wyszukiwarek, które strony w Twojej witrynie powinny zaindeksować, a które zignorować. Wykluczając niektóre strony z indeksowania, możesz poprawić optymalizację witryny pod kątem wyszukiwarek (SEO). Istnieje kilka różnych sposobów dodania pliku robots.txt do WordPressa. Najprostszym sposobem jest użycie wtyczki, takiej jak Yoast SEO lub All in One SEO Pack, która automatycznie wygeneruje dla Ciebie plik robots.txt. Możesz też samodzielnie utworzyć plik robots.txt i przesłać go do witryny WordPress przez FTP. Niezależnie od wybranej metody, przetestuj plik robots.txt przed jego udostępnieniem, aby upewnić się, że działa zgodnie z przeznaczeniem.

Uzyskanie obecności w wyszukiwarkach dla określonych słów kluczowych jest niezbędne dla właścicieli witryn, ponieważ zapewnia, że ich witryna pojawi się w SERP. Webmasterzy mogą określić, ile czasu roboty wyszukiwarek spędzają na stronach internetowych i poza nimi, wstawiając instrukcje do robots.txt, specjalnego pliku. W tym samouczku pokażę, jak dodać plik „robots.txt” do witryny WordPress, aby uniemożliwić wyszukiwarkom dostęp do określonych części witryny. Połącz się z platformą Cloudways za pomocą FileZilla. Możesz utworzyć nowy plik o nazwie robots.txt w /applications/ [NAZWA FOLDERU]/public_html. Otwórz plik w edytorze tekstu (Dobrą alternatywą jest Notatnik). Ustawienia blankietów pozwalają na pobieranie określonych typów plików.

Nie ma ograniczeń co do opcji/wyborów, które może obsłużyć gwiazdka (*. Ponadto, jeśli wybierzesz określone rozszerzenie, możesz ograniczyć liczbę plików, które można wyłączyć. Robots.txt to fantastyczny plik do wykorzystania w SEO do celów. To od Ciebie zależy, ile części Twojej witryny WordPress ma pojawiać się w SERP. Jeśli Twoja witryna ma mapę witryny, powinieneś dołączyć adres URL, aby pomóc wyszukiwarkom w jej zlokalizowaniu. Katalogi często nie muszą być indeksowane przez wyszukiwarki, dzięki czemu strona może być indeksowana znacznie szybciej.

W rezultacie musisz dołączyć plik robots.txt do skryptów swojej witryny, aby wyszukiwarki powstrzymały się od indeksowania niektórych części. Jeśli Twoja witryna jest nieprawidłowo skonfigurowana (np. usuń /), zostanie zdeindeksowana przez Google. Ty też powinieneś być ostrożny. Masz możliwość wykonania zadania. Proszę mi powiedzieć, czy używasz tego typu pliku i jakie są dla niego ustawienia.

txt to jeden z najprostszych w użyciu formatów plików. Roboty są zaprogramowane na „Zezwalaj” (tj. indeksują je) i „Nie zezwalaj” (tj. Odrzucaj je) w zależności od tego, które strony chcą oglądać. Ta ostatnia zostanie użyta tylko raz, aby wyświetlić listę stron, po których nie chcesz indeksować pająków.

Witryna może użyć pliku tekstowego o nazwie txt, aby przekazać instrukcje robotom indeksującym sieć. Google i inne wyszukiwarki używają robota indeksującego , znanego również jako roboty internetowe, do archiwizowania i kategoryzowania witryn. Wyszukiwanie robota jest zwykle używane w botach.

Robots.txt można dodać do pliku w Internecie. Aby zobaczyć dyrektywy witryny (jeśli witryna ma roboty), wpisz adres URL na koniec dowolnej domeny głównej.

Gdzie umieścić plik tekstowy robotów WordPress?

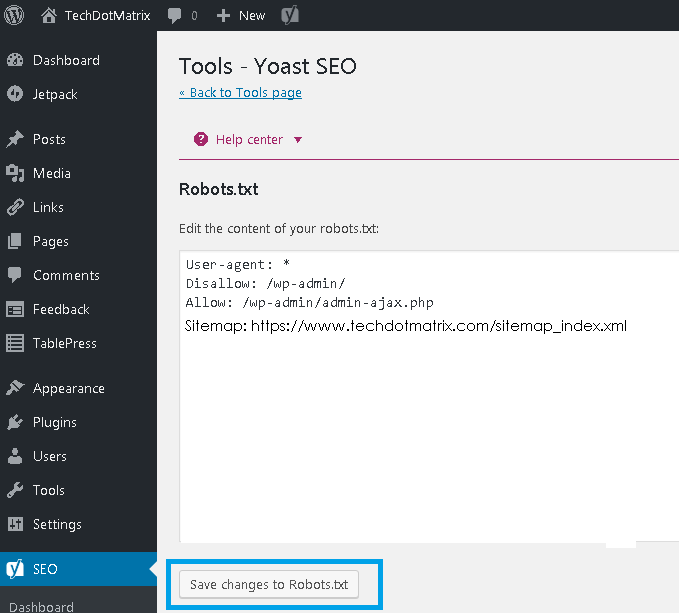

Źródło: www.techdotmatrix.com

Źródło: www.techdotmatrix.comUtwórz listę swoich robotów FTP , przechodząc do lewej części klienta FTP (my używamy Filezilla). Zapisałeś plik txt, który wcześniej utworzyłeś na swoim komputerze. Możesz go przesłać, klikając go prawym przyciskiem myszy i wybierając Prześlij. Plik zostanie przesłany w ciągu kilku chwil i będzie można go zobaczyć w głównym katalogu WordPress.

Plik robots.txt znajduje się w głównym katalogu WordPress i jest plikiem tekstowym. Aby dać botom wyszukiwarek wyobrażenie o tym, które strony w Twojej witrynie powinny indeksować, wyświetla listę stron, które powinny, a które nie powinny być indeksowane. Możliwe jest poinstruowanie pliku, aby unikał indeksowania zamiast indeksowania. W przypadkach, gdy złe boty uszkodziły Twoją witrynę, niezbędna jest dobra wtyczka bezpieczeństwa. WordPress tworzy wirtualny plik robots.txt dla każdej witryny, która z niego korzysta. Jeśli chcesz coś zmienić, masz trzy możliwości. Wtyczka Yoast SEO , jedno z najpopularniejszych narzędzi do optymalizacji stron internetowych, to doskonały wybór.

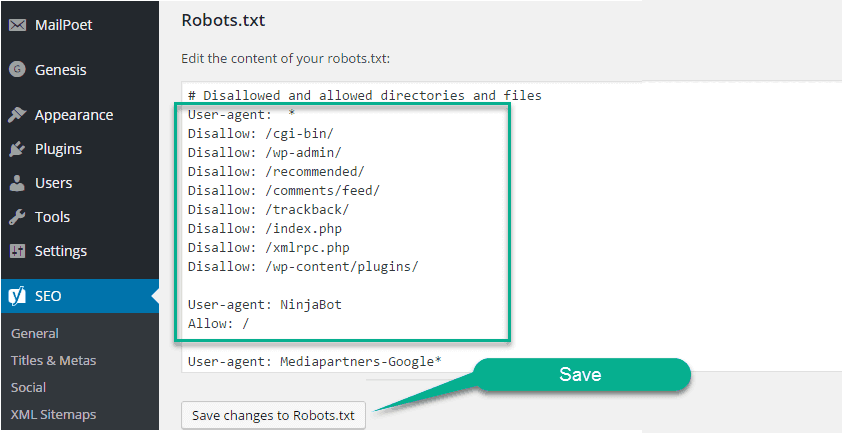

All in One SEO, kolejna darmowa wtyczka SEO, zapewnia szereg dodatkowych funkcji. Jeśli wcześniej korzystałeś z FTP, wiesz, że możesz przesłać pliki robots.txt na swój serwer. Zobaczysz nową sekcję w pliku robots.txt o nazwie Robots.txt, w której możesz później dodać do pliku reguły i dyrektywy. User-agent i Disallow to obie dyrektywy zawarte w tym pliku. Jeśli chcesz określić pojedynczego bota (np. Bingbot) lub jeśli chcesz, aby dyrektywy dotyczyły wszystkich botów, wpisz gwiazdkę (User-agent: *). Nadmierna liczba żądań indeksowania przeciąża serwer, co skutkuje użyciem dyrektywy Crawl-delay. Ponieważ nie ma robotów obsługujących tę dyrektywę, najlepiej jest używać jej ostrożnie.

Wyszukiwarki zostaną przekierowane do pliku mapy witryny XML, jeśli użyjesz dyrektywy Sitemap. W kolejnych sekcjach pokażemy dwa przykładowe fragmenty kodu demonstrujące użycie dyrektyw w pliku robots.txt. Każda witryna WordPress ma w swoim katalogu głównym plik robots.txt. W nim roboty indeksujące otrzymają instrukcje dotyczące tego, które sekcje Twojej witryny powinny przeszukiwać. Powinny lub nie powinny czołgać się po ziemi. Podczas naszej dyskusji omówiliśmy sposoby tworzenia fizycznej wersji pliku i sposobu jej edycji.

Czy powinieneś dodać plik Robots.txt do swojej witryny WordPress?

Jak tylko WordPress zostanie zainstalowany, automatycznie wygeneruje plik robots.txt. Indeksator wyszukiwarki zapisuje ten katalog, aby określić, które strony w witrynie są indeksowane. W większości przypadków pliki robots.txt nie muszą być dodawane do witryn WordPress. Jednak, aby zwiększyć rankingi w wyszukiwarkach, możesz dodać plik robots.txt do zarządzania indeksem wyszukiwarek.

Jak otworzyć plik tekstowy robota w WordPress?

Źródło: www.hitechwork.com

Źródło: www.hitechwork.comIstnieje kilka sposobów otwierania pliku robots.txt w WordPressie. Jednym ze sposobów jest po prostu przejście do folderu instalacyjnego WordPress i otwarcie pliku w edytorze tekstu. Innym sposobem jest użycie wtyczki, takiej jak WP Robots Txt , do edycji pliku z poziomu obszaru administracyjnego WordPress.

Prawie na każdej stronie internetowej znajduje się plik robots.txt, ale większość ludzi nie rozumie, do czego służy i jak z niego korzystać. W tym przewodniku przyjrzymy się plikowi i jego ograniczeniom, aby dowiedzieć się, jak zarządzać dostępem do witryny. Nawet jeśli strona zawiera odsyłające do niej linki, nadal może być indeksowana przez wyszukiwarki, jeśli jest zablokowana przez plik robots.txt. Google nie uzyska dostępu do zaznaczonych obszarów w Twojej witrynie. Według Johna Muellera, Google Webmaster Analyst, do strony, która nie została zablokowana przez Google, można dodać tag noindex. Możesz użyć popularnej wtyczki Yoast SEO, aby utworzyć (a później edytować) szablon SEO. Umieść plik robots.txt we właściwym miejscu, klikając prawym przyciskiem myszy interfejs Yoast.

Podobnie możesz zaimplementować ten rodzaj integracji we wtyczce All in One SEO. Czytaj dalej, aby uzyskać więcej informacji na temat różnych typów dyrektyw, które muszą być określone w pliku robots.html WordPress. Przed dodaniem reguł musisz najpierw wybrać klienta użytkownika, którego reguła ma dotyczyć, a następnie liczbę reguł, które mają być zastosowane przy użyciu opcji Zabroń i Zezwól. Odmowa dostępu do folderu i jego folderów podrzędnych, ale zezwolenie na dostęp do określonego folderu określonego dziecka może być dobrym pomysłem, jeśli chcesz ograniczyć dostęp do folderu i jego folderów podrzędnych. Zezwól umożliwia przyznanie dostępu do określonego pliku w określonym folderze, ale uniemożliwia dostęp do całego folderu. WordPress używa parametru zapytania o nazwie?s= podczas obsługi zapytań. Wystarczy dodać następującą regułę, aby skonfigurować blokadę dostępu.

Dzięki tej funkcji można również uniknąć miękkich błędów 404, a także blokując je, jeśli wystąpią. Nawet jeśli kierujesz reklamy na określony region poza Stanami Zjednoczonymi, nie jest konieczne blokowanie Googlebotowi dostępu do tego kraju. Google jest zirytowany, że polecenie z niewidzialnym znakiem nie jest rozumiane. Szkoda, że unieważnia to pierwszy wiersz naszego pliku robots.txt. To nie to samo, co użycie znacznika noindex w plikach robots.txt, które są nazywane poleceniami Disallow. Z drugiej strony, plik Bots.txt nie indeksuje, ale uniemożliwia indeksowanie. Możesz go użyć do skonfigurowania interakcji wyszukiwarek i innych botów z Twoją witryną, dodając określone reguły. W przypadku większości osób, które w ogóle nie korzystają z WordPressa, zmiana domyślnego wirtualnego pliku robots.html nie jest konieczna. Możesz jednak dodać własne reguły, jeśli masz problemy z konkretnym botem lub wtyczką.

Jak dodać plik Robots.txt do swojej witryny?

Jeśli korzystasz z WordPressa, możesz łatwo dodać ten plik do swojej witryny za pomocą kreatora Dodaj nową stronę. Następnie w polu Adres URL pliku wprowadź adres URL pliku robots.txt. Ten plik można również dodać do strony WordPress, klikając pozycję menu Zarządzaj stronami na pulpicie nawigacyjnym.

Jeśli nie korzystasz z WordPressa, może być konieczne dodanie pliku robots.txt do witryny w inny sposób. Jeśli masz zainstalowanego klienta FTP na swoim komputerze, możesz łatwo dodać ten plik; jeśli masz zainstalowany menedżer plików na swoim komputerze, możesz go łatwo dodać.

Czy potrzebuję pliku tekstowego robotów WordPress?

Źródło: sms.com

Źródło: sms.comNie ma ostatecznej odpowiedzi na to pytanie, ponieważ zależy to od konkretnej witryny WordPress i rodzaju jej zawartości lub funkcjonalności. Ogólnie jednak plik robots.txt nie jest absolutnie niezbędny dla WordPressa, chociaż w niektórych przypadkach może być przydatny. Na przykład, jeśli witryna WordPress zawiera wiele poufnych lub poufnych informacji, można użyć pliku robots.txt, aby uniemożliwić wyszukiwarkom indeksowanie tej zawartości.

Plik robots.txt to prosty plik tekstowy, który informuje wyszukiwarki, gdzie i kiedy nie powinny indeksować Twojej witryny. Korzystając z tej funkcji, możesz uniemożliwić wyszukiwarkom dostęp do różnych plików i folderów w Twojej witrynie. W tym artykule pokażemy Ci, jak je utworzyć i damy Ci kilka rekomendowanych przez nas wtyczek, które pozwolą Ci wykonać pracę samodzielnie. Każda wyszukiwarka zawiera w swoich wynikach agenta użytkownika przemierzającego sieć. Na przykład Googlebot indeksuje treść Twojej witryny pod kątem wyszukiwarki Google. Masz możliwość skonfigurowania niestandardowej instrukcji dla każdego z tych programów użytkownika. Dostęp do pliku robots.txt można uzyskać, wpisując „/robots.txt” po nazwie domeny.

Możesz poinstruować robota, aby nie wyświetlał żadnych stron w witrynie po zrealizowaniu ukośnika, klikając link. Indeksowanie budżetu jest definiowane jako liczba adresów URL, które bot wyszukiwarki może zaindeksować podczas sesji. Każda witryna będzie miała określony budżet indeksowania. Jeśli masz dużo stron w swojej witrynie, powinieneś najpierw sprawdzić, czy bot indeksuje Twoje najcenniejsze strony. Wtyczka Yoast SEO WordPress umożliwia łatwe tworzenie plików robots.txt z pulpitu nawigacyjnego. Następnie użyj klienta FTP, takiego jak Filezilla, aby ręcznie przesłać plik. Jeśli chcesz wyświetlić plik w swojej witrynie, upewnij się, że znajduje się on w folderze głównym.

Aby go utworzyć, musisz użyć edytora tekstu, takiego jak Notatnik, jeśli pliku tam nie ma. Plik robots.txt powinien zawsze znajdować się w katalogu głównym witryny. Wyszukiwarki będą nadal przeszukiwać i indeksować Twoją witrynę, niezależnie od tego, czy masz ten plik, czy nie. Przetestowanie pliku robots.txt w Google Search Console jest proste. Klikając „Dodaj usługę teraz”, możesz dodać swoją witrynę do wyszukiwarki Google w ciągu kilku minut. Bardzo ważne jest utrzymanie określonego budżetu indeksowania w każdej witrynie. Musisz uwzględnić liczbę stron, które bot musi odwiedzić podczas sesji. Jeśli bot nie ukończy indeksowania wszystkich stron w Twojej witrynie podczas sesji, wróci do Twojej witryny i wznowi indeksowanie w następnej sesji. Szybkim rozwiązaniem jest zablokowanie robotom wyszukiwania indeksowania niepotrzebnych stron, plików multimedialnych, wtyczek, folderów motywów itd., co pozwala zaoszczędzić limit indeksowania.

Mówiąc prościej, dodaj następujący wiersz do pliku robots.txt: Agenci: użytkownicy. Usługa Googlebot jest obecnie używana. Jeśli nie masz pliku robots.txt, Googlebot zaindeksuje Twoje strony i zindeksuje je automatycznie w wyszukiwarce.

Dlaczego powinieneś dodać plik Robots.txt, aby poprawić SEO?

Możesz zwiększyć ranking swojej witryny w wyszukiwarce, pobierając plik robots.txt. Roboty indeksujące będą szukać tego pliku w katalogu głównym witryny, aby sprawdzić, czy zawartość jest dozwolona i dlaczego.

Edytuj plik Robots.txt WordPress

Jeśli chcesz edytować plik robots.txt, możesz to zrobić, przechodząc do pulpitu WordPress, a następnie klikając kartę „Ustawienia”. Stamtąd znajdziesz sekcję „Czytanie”, w której możesz edytować plik robots.txt.

Plik robots.txt, oprócz informowania wyszukiwarek, dokąd może przejść Twoja witryna, mówi im również, jak ją zaindeksować. Jeśli poinstruujesz roboty, aby nie indeksowały niepotrzebnych stron w Twojej witrynie, możesz zwiększyć szybkość jej ładowania i być może wyżej w wyszukiwarkach. W tym poście pokażemy, jak edytować plik robots.html za pomocą WordPressa. Plik robots.txt jest wymagany z pewnych powodów. W przypadku korzystania z metatagu noindex zamiast robots.txt podczas ładowania witryny. Dlaczego ma to tak duże znaczenie w naszym życiu. Chociaż system pozwala określić, które wyszukiwarki i inne boty wchodzą w interakcję z Twoją witryną, nie zabrania wyraźnie wyszukiwarkom lub innym botom indeksowania treści.

Przyjrzyjmy się krok po kroku, jak edytować pliki robots.html w WordPressie za pomocą AIOSEO. Konstruktor reguł umożliwia tworzenie własnych reguł dla określonych stron, które roboty mogą lub nie mogą odwiedzać. Tworząc regułę niestandardową, możesz wpisać klienta użytkownika (na przykład robota Googlebota ) w polu Agenty użytkownika. Musisz wprowadzić ścieżkę katalogu lub nazwę pliku w polu Ścieżka katalogu po określeniu, które boty mają być dozwolone, a które nie. Jeśli zapiszesz nowe reguły, będą one widoczne w sekcji Podgląd pliku Robots.txt. Możesz zobaczyć swój plik robots.txt, klikając Otwórz roboty. Ten tekst zostanie wysłany na Twoje urządzenie mobilne, gdy tylko będzie dostępny. Po prostu wpisując szczegóły swoich reguł, możesz je modyfikować. Kilka przykładów usuwania reguł zostanie pokazanych w osobnej sekcji.

Domyślny plik Robots.txt dla WordPress

Jeśli utworzysz witrynę WordPress i nie utworzysz niestandardowego pliku robots.txt, Twoja witryna automatycznie wygeneruje domyślny plik robots.txt, który zawiera następujące elementy: User-agent: * Disallow: / Pierwszy wiersz, User-agent: * , dotyczy wszystkich robotów internetowych . Drugi wiersz, Disallow: /, informuje wszystkie roboty indeksujące, aby nie indeksowały żadnych stron w Twojej witrynie. Jest to najbardziej restrykcyjne ustawienie i nie jest zalecane dla większości witryn WordPress.

Korzystanie z dobrze ustrukturyzowanego pliku robots.txt pozwoli Ci skierować boty wyszukiwarek do Twojej witryny. Mówi się im, aby trzymali się z dala od tych pomieszczeń, kiedy na nie patrzą. Nawet jeśli nie jesteś czarodziejem technicznym, możesz utworzyć ten plik zgodnie ze swoimi potrzebami, nawet jeśli nie znasz żadnego kodowania. Kiedy tworzysz witrynę WordPress, tworzy dla Ciebie wirtualny plik robots.txt. Boty nie mają dostępu do katalogów administratora i WP-includes na podstawie tego pliku. Aby wprowadzić zmiany, musisz najpierw utworzyć nowy plik, a następnie przesłać go do folderu głównego. Robots.txt można edytować w WordPressie na dwa sposoby: za pomocą wtyczki lub ręcznie.

W tym przykładzie stworzyliśmy nowy zestaw reguł, aby uniemożliwić botowi wyszukiwania Binga indeksowanie naszej witryny. Twoje instrukcje w tym pliku prawie na pewno będą przestrzegane przez większość botów, ale nie próbujesz ich do tego zmuszać. Po zainstalowaniu i aktywacji wtyczki Yoast SEO dla WordPress, będziesz mógł edytować pliki robots.txt bezpośrednio z pulpitu WordPress. All-in-One SEO Pack to drugi pakiet SEO, na który należy zwrócić uwagę, jeśli chodzi o WordPress SEO , a także jest bardzo prosty w użyciu. Yoast jest podobnym do niego produktem, ale jest znacznie lżejszy. Wystarczy wpisać kilka wierszy tekstu w Notatniku lub TextEdit, aby utworzyć plik robots.txt. Aby przetestować plik, prześlij go przez FTP, a następnie użyj Google Search Console.

Pakiet SEO All In One zawiera narzędzie, które można wykorzystać do blokowania „złych” botów. Jeśli chcesz zwiększyć widoczność swojej witryny, bardzo ważne jest, aby boty wyszukiwarek indeksowały najistotniejsze informacje. Pliki robots.txt WordPress ułatwiają określenie sposobu interakcji botów z witryną. Łatwiej im będzie prezentować trafne i przydatne treści wyszukiwarkom.

Jak zaktualizować plik Robots.txt WordPress?

Jeśli katalog główny witryny nie zawiera fizycznego pliku, WordPress generuje wirtualny plik robots.txt. Aby włączyć plik wirtualny, musisz go najpierw zastąpić, wykonując następujące kroki: Otwórz przeglądarkę i przejdź do katalogu głównego swojej witryny.

Sprawdź plik robots.txt.

Wprowadź wszelkie niezbędne zmiany w pliku.

Sprawdź, czy zapisałeś plik.

Twoja witryna musi zostać ponownie załadowana.

Plik robots.txt można zaktualizować, przechodząc do menu „Wtyczki” na lewym pasku bocznym i wyszukując go. Wprowadź zmiany w pliku robots.txt, wybierając z menu opcję „Ustawienia”.