Как добавить Txt-файл Robots в WordPress (3 простых шага)

Опубликовано: 2022-09-21Добавление файла robots.txt на ваш сайт WordPress — это простой процесс, который можно выполнить в несколько шагов. Файл robots.txt — это текстовый файл, который сообщает поисковым роботам, какие страницы вашего сайта они должны индексировать, а какие игнорировать. Исключив определенные страницы из индексации, вы можете улучшить поисковую оптимизацию своего сайта (SEO). Есть несколько разных способов добавить файл robots.txt в WordPress. Самый простой способ — использовать такой плагин, как Yoast SEO или All in One SEO Pack, который автоматически создаст для вас файл robots.txt. Кроме того, вы можете сами создать файл robots.txt и загрузить его на свой сайт WordPress через FTP. Какой бы метод вы ни выбрали, обязательно протестируйте файл robots.txt, прежде чем запускать его, чтобы убедиться, что он работает должным образом.

Получение присутствия в поисковых системах по определенным ключевым словам важно для владельцев веб-сайтов, поскольку это гарантирует, что их сайт появится в поисковой выдаче. Веб-мастера могут устанавливать время, которое роботы поисковых систем проводят на веб-сайтах и вне их, вставляя инструкции в специальный файл robots.txt. В этом руководстве я покажу вам, как добавить файл robots.txt на ваш веб-сайт WordPress, чтобы запретить поисковым системам доступ к определенным частям вашего сайта. Подключитесь к платформе Cloudways с помощью FileZilla. Вы можете создать новый файл с именем robots.txt в /applications/ [ИМЯ ПАПКИ]/public_html. Откройте файл в текстовом редакторе (хорошей альтернативой будет Блокнот). Настройки подстановочных знаков позволяют загружать определенные типы файлов.

Нет ограничений на параметры/выборы, которые может обрабатывать звездочка (*. Кроме того, если выбрано конкретное расширение, вы можете ограничить количество файлов, которые можно отключить. Robots.txt — фантастический файл для использования в SEO. Это зависит от вас, сколько частей вашего сайта WordPress вы хотите отобразить в поисковой выдаче. Если у вашего сайта есть карта сайта, вы должны включить URL-адрес, чтобы помочь поисковым системам найти его. Каталоги часто не требуется индексировать поисковыми системами, в результате страница может индексироваться намного быстрее.

В результате вы должны включить robots.txt в скрипты своего веб-сайта, чтобы поисковые системы воздерживались от индексации определенных частей. Если ваш сайт настроен неправильно (например, удалить /), он будет деиндексирован Google. Вы тоже должны быть осторожны. У вас есть возможность выполнить задание. Скажите, пожалуйста, используете ли вы этот тип файла и какие настройки для него.

txt — один из самых простых форматов файлов. Роботы запрограммированы на «разрешить» (то есть индексировать их) и «запретить» (то есть отклонить их) в зависимости от того, какие страницы они хотят видеть. Последний будет использоваться только один раз, чтобы составить список страниц, на которые вы не хотите, чтобы пауки сканировали.

Текстовый файл с именем txt может использоваться веб-сайтом для предоставления инструкций роботам, сканирующим веб-страницы. Google и другие поисковые системы используют поисковые роботы, также известные как веб-роботы, для архивирования и категоризации веб-сайтов. Поиск роботов обычно используется в ботах.

Robots.txt можно добавить в файл в Интернете. Чтобы просмотреть директивы веб-сайта (если на нем есть роботы), отправьте текстовый URL-адрес в конец любого корневого домена.

Куда мне поместить Txt-файл роботов WordPress?

Кредит: www.techdotmatrix.com

Кредит: www.techdotmatrix.comСоздайте список своих FTP-роботов , перейдя в левый раздел вашего FTP-клиента (мы используем Filezilla). Вы сохранили текстовый файл, который ранее создали на своем компьютере. Вы можете загрузить его, щелкнув его правой кнопкой мыши и выбрав Загрузить. Файл будет загружен через несколько секунд, и вы сможете увидеть его в корневом каталоге WordPress.

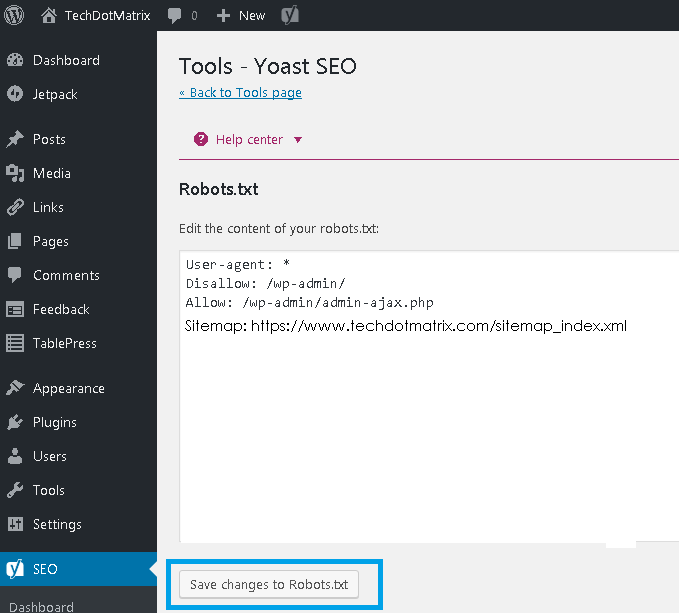

Файл robots.txt находится в корневом каталоге WordPress и представляет собой текстовый файл. Чтобы дать роботам поисковых систем представление о том, какие страницы на вашем веб-сайте они должны сканировать, он отображает список страниц, которые следует и не следует сканировать. Можно указать файлу избегать сканирования, а не индексации. В случаях, когда вредоносные боты повредили ваш сайт, необходим хороший плагин безопасности. WordPress создает виртуальный файл robots.txt для каждого веб-сайта, который его использует. Если вы хотите что-то изменить, у вас есть три варианта. Плагин Yoast SEO , один из самых популярных инструментов для оптимизации веб-сайтов, — отличный выбор.

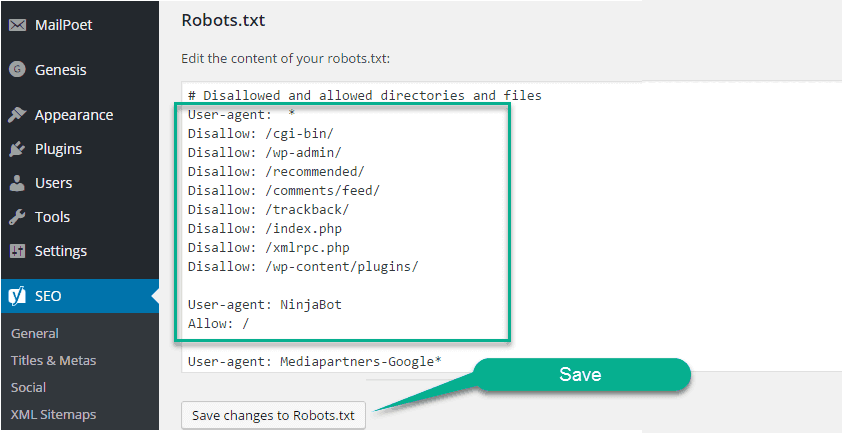

All in One SEO, еще один бесплатный SEO-плагин, предоставляет множество дополнительных функций. Если вы раньше использовали FTP, вы знаете, что можете загружать файлы robots.txt на свой сервер. Вы увидите новый раздел в файле robots.txt под названием Robots.txt, где впоследствии вы сможете добавить в файл правила и директивы. Директивы User-agent и Disallow содержатся в этом файле. Если вы хотите указать одного бота (например, Bingbot) или хотите, чтобы директивы применялись ко всем ботам, введите звездочку (User-agent: *). Чрезмерные запросы на сканирование перегружают сервер, что приводит к использованию директивы Crawl-delay. Поскольку нет сканеров, поддерживающих эту директиву, лучше использовать ее с осторожностью.

Поисковые системы будут перенаправлены на ваш XML-файл карты сайта, если вы используете директиву Sitemap. В следующих разделах мы покажем вам два примера фрагментов, демонстрирующих использование директив robots.txt. Каждый сайт WordPress имеет файл robots.txt в корневом каталоге. В нем сканерам будут даны инструкции о том, какие разделы вашего сайта они должны искать. Они должны или не должны ползать по земле. Во время нашего обсуждения мы рассмотрели способы создания физической версии файла и способы его редактирования.

Стоит ли добавлять файл robots.txt на свой сайт WordPress?

Как только WordPress будет установлен, он автоматически сгенерирует файл robots.txt. Индексатор поисковой системы хранит этот каталог, чтобы определить, какие страницы сайта индексируются. В большинстве случаев файлы robots.txt не нужно добавлять на веб-сайты WordPress. Однако, чтобы повысить рейтинг в поисковых системах, вы можете добавить файл robots.txt для управления индексом поисковой системы.

Как открыть Txt-файл Robots в WordPress?

Кредит: www.hitechwork.com

Кредит: www.hitechwork.comЕсть несколько способов открыть файл robots.txt в WordPress. Один из способов — просто перейти в папку установки WordPress и открыть файл в текстовом редакторе. Другой способ — использовать плагин, такой как WP Robots Txt , для редактирования файла из области администрирования WordPress.

Файл robots.txt есть почти на каждом веб-сайте, но большинство людей не понимают, что он делает и как его использовать. В этом руководстве мы рассмотрим файл и его ограничения, чтобы узнать, как управлять доступом к вашему веб-сайту. Даже если на страницу есть ссылки, указывающие на нее, она все равно может быть проиндексирована поисковыми системами, если она заблокирована файлом robots.txt. Google не будет получать доступ к отмеченным областям на вашем сайте. По словам Джона Мюллера, аналитика Google для веб-мастеров, на страницу, которая не была заблокирована Google, можно добавить тег noindex. Вы можете использовать популярный плагин Yoast SEO для создания (и последующего редактирования) SEO-шаблона. Поместите файл robots.txt в нужное место, щелкнув правой кнопкой мыши интерфейс Yoast.

Точно так же вы можете реализовать этот тип интеграции в плагине All in One SEO. Пожалуйста, продолжайте читать для получения дополнительной информации о различных типах директив, которые должны быть указаны в вашем файле robots.html WordPress. Прежде чем добавлять правила, вы должны сначала выбрать, к какому агенту пользователя должно применяться правило, а затем указать, сколько правил следует применить с помощью Disallow и Allow. Запрет доступа к папке и ее дочерним папкам, но разрешение доступа к определенной папке определенного дочернего элемента может быть хорошей идеей, если вы хотите ограничить доступ к папке и ее дочерним папкам. Разрешить позволяет предоставить доступ к определенному файлу в определенной папке, но запрещает доступ ко всей папке. WordPress использует параметр запроса с именем?s= при обработке запросов. Вам нужно только добавить следующее правило, чтобы настроить блокировку доступа.

Ошибок Soft 404 также можно избежать, используя эту функцию, а также блокируя их в случае их возникновения. Даже если вы ориентируетесь на определенный регион за пределами США, нет необходимости блокировать въезд робота Google в страну. Google раздражает, что команда с невидимым символом не понята. Жаль, что это делает недействительной первую строку нашего файла robots.txt. Это не то же самое, что использование тега noindex в файлах robots.txt, которые называются командами Disallow. Bots.txt, с другой стороны, не индексирует, но предотвращает сканирование. Вы можете использовать его, чтобы настроить взаимодействие поисковых систем и других ботов с вашим сайтом, добавив определенные правила. Нет необходимости изменять виртуальный файл robots.html по умолчанию для большинства людей, которые вообще не используют WordPress. Однако вы можете добавить свои собственные правила, если у вас есть проблемы с определенным ботом или плагином.

Как добавить файл robots.txt на свой сайт

Если вы используете WordPress, вы можете легко добавить этот файл на свой сайт с помощью мастера добавления новой страницы. Затем в поле URL-адрес файла введите URL-адрес файла robots.txt. Этот файл также можно добавить на страницу WordPress, щелкнув пункт меню «Управление страницами» на панели инструментов.

Если вы не используете WordPress, вам может понадобиться добавить robots.txt на свой сайт другим способом. Если на вашем компьютере установлен FTP-клиент, вы можете легко добавить этот файл; если на вашем компьютере установлен файловый менеджер, вы можете легко добавить его.

Нужен ли мне Txt-файл роботов WordPress?

Кредит: pressidium.com

Кредит: pressidium.comНа этот вопрос нет однозначного ответа, так как он зависит от конкретного рассматриваемого сайта WordPress и от того, какой контент или функциональность он имеет. Однако в целом файл robots.txt не является обязательным для WordPress, хотя в некоторых случаях он может быть полезен. Например, если на сайте WordPress много важной или конфиденциальной информации, можно использовать файл robots.txt, чтобы запретить поисковым системам индексировать этот контент.

Файл robots.txt — это простой текстовый файл, который сообщает поисковым системам, где и когда не следует сканировать ваш сайт. С помощью этой функции вы можете запретить поисковым системам доступ к различным файлам и папкам на вашем сайте. В этой статье мы покажем вам, как его создать, и предоставим вам несколько рекомендуемых нами плагинов, которые позволят вам выполнять работу самостоятельно. Каждая поисковая система включает в свои результаты поиска пользовательский агент веб-сканирования. Googlebot, например, индексирует содержимое вашего веб-сайта для поисковой системы Google. У вас есть возможность настроить пользовательскую инструкцию для каждого из этих пользовательских агентов. Доступ к файлу robots.txt можно получить, введя «/robots.txt» после имени домена.

Вы можете указать роботу не просматривать какие-либо страницы на сайте после погашения косой черты, перейдя по ссылке. Сканирование бюджета определяется как количество URL-адресов, которые бот поисковой системы может просканировать за сеанс. Каждый веб-сайт будет иметь определенный краулинговый бюджет. Если на вашем веб-сайте много страниц, вам следует проверить, сканирует ли бот в первую очередь ваши самые ценные страницы. Плагин WordPress Yoast SEO позволяет легко создавать файлы robots.txt с панели инструментов. Затем используйте FTP-клиент, например Filezilla, чтобы загрузить файл вручную. Если вы хотите отобразить файл на своем веб-сайте, убедитесь, что он находится в корневой папке.

Чтобы создать его, вам нужно использовать текстовый редактор, например Блокнот, если файла там нет. Файл robots.txt всегда должен находиться в корне вашего сайта. Поисковые системы будут продолжать сканировать и индексировать ваш сайт независимо от того, есть у вас этот файл или нет. Проверить файл robots.txt в Google Search Console очень просто. Нажав "Добавить ресурс сейчас", вы сможете добавить свой веб-сайт в поиск Google за считанные минуты. Крайне важно поддерживать определенный краулинговый бюджет на каждом веб-сайте. Вы должны учитывать количество страниц, которые бот должен посетить во время сеанса. Если бот не завершит сканирование всех страниц вашего сайта во время сеанса, он вернется на ваш сайт и возобновит сканирование в следующем сеансе. Быстрое решение — заблокировать поисковым ботам сканирование ненужных страниц, медиафайлов, плагинов, папок тем и т. д., тем самым сэкономив квоту сканирования.

Проще говоря, добавьте в файл robots.txt следующую строку: Агенты: пользователи. Служба Googlebot в настоящее время используется. Если у вас нет файла robots.txt, робот Googlebot просканирует ваши страницы и автоматически проиндексирует их в поисковой системе.

Почему вы должны добавить файл robots.txt, чтобы улучшить SEO

Вы можете повысить рейтинг своего сайта в поисковых системах, загрузив файл robots.txt. Сканеры будут искать этот файл в корне вашего веб-сайта, чтобы узнать, разрешен ли контент и почему.

Редактировать robots.txt WordPress

Если вы хотите отредактировать файл robots.txt, вы можете сделать это, перейдя на панель управления WordPress и щелкнув вкладку «Настройки». Оттуда вы найдете раздел «Чтение», где вы можете отредактировать файл robots.txt.

Файл robots.txt не только сообщает поисковым системам, куда разрешен доступ вашему сайту, но и сообщает им, как его сканировать. Если вы проинструктируете своих ботов не сканировать ненужные страницы на вашем сайте, вы можете увеличить скорость его загрузки и, возможно, повысить рейтинг в поисковых системах. В этом посте мы покажем вам, как редактировать файл robots.html с помощью WordPress. Файл robots.txt необходим по некоторым причинам. При использовании метатега noindex вместо robots.txt при загрузке сайта. Почему это так важно в нашей жизни. Хотя система позволяет вам указать, какие поисковые системы и другие боты взаимодействуют с вашим сайтом, она не запрещает поисковым системам или другим ботам индексировать ваш контент.

Давайте посмотрим, как шаг за шагом редактировать файлы robots.html в WordPress с помощью AIOSEO. Конструктор правил позволяет создавать собственные правила для определенных страниц, которые роботы могут или не могут посещать. При создании пользовательского правила вы можете указать агент пользователя (например, поисковый робот Googlebot ) в поле «Агенты пользователя». Вы должны ввести путь к каталогу или имя файла в поле «Путь к каталогу» после того, как определите, какие боты должны быть разрешены или запрещены. Если вы сохраните свои новые правила, они будут видны в разделе предварительного просмотра Robots.txt. Вы можете просмотреть свой файл robots.txt, нажав «Открыть роботов». Этот текст будет отправлен на ваше мобильное устройство, как только он будет доступен. Просто введя детали ваших правил, вы можете изменить их. Несколько примеров удаления правил будут показаны в отдельном разделе.

Robots.txt по умолчанию для WordPress

Если вы создадите сайт WordPress и не создадите пользовательский файл robots.txt, ваш сайт автоматически создаст файл robots.txt по умолчанию, который включает следующее: User-agent: * Disallow: / Первая строка, User-agent: * , применяется ко всем поисковым роботам . Вторая строка, Disallow: /, указывает всем поисковым роботам не индексировать никакие страницы на вашем сайте. Это наиболее ограничительный параметр, и его не рекомендуется использовать для большинства сайтов WordPress.

Использование хорошо структурированного файла robots.txt позволит вам направлять ботов поисковых систем на ваш сайт. Им говорят держаться подальше от этих комнат, пока они смотрят на них. Даже если вы не технический мастер, вы можете создать этот файл для удовлетворения ваших потребностей, даже если вы не знаете кодирования. Когда вы создаете веб-сайт WordPress, он создает для вас виртуальный файл robots.txt. Ботам запрещен доступ к каталогам администратора и WP-include на основе этого файла. Для внесения изменений необходимо сначала создать новый файл, а затем загрузить его в корневую папку. Robots.txt можно редактировать в WordPress двумя способами: через плагин или вручную.

В этом примере мы создали новый набор правил, чтобы поисковый робот Bing не мог сканировать наш сайт. Ваши инструкции в этом файле почти наверняка будут выполняться большинством ботов, но вы не пытаетесь их заставить. После того, как вы установили и активировали плагин Yoast SEO для WordPress, вы сможете редактировать файлы robots.txt прямо из панели инструментов WordPress. All-in-One SEO Pack — это еще один SEO-пакет, на который стоит обратить внимание, когда дело доходит до WordPress SEO , и он также очень прост в использовании. Йост - аналогичный ему продукт, но он намного легче по весу. Это так же просто, как ввести несколько строк текста в Блокнот или TextEdit, чтобы создать файл robots.txt. Чтобы протестировать файл, загрузите его через FTP, а затем используйте Google Search Console.

All In One SEO Pack включает в себя инструмент, который можно использовать для блокировки «плохих» ботов. Если вы хотите увеличить видимость своего сайта, крайне важно, чтобы роботы поисковых систем сканировали наиболее релевантную информацию. Файлы WordPress robots.txt упрощают указание того, как ваши боты взаимодействуют с вашим сайтом. Им будет проще представить актуальный и полезный контент поисковым системам.

Как обновить файл WordPress Robots.txt

Если в корне веб-сайта нет физического файла, WordPress создает виртуальный файл robots.txt. Чтобы включить виртуальный файл, вы должны сначала переопределить его, выполнив следующие действия: Откройте браузер и перейдите в корневой каталог вашего веб-сайта.

Проверьте файл robots.txt.

Пожалуйста, внесите необходимые изменения в файл.

Проверьте, сохранили ли вы файл.

Ваш сайт должен быть перезагружен.

Файл robots.txt можно обновить, перейдя в меню «Плагины» на левой боковой панели и выполнив поиск. Внесите любые изменения в файл robots.txt, выбрав «Настройки» в меню.