Cum să adăugați un fișier Txt Robots la WordPress (în 3 pași simpli)

Publicat: 2022-09-21Adăugarea unui fișier robots.txt pe site-ul dvs. WordPress este un proces simplu care poate fi realizat în câțiva pași. Un fișier robots.txt este un fișier text care le spune crawlerilor motoarelor de căutare ce pagini de pe site-ul dvs. ar trebui să indexeze și pe care ar trebui să le ignore. Prin excluderea anumitor pagini de la indexare, puteți îmbunătăți optimizarea site-ului dvs. pentru motoarele de căutare (SEO). Există câteva moduri diferite de a adăuga un fișier robots.txt la WordPress. Cel mai simplu mod este să folosești un plugin precum Yoast SEO sau All in One SEO Pack, care va genera automat un fișier robots.txt pentru tine. Alternativ, puteți crea singur un fișier robots.txt și îl puteți încărca pe site-ul dvs. WordPress prin FTP. Indiferent de metoda pe care o alegeți, asigurați-vă că testați fișierul robots.txt înainte de a-l activa, pentru a vă asigura că funcționează conform intenției.

Obținerea unei prezențe în motoarele de căutare pentru anumite cuvinte cheie este esențială pentru proprietarii de site-uri web, deoarece asigură faptul că site-ul lor apare în SERP. Webmasterii pot seta timpul petrecut de roboții motoarelor de căutare pe și în afara site-urilor web, inserând instrucțiuni în robots.txt, un fișier special. În acest tutorial, vă voi arăta cum să adăugați un fișier „robots.txt” pe site-ul dvs. WordPress pentru a împiedica motoarele de căutare să acceseze anumite părți ale site-ului dvs. Conectați-vă la Platforma Cloudways utilizând FileZilla. Puteți crea un fișier nou numit robots.txt în /applications/ [NUMELE DOSARULUI]/public_html. Deschideți fișierul într-un editor de text (Notepad este o alternativă bună). Setările wildcard permit descărcarea anumitor tipuri de fișiere.

Nu există nicio limită pentru opțiunile/selecțiile pe care un asterisc (* le poate gestiona. În plus, dacă este selectată o anumită extensie, puteți limita numărul de fișiere care pot fi dezactivate. Robots.txt este un fișier fantastic de utilizat pentru SEO În scopuri. Depinde de dvs. câte părți ale site-ului dvs. WordPress doriți să apară în SERP. Dacă site-ul dvs. are o hartă a site-ului, ar trebui să includeți o adresă URL care să ajute motoarele de căutare în localizarea acestuia. Adesea, directoarele nu trebuie să fie indexate de către motoarele de căutare. Ca rezultat, o pagină poate fi indexată mult mai rapid.

Ca urmare, trebuie să includeți robots.txt în scripturile site-ului dvs. pentru ca motoarele de căutare să nu indexeze anumite părți. Dacă site-ul dvs. este configurat incorect (cum ar fi șterge /), acesta va fi deindexat de Google. Ar trebui să fii și tu precaut. Aveți posibilitatea de a finaliza sarcina. Vă rog să-mi spuneți dacă utilizați acest tip de fișier și care sunt setările pentru el.

txt este unul dintre cele mai simple formate de fișiere de utilizat. Roboții sunt programați pentru „Permite” (adică, indexează-i) și „Disallow” (adică, îi respinge) în funcție de paginile pe care doresc să le vadă. Acesta din urmă va fi folosit o singură dată pentru a enumera paginile pe care nu doriți să se târască păianjenii.

Un fișier text numit txt poate fi folosit de un site web pentru a oferi instrucțiuni roboților de accesare cu crawlere. Google și alte motoare de căutare folosesc crawler web , cunoscut și sub numele de roboți web, pentru a arhiva și clasifica site-urile web. O căutare robot este utilizată de obicei în roboți.

Robots.txt poate fi adăugat la un fișier de pe Internet. Pentru a vedea directivele site-ului web (dacă site-ul are roboți), trimiteți un mesaj URL la sfârșitul oricărui domeniu rădăcină.

Unde pun fișierul Txt Robots WordPress?

Credit: www.techdotmatrix.com

Credit: www.techdotmatrix.comCreați o listă cu roboții dvs. FTP mergând în secțiunea din stânga a clientului dvs. FTP (folosim Filezilla). Ați salvat un fișier txt pe care l-ați creat anterior pe computer. Îl puteți încărca făcând clic dreapta pe el și selectând Încărcați. Fișierul va fi încărcat în câteva momente și îl veți putea vedea în directorul WordPress rădăcină.

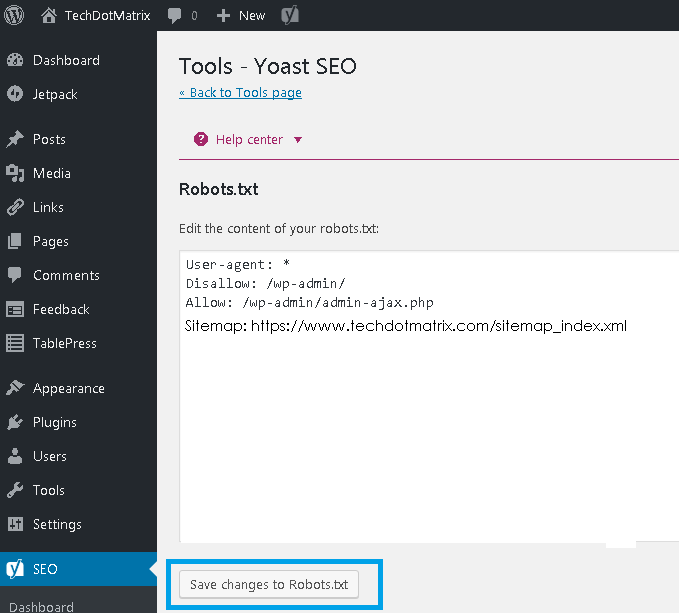

Fișierul robots.txt se află în directorul WordPress rădăcină și este un fișier text. Pentru a oferi roboților motoarelor de căutare o idee despre paginile de pe site-ul dvs. pe care trebuie să le acceseze cu crawlere, acesta afișează o listă a paginilor care trebuie și nu ar trebui să fie accesate cu crawlere. Este posibil să instruiți fișierul să evite accesarea cu crawlere, mai degrabă decât indexarea. În cazurile în care roboții răi v-au corupt site-ul, un plugin de securitate bun este esențial. WordPress creează un fișier virtual robots.txt pentru fiecare site web care îl folosește. Dacă vrei să schimbi ceva, ai trei opțiuni. Pluginul Yoast SEO , unul dintre cele mai populare instrumente pentru optimizarea site-urilor web, este o alegere excelentă.

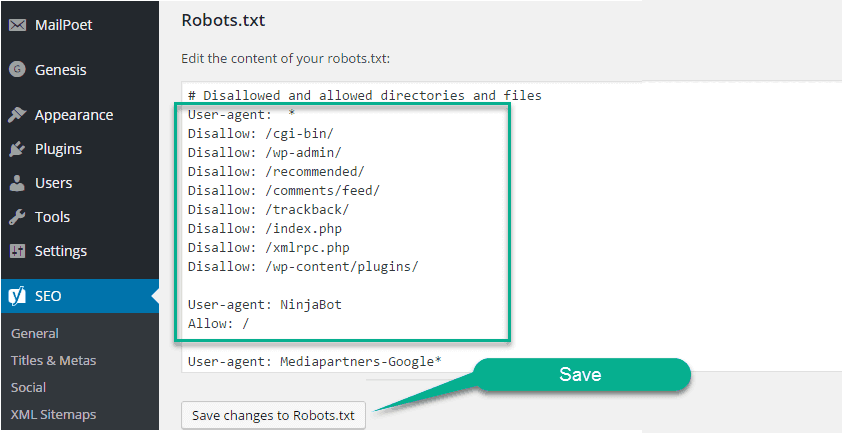

All in One SEO, un alt plugin SEO gratuit, oferă o varietate de funcții suplimentare. Dacă ați mai folosit FTP, știți că puteți încărca fișiere robots.txt pe serverul dvs. Veți vedea o nouă secțiune în fișierul robots.txt numită Robots.txt, unde puteți adăuga reguli și directive la fișier ulterior. User-agent și Disallow sunt ambele directive conținute în acest fișier. Dacă doriți să specificați un singur bot (de exemplu, Bingbot) sau dacă doriți ca directivele să se aplice tuturor roboților, introduceți un asterisc (User-agent: *). Solicitările de accesare cu crawlere excesive supraîncărcă serverul, ceea ce duce la utilizarea unei directive de întârziere cu crawlere. Deoarece nu există crawler-uri care acceptă această directivă, cel mai bine este să o utilizați cu prudență.

Motoarele de căutare vor fi direcționate către fișierul dvs. XML de hartă site dacă utilizați directiva Sitemap. În secțiunile următoare, vă vom arăta două exemple de fragmente care demonstrează utilizarea directivelor robots.txt. Fiecare site WordPress are un fișier robots.txt în directorul său rădăcină. În acesta, crawlerele vor primi instrucțiuni despre ce secțiuni ale site-ului dvs. ar trebui să caute. Ar trebui sau nu ar trebui să se târască peste pământ. În timpul discuției noastre, am abordat modalități de a crea o versiune fizică a fișierului și cum să o edităm.

Ar trebui să adăugați un fișier Robots.txt pe site-ul dvs. WordPress?

De îndată ce WordPress este instalat, acesta va genera automat un fișier robots.txt. Un motor de căutare indexează acest director pentru a determina ce pagini de pe un site sunt indexate. În majoritatea cazurilor, fișierele Robots.txt nu trebuie adăugate pe site-urile WordPress. Cu toate acestea, pentru a vă crește clasamentul în motoarele de căutare, puteți adăuga un fișier robots.txt pentru a gestiona indexul motorului de căutare.

Cum deschid un fișier Txt Robots în WordPress?

Credit: www.hitechwork.com

Credit: www.hitechwork.comExistă câteva moduri de a deschide un fișier robots.txt în WordPress. O modalitate este să accesați pur și simplu folderul de instalare WordPress și să deschideți fișierul într-un editor de text. O altă modalitate este să utilizați un plugin precum WP Robots Txt pentru a edita fișierul din zona de administrare WordPress.

Există un fișier robots.txt găsit pe aproape fiecare site web, dar majoritatea oamenilor nu înțeleg ce face sau cum să îl folosească. În acest ghid, vom analiza fișierul și restricțiile acestuia pentru a afla cum să gestionăm accesul site-ului dvs. web. Chiar dacă o pagină are linkuri care indică către ea, poate fi totuși indexată de motoarele de căutare dacă este blocată de robots.txt. Google nu va accesa zonele marcate de pe site-ul dvs. O etichetă noindex poate fi adăugată la o pagină care nu a fost blocată de Google, conform lui John Mueller, analist pentru webmasteri Google. Puteți folosi popularul plugin SEO Yoast pentru a crea (și ulterior edita) un șablon SEO. Puneți fișierul robots.txt la locul potrivit făcând clic dreapta pe interfața Yoast.

În mod similar, puteți implementa acest tip de integrare în pluginul All in One SEO. Continuați să citiți pentru mai multe informații despre diferitele tipuri de directive care trebuie specificate în fișierul dvs. WordPress robots.html. Înainte de a adăuga reguli, trebuie mai întâi să selectați la ce agent de utilizator ar trebui să se aplice regula, urmat de câte reguli să aplicați folosind Disallow și Allow. Interzicerea accesului la un folder și folderele sale secundare, dar permiterea accesului la folderul specific al unui anumit copil poate fi o idee bună dacă doriți să restricționați accesul la un folder și folderele sale secundare. Permiteți vă permite să acordați acces la un anumit fișier dintr-un anumit folder, dar vă împiedică să accesați un întreg folder. WordPress folosește un parametru de interogare numit?s= atunci când gestionează interogări. Trebuie doar să adăugați următoarea regulă pentru a configura un blocare la acces.

Erorile soft 404 pot fi evitate și prin utilizarea acestei funcții, precum și prin blocarea lor dacă apar. Chiar dacă vizați o anumită regiune din afara Statelor Unite, nu este necesar să blocați Googlebot să intre în țară. Google este iritat că o comandă cu caracter invizibil nu este înțeleasă. Este păcat că acest lucru invalidează prima linie a fișierului nostru robots.txt. Nu este același lucru cu utilizarea unei etichete noindex în fișierele robots.txt, care sunt denumite comenzi Disallow. Bots.txt, pe de altă parte, nu indexează, dar împiedică accesarea cu crawlere. Îl puteți folosi pentru a configura modul în care motoarele de căutare și alți roboți interacționează cu site-ul dvs., adăugând reguli specifice. Nu este necesar să schimbați fișierul virtual robots.html implicit pentru majoritatea oamenilor care nu folosesc WordPress deloc. Puteți, totuși, să adăugați propriile reguli dacă aveți probleme cu un anumit bot sau plugin.

Cum să adăugați un fișier Robots.txt pe site-ul dvs

Dacă utilizați WordPress, puteți adăuga cu ușurință acest fișier pe site-ul dvs. utilizând expertul Adăugați o pagină nouă. Apoi, în câmpul File URL, introduceți adresa URL pentru fișierul robots.txt. Acest fișier poate fi adăugat și la o pagină WordPress făcând clic pe elementul de meniu Gestionare pagini din tabloul de bord.

Dacă nu utilizați WordPress, poate fi necesar să adăugați robots.txt pe site-ul dvs. într-un mod diferit. Dacă aveți un client FTP instalat pe computer, puteți adăuga cu ușurință acest fișier; dacă aveți un manager de fișiere instalat pe computer, îl puteți adăuga cu ușurință.

Am nevoie de un fișier WordPress Txt Robots?

Credit: pressidium.com

Credit: pressidium.comNu există un răspuns definitiv la această întrebare, deoarece depinde de site-ul WordPress specific în cauză și de ce fel de conținut sau funcționalitate are. În general, însă, un fișier robots.txt nu este strict necesar pentru WordPress, deși poate fi util în unele cazuri. De exemplu, dacă un site WordPress are multe informații sensibile sau confidențiale, un fișier robots.txt poate fi folosit pentru a împiedica motoarele de căutare să indexeze acest conținut.

Fișierul robots.txt este un fișier text simplu care le spune motoarele de căutare unde și când nu ar trebui să acceseze cu crawlere site-ul dvs. Puteți împiedica motoarele de căutare să acceseze diferite fișiere și foldere de pe site-ul dvs. utilizând această funcție. În acest articol, vă vom arăta cum să creați unul și vă vom oferi câteva plugin-uri pe care vi le recomandăm, permițându-vă să faceți singur munca. Fiecare motor de căutare include un agent de utilizator de crawling web în rezultatele căutării sale. Googlebot, de exemplu, indexează conținutul site-ului dvs. pentru motorul de căutare Google. Aveți opțiunea de a configura o instrucțiune personalizată pentru fiecare dintre acești agenți de utilizator. Fișierul robots.txt poate fi accesat tastând „/robots.txt” după numele domeniului.

Puteți indica robotului să nu vadă nicio pagină de pe site după ce ați răscumpărat slash-ul urmând linkul. O accesare cu crawlere bugetară este definită ca numărul de adrese URL pe care un robot robot de căutare poate accesa cu crawlere într-o sesiune. Fiecare site web va avea un buget de accesare cu crawlere specific. Dacă aveți o mulțime de pagini pe site-ul dvs., ar trebui să verificați pentru a vedea dacă botul vă accesează mai întâi paginile cele mai valoroase. Pluginul Yoast SEO al WordPress vă permite să creați cu ușurință fișiere robots.txt din tabloul de bord. Apoi, utilizați un client FTP precum Filezilla pentru a încărca manual fișierul. Dacă doriți să afișați fișierul pe site-ul dvs. web, asigurați-vă că este în folderul rădăcină.

Pentru a crea unul, va trebui să utilizați un editor de text precum Notepad dacă fișierul nu este acolo. Fișierul robots.txt ar trebui să fie întotdeauna localizat la rădăcina site-ului dvs. Motoarele de căutare vor continua să acceseze cu crawlere și să indexeze site-ul dvs., indiferent dacă aveți sau nu acest fișier. Este simplu să testați fișierul robots.txt în Google Search Console. Făcând clic pe „Adăugați proprietatea acum”, puteți adăuga site-ul dvs. la Căutarea Google în câteva minute. Este esențial să mențineți un buget de accesare cu crawlere specific pentru fiecare site web. Trebuie să țineți cont de numărul de pagini pe care trebuie să le acceseze un bot în timpul unei sesiuni. Dacă botul nu finalizează accesarea cu crawlere a tuturor paginilor de pe site-ul dvs. în timpul sesiunii, va reveni pe site-ul dvs. și va relua accesarea cu crawlere în următoarea sesiune. O soluție rapidă este de a bloca roboții de căutare de la accesarea cu crawlere a paginilor inutile, fișierelor media, pluginurilor, folderelor cu teme și așa mai departe, salvând astfel cota de accesare cu crawlere.

Pentru a spune simplu, adăugați următoarea linie în fișierul dvs. robots.txt: Agenți: utilizatori. În prezent, serviciul Googlebot este în uz. Dacă nu aveți un fișier robots.txt, Googlebot vă va accesa cu crawlere paginile și le va indexa automat în motorul de căutare.

De ce ar trebui să adăugați un fișier Robots.txt pentru a vă îmbunătăți SEO

Puteți crește clasarea în motoarele de căutare a site-ului dvs. prin descărcarea unui fișier robots.txt. Crawlerele vor căuta acest fișier în rădăcina site-ului dvs. pentru a vedea dacă conținutul este permis sau nu și de ce.

Editați Robots.txt WordPress

Dacă doriți să editați fișierul robots.txt, puteți face acest lucru accesând tabloul de bord WordPress și apoi făcând clic pe fila „Setări”. De acolo, veți găsi secțiunea „Citire” unde vă puteți edita fișierul robots.txt.

Un fișier robots.txt, pe lângă faptul că le spune motoarele de căutare unde are permisiunea de a merge site-ul dvs., le spune și cum să îl acceseze cu crawlere. Dacă vă instruiți roboții să nu acceseze cu crawlere paginile inutile de pe site-ul dvs., puteți crește viteza de încărcare a acestuia și, eventual, să vă poziționați mai sus în motoarele de căutare. În această postare, vă vom arăta cum să editați fișierul robots.html folosind WordPress. Fișierul robots.txt este necesar din anumite motive. Când utilizați o etichetă meta noindex în loc de robots.txt când încărcați un site web. De ce contează atât de mult în viețile noastre. Deși sistemul vă permite să specificați ce motoare de căutare și ceilalți roboți interacționează cu site-ul dvs. web, nu interzice în mod explicit motoarele de căutare sau alți roboți să vă indexeze conținutul.

Să aruncăm o privire la cum să editați fișierele robots.html în WordPress pas cu pas folosind AIOSEO. Generatorul de reguli vă permite să vă creați propriile reguli pentru anumite pagini pe care roboții le pot vizita sau nu. Când creați o regulă personalizată, puteți introduce User Agent (de exemplu, Googlebot crawler ) în câmpul User Agents. Trebuie să introduceți calea directorului sau numele fișierului în câmpul Calea directorului după ce ați determinat ce roboți ar trebui permisi sau refuzați. Dacă salvați noile reguli, acestea vor fi vizibile în secțiunea Previzualizare Robots.txt. Puteți vedea fișierul robots.txt făcând clic pe Deschideți roboți. Acest text va fi trimis pe dispozitivul dvs. mobil de îndată ce este disponibil. Doar introducând detaliile regulilor dvs., le puteți modifica. Câteva exemple de reguli de ștergere vor fi afișate într-o secțiune separată.

Robots.txt implicit pentru WordPress

Dacă creați un site WordPress și nu creați un fișier robots.txt personalizat, site-ul dvs. va genera automat un fișier robots.txt implicit care include următoarele: User-agent: * Disallow: / Prima linie, User-agent: * , se aplică tuturor crawlerelor web . A doua linie, Disallow: /, indică tuturor crawlerelor web să nu indexeze nicio pagină de pe site-ul dvs. Aceasta este cea mai restrictivă setare și nu este recomandată pentru majoritatea site-urilor WordPress.

Utilizarea unui fișier robots.txt bine structurat vă va permite să direcționați roboții motoarelor de căutare către site-ul dvs. web. Li se spune să păstreze distanța față de acele camere în timp ce se uită la el. Chiar dacă nu sunteți un expert tehnic, puteți crea acest fișier pentru a vă satisface nevoile, chiar dacă nu cunoașteți nicio codificare. Când creați un site web WordPress, acesta creează un fișier virtual robots.txt pentru dvs. Boții nu pot accesa administratorul și WP-include directoare bazate pe acest fișier. Pentru a face modificări, trebuie mai întâi să creați un fișier nou și apoi să îl încărcați în folderul rădăcină. Robots.txt poate fi editat în WordPress în două moduri: printr-un plugin sau manual.

În acest exemplu, am creat un nou set de reguli pentru a împiedica robotul de căutare Bing să acceseze cu crawlere site-ul nostru. Instrucțiunile dvs. din acest fișier vor fi aproape sigur urmate de majoritatea roboților, dar nu încercați să le forțați. După ce ați instalat și activat pluginul Yoast SEO pentru WordPress, veți putea edita fișierele robots.txt direct din tabloul de bord WordPress. Pachetul All-in-One SEO este celălalt pachet SEO de care trebuie să aveți grijă când vine vorba de WordPress SEO și este, de asemenea, foarte simplu de utilizat. Yoast este un produs similar cu acesta, dar este mult mai ușor. Este la fel de simplu ca să tastați câteva rânduri de text în Notepad sau TextEdit pentru a crea un fișier robots.txt. Pentru a testa fișierul, încărcați-l prin FTP și apoi utilizați Google Search Console.

Pachetul All In One SEO include un instrument care poate fi folosit pentru a bloca roboții „răi”. Dacă doriți să creșteți vizibilitatea site-ului dvs., este esențial ca roboții motoarelor de căutare să acceseze cu crawlere cele mai relevante informații. Fișierele WordPress robots.txt simplifică specificarea modului în care boții interacționează cu site-ul dvs. Le va fi mai ușor să prezinte motoarele de căutare conținut relevant și util.

Cum să vă actualizați fișierul WordPress Robots.txt

Dacă rădăcina site-ului web nu conține un fișier fizic, WordPress generează un fișier virtual robots.txt. Pentru a activa fișierul virtual, trebuie mai întâi să îl înlocuiți urmând acești pași: Deschideți browserul și navigați la directorul rădăcină al site-ului dvs. web.

Verificați fișierul robots.txt.

Vă rugăm să faceți orice modificări necesare în fișier.

Verificați dacă ați salvat fișierul.

Site-ul dvs. trebuie reîncărcat.

Fișierul robots.txt poate fi actualizat accesând meniul „Plugins” din bara laterală din stânga și căutându-l. Efectuați orice modificări în fișierul robots.txt selectând „Setări” din meniu.