So fügen Sie eine Robots-TXT-Datei zu WordPress hinzu (in 3 einfachen Schritten)

Veröffentlicht: 2022-09-21Das Hinzufügen einer robots.txt-Datei zu Ihrer WordPress-Site ist ein einfacher Vorgang, der in wenigen Schritten erledigt werden kann. Eine robots.txt-Datei ist eine Textdatei, die Suchmaschinen-Crawlern mitteilt, welche Seiten Ihrer Website sie indexieren und welche sie ignorieren sollen. Indem Sie bestimmte Seiten von der Indexierung ausschließen, können Sie die Suchmaschinenoptimierung (SEO) Ihrer Website verbessern. Es gibt verschiedene Möglichkeiten, eine robots.txt-Datei zu WordPress hinzuzufügen. Der einfachste Weg ist die Verwendung eines Plugins wie Yoast SEO oder All in One SEO Pack, das automatisch eine robots.txt-Datei für Sie generiert. Alternativ können Sie selbst eine robots.txt-Datei erstellen und diese per FTP auf Ihre WordPress-Seite hochladen. Unabhängig davon, für welche Methode Sie sich entscheiden, testen Sie Ihre robots.txt-Datei, bevor Sie sie live schalten, um sicherzustellen, dass sie wie beabsichtigt funktioniert.

Eine Präsenz in Suchmaschinen für bestimmte Schlüsselwörter zu erhalten, ist für Websitebesitzer von entscheidender Bedeutung, da dies sicherstellt, dass ihre Website in den SERPs erscheint. Webmaster können festlegen, wie viel Zeit Suchmaschinen-Roboter auf und außerhalb von Websites verbringen, indem sie Anweisungen in die robots.txt-Datei, eine spezielle Datei, einfügen. In diesem Tutorial zeige ich Ihnen, wie Sie Ihrer WordPress-Website eine „robots.txt“-Datei hinzufügen, um zu verhindern, dass Suchmaschinen auf bestimmte Teile Ihrer Website zugreifen. Stellen Sie mithilfe von FileZilla eine Verbindung zur Cloudways-Plattform her. Sie können eine neue Datei namens robots.txt in /applications/[ORDNERNAME]/public_html erstellen. Öffnen Sie die Datei in einem Texteditor (Notepad ist eine gute Alternative). Wildcard-Einstellungen ermöglichen das Herunterladen bestimmter Dateitypen.

Es gibt keine Begrenzung für die Optionen/Auswahlen, die ein Sternchen (* verarbeiten kann. Wenn eine bestimmte Erweiterung ausgewählt wird, können Sie außerdem die Anzahl der Dateien begrenzen, die deaktiviert werden können. Robots.txt ist eine fantastische Datei, die für SEO verwendet werden kann Zwecke. Es liegt an Ihnen, wie viele Teile Ihrer WordPress-Site in SERP erscheinen sollen. Wenn Ihre Site eine Sitemap hat, sollten Sie eine URL angeben, um Suchmaschinen beim Auffinden zu helfen. Die Verzeichnisse müssen häufig nicht indexiert werden durch Suchmaschinen, wodurch eine Seite viel schneller indexiert werden kann.

Daher müssen Sie die robots.txt in die Skripte Ihrer Website einbinden, damit Suchmaschinen bestimmte Teile nicht indexieren. Wenn Ihre Website falsch konfiguriert ist (z. B. Löschen /), wird sie von Google deindexiert. Sie sollten auch vorsichtig sein. Sie haben die Möglichkeit, die Aufgabe abzuschließen. Bitte teilen Sie mir mit, ob Sie diesen Dateityp verwenden und welche Einstellungen dafür gelten.

txt ist eines der am einfachsten zu verwendenden Dateiformate. Die Roboter sind so programmiert, dass sie „erlauben“ (dh sie indizieren) und „verbieten“ (dh sie ablehnen), je nachdem, welche Seiten sie sehen möchten. Letzteres wird nur einmal verwendet, um die Seiten aufzulisten, auf denen Spinnen nicht kriechen sollen.

Eine Textdatei namens txt kann von einer Website verwendet werden, um Web-Crawling-Bots Anweisungen zu geben. Google und andere Suchmaschinen verwenden Webcrawler , auch als Webroboter bekannt, um Websites zu archivieren und zu kategorisieren. In den Bots wird typischerweise eine Robotersuche verwendet.

Robots.txt kann zu einer Datei im Internet hinzugefügt werden. Um die Anweisungen der Website anzuzeigen (wenn die Website über Robots verfügt), senden Sie die URL per SMS an das Ende einer beliebigen Root-Domain.

Wo lege ich die Robots Txt-Datei WordPress ab?

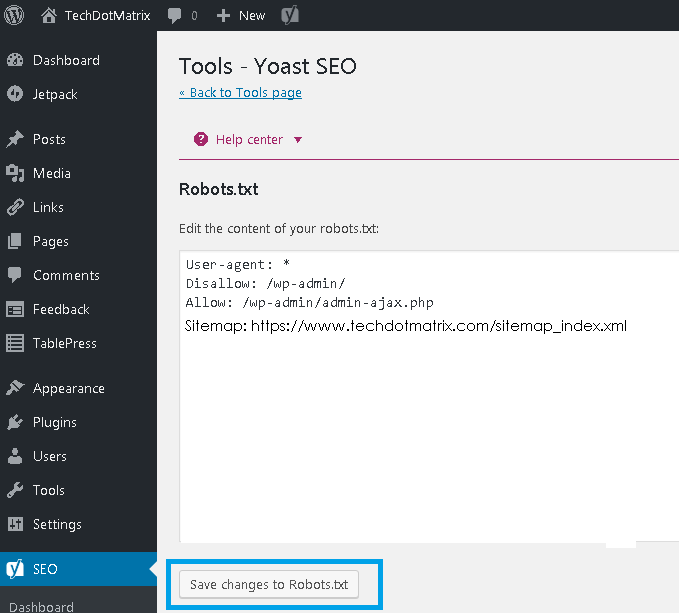

Bildnachweis: www.techdotmatrix.com

Bildnachweis: www.techdotmatrix.comErstellen Sie eine Liste Ihrer FTP-Roboter , indem Sie zum linken Bereich Ihres FTP-Clients gehen (wir verwenden Filezilla). Sie haben eine zuvor erstellte txt-Datei auf Ihrem Computer gespeichert. Sie können es hochladen, indem Sie mit der rechten Maustaste darauf klicken und Hochladen auswählen. Die Datei wird innerhalb weniger Augenblicke hochgeladen und Sie können sie in Ihrem WordPress-Stammverzeichnis sehen.

Die robots.txt-Datei befindet sich in Ihrem WordPress-Stammverzeichnis und ist eine Textdatei. Um Suchmaschinen-Bots eine Vorstellung davon zu geben, welche Seiten Ihrer Website gecrawlt werden sollen, zeigt es eine Liste an, welche Seiten gecrawlt werden sollen und welche nicht. Es ist möglich, die Datei anzuweisen, das Crawlen zu vermeiden, anstatt zu indizieren. In Fällen, in denen bösartige Bots Ihre Website beschädigt haben, ist ein gutes Sicherheits-Plugin unerlässlich. WordPress erstellt eine virtuelle robots.txt-Datei für jede Website, die sie verwendet. Wenn Sie etwas ändern möchten, haben Sie drei Möglichkeiten. Das SEO-Plugin Yoast, eines der beliebtesten Tools zur Optimierung von Websites, ist eine ausgezeichnete Wahl.

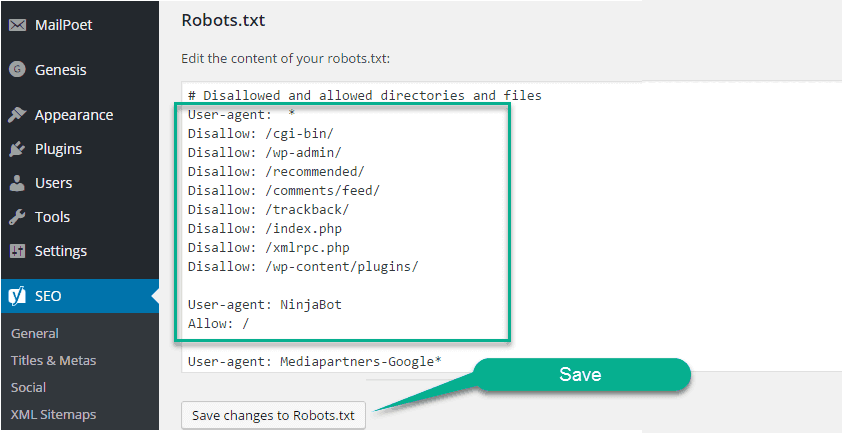

All in One SEO, ein weiteres kostenloses SEO-Plugin, bietet eine Vielzahl zusätzlicher Funktionen. Wenn Sie zuvor FTP verwendet haben, wissen Sie, dass Sie robots.txt-Dateien auf Ihren Server hochladen können. In der robots.txt-Datei wird ein neuer Abschnitt mit dem Namen Robots.txt angezeigt, in dem Sie der Datei anschließend Regeln und Anweisungen hinzufügen können. User-agent und Disallow sind beides Direktiven, die in dieser Datei enthalten sind. Wenn Sie einen einzelnen Bot angeben möchten (z. B. Bingbot) oder wenn die Anweisungen für alle Bots gelten sollen, geben Sie ein Sternchen ein (User-Agent: *). Übermäßige Crawling-Anforderungen überlasten den Server, was dazu führt, dass eine Crawl-Delay-Anweisung verwendet wird. Da es keine Crawler gibt, die diese Anweisung unterstützen, ist es am besten, sie mit Vorsicht zu verwenden.

Suchmaschinen werden zu Ihrer XML-Sitemap-Datei geleitet, wenn Sie die Sitemap-Anweisung verwenden. In den folgenden Abschnitten zeigen wir Ihnen zwei Beispielausschnitte, die die Verwendung von robots.txt-Anweisungen demonstrieren. Jede WordPress-Site hat eine robots.txt-Datei in ihrem Stammverzeichnis. Darin erhalten Crawler Anweisungen, welche Bereiche Ihrer Website sie durchsuchen sollen. Sie sollten oder sollten nicht über den Boden kriechen. Während unserer Diskussion haben wir Möglichkeiten behandelt, eine physische Version der Datei zu erstellen und sie zu bearbeiten.

Sollten Sie Ihrer WordPress-Website eine Robots.txt-Datei hinzufügen?

Sobald WordPress installiert ist, generiert es automatisch eine robots.txt-Datei. Ein Suchmaschinen-Indexer legt dieses Verzeichnis ab, um zu bestimmen, welche Seiten einer Website indiziert sind. Robots.txt-Dateien müssen in den meisten Fällen nicht zu WordPress-Websites hinzugefügt werden. Um jedoch Ihr Suchmaschinenranking zu verbessern, können Sie eine robots.txt-Datei hinzufügen, um den Suchmaschinenindex zu verwalten.

Wie öffne ich eine Robots-TXT-Datei in WordPress?

Bildnachweis: www.hitechwork.com

Bildnachweis: www.hitechwork.comEs gibt verschiedene Möglichkeiten, eine robots.txt-Datei in WordPress zu öffnen. Eine Möglichkeit besteht darin, einfach zu Ihrem WordPress-Installationsordner zu gehen und die Datei in einem Texteditor zu öffnen. Eine andere Möglichkeit besteht darin, ein Plugin wie WP Robots Txt zu verwenden, um die Datei im WordPress-Adminbereich zu bearbeiten.

Es gibt eine robots.txt-Datei, die auf fast jeder Website zu finden ist, aber die meisten Leute verstehen nicht, was sie tut oder wie man sie benutzt. In diesem Leitfaden sehen wir uns die Datei und ihre Einschränkungen an, um zu erfahren, wie Sie den Zugriff auf Ihre Website verwalten. Selbst wenn auf eine Seite Links verweisen, kann sie dennoch von Suchmaschinen indexiert werden, wenn sie von robots.txt blockiert wird. Google greift nicht auf die markierten Bereiche Ihrer Website zu. Laut John Mueller, Google Webmaster Analyst, kann ein Noindex-Tag zu einer Seite hinzugefügt werden, die nicht von Google blockiert wurde. Sie können das beliebte Yoast SEO-Plugin verwenden, um eine SEO-Vorlage zu erstellen (und später zu bearbeiten). Fügen Sie Ihre robots.txt-Datei an der richtigen Stelle ein, indem Sie mit der rechten Maustaste auf die Benutzeroberfläche von Yoast klicken.

Ebenso können Sie diese Art der Integration im All-in-One-SEO-Plugin implementieren. Bitte lesen Sie weiter, um weitere Informationen zu den verschiedenen Arten von Anweisungen zu erhalten, die in Ihrer WordPress robots.html-Datei angegeben werden müssen. Bevor Sie Regeln hinzufügen, müssen Sie zuerst auswählen, für welchen User-Agent die Regel gelten soll, gefolgt von der Anzahl der anzuwendenden Regeln mit Disallow und Allow. Den Zugriff auf einen Ordner und seine untergeordneten Ordner zu verweigern, aber den Zugriff auf den bestimmten Ordner eines bestimmten untergeordneten Ordners zuzulassen, kann eine gute Idee sein, wenn Sie den Zugriff auf einen Ordner und seine untergeordneten Ordner einschränken möchten. Zulassen ermöglicht Ihnen, Zugriff auf eine bestimmte Datei in einem bestimmten Ordner zu gewähren, verhindert jedoch den Zugriff auf einen gesamten Ordner. WordPress verwendet beim Verarbeiten von Abfragen einen Abfrageparameter namens?s=. Sie müssen nur die folgende Regel hinzufügen, um eine Zugriffssperre zu konfigurieren.

Soft 404-Fehler können auch vermieden werden, indem Sie diese Funktion verwenden und sie blockieren, wenn sie auftreten. Auch wenn Sie auf eine bestimmte Region außerhalb der USA abzielen, ist es nicht erforderlich, den Googlebot am Betreten des Landes zu hindern. Google ist irritiert, dass ein Befehl mit unsichtbarem Zeichen nicht verstanden wird. Schade, dass dadurch die erste Zeile unserer robots.txt-Datei ungültig wird. Es ist nicht dasselbe wie die Verwendung eines noindex-Tags in robots.txt-Dateien, die als Disallow-Befehle bezeichnet werden. Bots.txt hingegen indiziert nicht, verhindert aber das Crawlen. Sie können damit konfigurieren, wie Suchmaschinen und andere Bots mit Ihrer Website interagieren, indem Sie bestimmte Regeln hinzufügen. Für die meisten Benutzer, die WordPress überhaupt nicht verwenden, ist es nicht erforderlich, die standardmäßige virtuelle robots.html-Datei zu ändern. Sie können jedoch Ihre eigenen Regeln hinzufügen, wenn Sie Probleme mit einem bestimmten Bot oder Plugin haben.

So fügen Sie Ihrer Website eine robots.txt-Datei hinzu

Wenn Sie WordPress verwenden, können Sie diese Datei ganz einfach zu Ihrer Website hinzufügen, indem Sie den Assistenten zum Hinzufügen neuer Seiten verwenden. Geben Sie dann im Feld Datei-URL die URL für die robots.txt-Datei ein. Diese Datei kann auch zu einer WordPress-Seite hinzugefügt werden, indem Sie im Dashboard auf den Menüpunkt Seiten verwalten klicken.

Wenn Sie WordPress nicht verwenden, müssen Sie möglicherweise die robots.txt-Datei auf andere Weise zu Ihrer Website hinzufügen. Wenn Sie einen FTP-Client auf Ihrem Computer installiert haben, können Sie diese Datei einfach hinzufügen; Wenn Sie einen Dateimanager auf Ihrem Computer installiert haben, können Sie ihn einfach hinzufügen.

Brauche ich eine Robots Txt-Datei WordPress?

Bildnachweis: pressidium.com

Bildnachweis: pressidium.comAuf diese Frage gibt es keine endgültige Antwort, da dies von der jeweiligen WordPress-Site und der Art des Inhalts oder der Funktionalität abhängt, die sie hat. Im Allgemeinen ist eine robots.txt-Datei für WordPress jedoch nicht unbedingt erforderlich, obwohl sie in einigen Fällen nützlich sein kann. Wenn eine WordPress-Site beispielsweise viele sensible oder vertrauliche Informationen enthält, kann eine robots.txt-Datei verwendet werden, um zu verhindern, dass Suchmaschinen diese Inhalte indizieren.

Die robots.txt-Datei ist eine einfache Textdatei, die Suchmaschinen mitteilt, wo und wann sie Ihre Website nicht crawlen sollen. Mit dieser Funktion können Sie verhindern, dass Suchmaschinen auf verschiedene Dateien und Ordner auf Ihrer Website zugreifen. In diesem Artikel zeigen wir Ihnen, wie Sie eines erstellen, und geben Ihnen einige Plugins, die wir empfehlen, damit Sie die Arbeit selbst erledigen können. Jede Suchmaschine enthält einen Web-Crawling-Benutzeragenten in ihren Suchergebnissen. Der Googlebot zum Beispiel indiziert den Inhalt Ihrer Website für die Suchmaschine von Google. Sie haben die Möglichkeit, für jeden dieser Benutzeragenten eine benutzerdefinierte Anweisung zu konfigurieren. Auf die robots.txt-Datei kann zugegriffen werden, indem Sie „/robots.txt“ nach dem Domainnamen eingeben.

Sie können den Roboter anweisen, nach dem Einlösen des Schrägstrichs keine Seiten der Website anzuzeigen, indem Sie dem Link folgen. Ein Budget-Crawling ist definiert als die Anzahl der URLs, die ein Suchmaschinen-Bot in einer Sitzung crawlen kann. Jede Website verfügt über ein bestimmtes Crawl-Budget. Wenn Sie viele Seiten auf Ihrer Website haben, sollten Sie zuerst prüfen, ob der Bot Ihre wertvollsten Seiten crawlt. Mit dem Yoast SEO-Plugin von WordPress können Sie ganz einfach robots.txt-Dateien von Ihrem Dashboard aus erstellen. Verwenden Sie als Nächstes einen FTP-Client wie Filezilla, um die Datei manuell hochzuladen. Wenn Sie die Datei auf Ihrer Website anzeigen möchten, stellen Sie sicher, dass sie sich im Stammordner befindet.

Um eine zu erstellen, müssen Sie einen Texteditor wie Notepad verwenden, wenn die Datei nicht vorhanden ist. Die robots.txt-Datei sollte sich immer im Stammverzeichnis Ihrer Website befinden. Suchmaschinen werden Ihre Website weiterhin durchsuchen und indizieren, unabhängig davon, ob Sie diese Datei haben oder nicht. Es ist einfach, Ihre robots.txt-Datei in der Google Search Console zu testen. Indem Sie auf "Property jetzt hinzufügen" klicken, können Sie Ihre Website innerhalb weniger Minuten zur Google-Suche hinzufügen. Es ist wichtig, auf jeder Website ein bestimmtes Crawl-Budget einzuhalten. Sie müssen die Anzahl der Seiten berücksichtigen, die ein Bot während einer Sitzung besuchen muss. Wenn der Bot das Crawlen aller Seiten Ihrer Website während der Sitzung nicht abschließt, kehrt er zu Ihrer Website zurück und setzt das Crawlen in der nächsten Sitzung fort. Eine schnelle Lösung besteht darin, Such-Bots daran zu hindern, unnötige Seiten, Mediendateien, Plugins, Themenordner usw. zu crawlen, wodurch Ihr Crawling-Kontingent gespart wird.

Um es einfach auszudrücken, fügen Sie Ihrer robots.txt-Datei die folgende Zeile hinzu: Agents: users. Der Googlebot-Dienst wird derzeit verwendet. Wenn Sie keine robots.txt-Datei haben, crawlt der Googlebot Ihre Seiten und indexiert sie automatisch in der Suchmaschine.

Warum Sie eine Robots.txt-Datei hinzufügen sollten, um Ihr SEO zu verbessern

Sie können das Suchmaschinenranking Ihrer Website verbessern, indem Sie eine robots.txt-Datei herunterladen. Crawler suchen nach dieser Datei im Stammverzeichnis Ihrer Website, um festzustellen, ob Inhalte zulässig sind und warum.

Bearbeiten Sie Robots.txt WordPress

Wenn Sie Ihre robots.txt-Datei bearbeiten möchten, können Sie dies tun, indem Sie zu Ihrem WordPress-Dashboard gehen und dann auf die Registerkarte „Einstellungen“ klicken. Von dort aus finden Sie den Abschnitt „Lesen“, in dem Sie Ihre robots.txt-Datei bearbeiten können.

Eine robots.txt-Datei teilt den Suchmaschinen nicht nur mit, wohin Ihre Website gehen darf, sondern auch, wie sie gecrawlt werden soll. Wenn Sie Ihre Bots anweisen, keine unnötigen Seiten auf Ihrer Website zu crawlen, können Sie die Ladegeschwindigkeit erhöhen und möglicherweise in Suchmaschinen einen höheren Rang einnehmen. In diesem Beitrag zeigen wir Ihnen, wie Sie Ihre robots.html-Datei mit WordPress bearbeiten. Die robots.txt-Datei ist aus bestimmten Gründen erforderlich. Bei Verwendung eines Meta-Noindex-Tags anstelle von robots.txt beim Laden einer Website. Warum es in unserem Leben so wichtig ist. Während Sie mit dem System angeben können, welche Suchmaschinen und andere Bots mit Ihrer Website interagieren, verbietet es Suchmaschinen oder anderen Bots nicht ausdrücklich, Ihre Inhalte zu indizieren.

Schauen wir uns Schritt für Schritt an, wie man robots.html-Dateien in WordPress mit AIOSEO bearbeitet. Mit dem Regel-Builder können Sie Ihre eigenen Regeln für bestimmte Seiten erstellen, die von Robotern besucht oder nicht besucht werden können. Beim Erstellen einer benutzerdefinierten Regel können Sie den User Agent (z. B. Googlebot-Crawler ) in das Feld User Agents eingeben. Sie müssen den Verzeichnispfad oder Dateinamen in das Feld Verzeichnispfad eingeben, nachdem Sie festgelegt haben, welche Bots zugelassen oder abgelehnt werden sollen. Wenn Sie Ihre neuen Regeln speichern, werden sie im Vorschaubereich von Robots.txt angezeigt. Sie können Ihre robots.txt-Datei sehen, indem Sie auf Open Robots klicken. Dieser Text wird an Ihr mobiles Gerät gesendet, sobald er verfügbar ist. Indem Sie einfach die Details Ihrer Regeln eingeben, können Sie sie ändern. Einige Beispiele für das Löschen von Regeln werden in einem separaten Abschnitt gezeigt.

Standard-Robots.txt für WordPress

Wenn Sie eine WordPress-Site erstellen und keine benutzerdefinierte robots.txt-Datei erstellen, generiert Ihre Site automatisch eine standardmäßige robots.txt-Datei, die Folgendes enthält: User-agent: * Disallow: / The first line, User-agent: * , gilt für alle Webcrawler . Die zweite Zeile, Disallow: /, weist alle Webcrawler an, keine Seiten Ihrer Website zu indizieren. Dies ist die restriktivste Einstellung und wird für die meisten WordPress-Sites nicht empfohlen.

Die Verwendung einer gut strukturierten robots.txt-Datei ermöglicht es Ihnen, Suchmaschinen-Bots auf Ihre Website zu leiten. Ihnen wird gesagt, dass sie sich von diesen Räumen fernhalten sollen, während sie sie sich ansehen. Auch wenn Sie kein technischer Experte sind, können Sie diese Datei nach Ihren Bedürfnissen erstellen, auch wenn Sie keine Programmierkenntnisse haben. Wenn Sie eine WordPress-Website erstellen, wird eine virtuelle robots.txt-Datei für Sie erstellt. Bots werden daran gehindert, basierend auf dieser Datei auf die Verzeichnisse administrator und WP-includes zuzugreifen. Um Änderungen vorzunehmen, müssen Sie zuerst eine neue Datei erstellen und diese dann in den Stammordner hochladen. Robots.txt kann in WordPress auf zwei Arten bearbeitet werden: über ein Plugin oder manuell.

Wir haben einen neuen Satz von Regeln erstellt, um zu verhindern, dass der Suchbot von Bing in diesem Beispiel unsere Website durchsucht. Ihre Anweisungen in dieser Datei werden mit ziemlicher Sicherheit von den meisten Bots befolgt, aber Sie versuchen nicht, sie dazu zu zwingen. Nachdem Sie das Yoast SEO-Plugin für WordPress installiert und aktiviert haben, können Sie robots.txt-Dateien direkt vom WordPress-Dashboard aus bearbeiten. Das All-in-One-SEO-Paket ist das andere SEO-Paket, auf das Sie achten sollten, wenn es um WordPress SEO geht, und es ist auch sehr einfach zu bedienen. Yoast ist ein ähnliches Produkt, aber es ist viel leichter. Es ist so einfach wie das Eingeben einiger Textzeilen in Notepad oder TextEdit, um eine robots.txt-Datei zu erstellen. Um die Datei zu testen, laden Sie sie per FTP hoch und verwenden Sie dann die Google Search Console.

Das All In One SEO Pack enthält ein Tool, mit dem „böse“ Bots blockiert werden können. Wenn Sie die Sichtbarkeit Ihrer Website erhöhen möchten, ist es entscheidend, dass Suchmaschinen-Bots die relevantesten Informationen crawlen. WordPress-robots.txt-Dateien machen es einfach, anzugeben, wie Ihre Bots mit Ihrer Website interagieren. Es wird ihnen leichter fallen, Suchmaschinen relevante und nützliche Inhalte zu präsentieren.

So aktualisieren Sie Ihre WordPress Robots.txt-Datei

Wenn das Stammverzeichnis der Website keine physische Datei enthält, generiert WordPress eine virtuelle robots.txt-Datei. Um die virtuelle Datei zu aktivieren, müssen Sie sie zunächst folgendermaßen überschreiben: Öffnen Sie Ihren Browser und navigieren Sie zum Stammverzeichnis Ihrer Website.

Überprüfen Sie die robots.txt-Datei.

Bitte nehmen Sie alle notwendigen Änderungen an der Datei vor.

Überprüfen Sie, ob Sie die Datei gespeichert haben.

Ihre Website muss neu geladen werden.

Die robots.txt-Datei kann aktualisiert werden, indem Sie zum Menü „Plugins“ in der linken Seitenleiste gehen und danach suchen. Nehmen Sie Änderungen an der robots.txt-Datei vor, indem Sie im Menü „Einstellungen“ auswählen.