如何在 WordPress 中编辑 Robots.txt 文件

已发表: 2019-09-09本周,我们解决了初学者 WP 用户的另一个问题——如何在 WordPress 中编辑 robots.txt 文件。 这背后的原因很简单——它有利于您的 SEO 工作。 robots.txt 文件是 SEO 中一个非常强大的工具,因为它可以作为搜索引擎抓取机器人的网站指南。 这就是为什么 WordPress 专家认识到它的重要性以及如何最好地将其实施到他们网站的优化中。 在这里,我们逐步了解整个主题。

我们从 robots.txt 文件的更详细定义开始

搜索引擎机器人需要有关如何抓取和索引站点内页的说明。 这就是 robots.txt 文件发挥作用的地方。 该文件列出了页面的结构,使搜索引擎机器人易于阅读和评分。

您通常可以找到存储在根目录中的 robots.txt 文件。 该目录也被称为您整个网站的主文件夹。 在我们了解如何在 WordPress 中编辑 robots.txt 文件之前,我们首先需要学习如何识别它。 因此,以下是典型 robots.txt 文件外观的示例:

| 1 2 3 4 5 6 7 8 | 用户代理:[用户代理名称] Disallow: [不被抓取的 URL 字符串] 用户代理:[用户代理名称] 允许:[要抓取的 URL 字符串] 站点地图:[您的 XML 站点地图的 URL] |

该文件本身提供了足够的自定义空间,例如允许/禁止特定 URL 或添加多个站点地图文件。 因此,如果您有一个不希望搜索引擎机器人抓取和排名的 URL,您需要通过 robots.txt 禁止它。 以下是允许/禁止搜索引擎机器人抓取特定 URL 的示例:

| 1 2 3 4 5 6 | 用户代理: * 允许:/wp-content/uploads/ 禁止:/wp-content/plugins/ 禁止:/wp-admin/ 站点地图:https://example.com/sitemap_index.xml |

最后,我们将站点地图添加到组合中,使 URL 对搜索引擎机器人可见。

在 WordPress 中拥有 robots.txt 文件的重要性

需要了解的重要一点是,即使您没有 robots.txt 文件,搜索引擎机器人仍会抓取您的网页。 但是,它们会爬取所有这些。 您将无法订购他们应该和不应该抓取哪些页面。

对于新的 WP 网站,这可能不会出现太大或问题。 但是,对于那些内容无穷无尽的网站,您将希望更好地控制它的抓取和索引方式。 robots.txt 文件提供了一种正确的方式来维护您的 WordPress 网站以及搜索引擎机器人如何看待它。

首先,为什么这如此重要?

每个网站都有一个抓取配额——这就是搜索引擎机器人的功能。 这意味着机器人将一次抓取您的网站一页。 如果他们在一个会话期间未能完成对您所有页面的抓取,他们将在下一次恢复抓取。 这会显着降低您网站的索引速度(索引速度) 。

但是,当您在 WordPress 中编辑 robots.txt 文件以禁止某些页面抓取时,您会保存抓取配额。 WP 用户通常不允许的最常见和不必要的页面包括 WordPress 管理页面、插件和主题。 删除这些页面后,您就可以为爬虫提供更多空间来索引您网站上的其他相关页面。

WordPress 中完美的 robots.txt 文件应该是什么样的?

流行的博客网站选择了 robots.txt 文件的简单示例——这种形式根据该网站的需要而有所不同:

| 1 2 3 4 5 | 用户代理: * 不允许: 站点地图:https://www.example.com/post-sitemap.xml 站点地图:https://www.example.com/page-sitemap.xml |

此示例显示如何允许机器人索引所有内容,并在此过程中为其提供指向网站 XML 站点地图的链接。

但是,这是WordPress 网站用户如何在 WordPress 中编辑 robots.txt 文件的推荐表格:

| 1 2 3 4 5 6 7 8 9 | 用户代理: * 允许:/wp-content/uploads/ 禁止:/wp-content/plugins/ 禁止:/wp-admin/ 禁止:/readme.html 禁止:/refer/ 站点地图:https://www.example.com/post-sitemap.xml 站点地图:https://www.example.com/page-sitemap.xml |

在这里,您可以清楚地看到机器人被指示索引所有 WP 图像和文件。 但是,它也不允许搜索引擎机器人索引以下内容:

- WP插件文件

- WP管理区

- WP 自述文件

- 附属链接

您应该向 XML 站点地图添加链接的原因是为了让机器人更容易找到您网站上的所有页面。

如何在 WordPress 中创建和编辑 robots.txt 文件

与所有 WordPress 一样,每项任务都有多种解决方案。 因此,实际上有两种方法可以在 WordPress 中创建 robots.txt:

解决方案 #1:使用 Yoast SEO 在 WordPress 中编辑 robots.txt 文件

如果您使用的是 Yoast SEO 插件,那么您很幸运! 该插件带有 robots.txt 文件生成器。 您可以使用此生成器直接从您的管理员角色仪表板创建和编辑 robots.txt 文件。

您所要做的就是以管理员身份进入 SEO >> 工具页面。 在那里,单击文件编辑器链接。 它引导您进入的页面应该包含现有的 robots.txt 文件。 如果没有,Yoast SEO 将为您生成一个文件。 某些版本的 Yoast SEO 会生成以下格式的默认文件:

| 1 2 | 用户代理: * 不允许: / |

一旦发生这种情况,您应该确保删除此文本,否则它将阻止所有机器人抓取您的网站。 删除默认文本后,请确保输入您自己的 robots.txt 脚本版本。 您可以使用我们之前共享的模板。

完成文件编辑后,您只需单击“保存 robots.txt 文件”并存储您的更改。

解决方案 #2:使用 FTP 在 WordPress 中手动编辑 robots.txt 文件

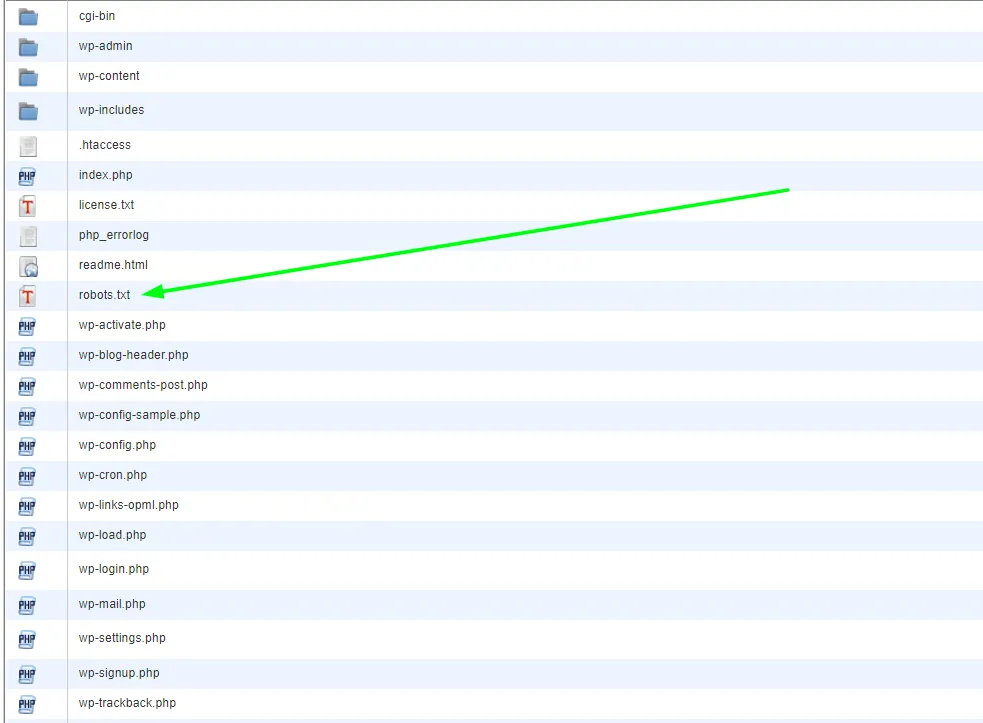

这种特殊方法需要使用 FTP 客户端来编辑文件。 因此,您要做的第一件事是使用 FTP 客户端连接到您的 WordPress 托管帐户。 在那里,您将在网站的根文件夹中找到 robots.txt 文件。

如果您找不到 robots.txt 文件,那么您的 WP 网站很可能没有。 如果是这种情况,您可以继续创建一个。 鉴于robots.txt 文件是纯文本文件,您可以简单地下载它,然后在任何纯编辑器(如记事本或 TextEdit )中对其进行编辑。 编辑文件后,您只需将其上传回您网站的根文件夹即可。

在 WordPress 中编辑 robots.txt 文件后,请务必对其进行测试

测试始终是编辑之后的下一个合乎逻辑的步骤。 由于我们之前提到的原因,这在涉及 robots.txt 的情况下尤其重要。 不用担心 - 您可以使用一些工具来测试它。 我们最推荐的是Google Search Console 。

如果您没有帐户,请创建一个帐户,并在登录后切换到旧的 Google 搜索控制台网站。 一旦您有了旧界面,您将需要启动 robots.txt 测试器。 该工具位于“抓取”菜单下。 此工具会自动提取您网站的 robots.txt 文件并突出显示它发现的任何错误。

最后的想法

总之,拥有 robots.txt 文件是推进您的 SEO 策略的一个非常重要的工具。 因此,学习如何在 WordPress 中创建和编辑 robots.txt 文件绝对是向前迈出的一步。 有关 WordPress 的任何其他问题或教程,请访问我们的博客或直接与我们联系。