Jak edytować plik Robots.txt w WordPress

Opublikowany: 2019-09-09W tym tygodniu zajmiemy się kolejnym pytaniem, które mają początkujący użytkownicy WP – jak edytować plik robots.txt w WordPressie. Powód tego jest dość prosty – przynosi korzyści w działaniach SEO . Plik robots.txt jest niesamowicie potężnym narzędziem w SEO, ponieważ działa jako przewodnik po stronie dla robotów indeksujących wyszukiwarki . Dlatego eksperci WordPressa dostrzegają jego znaczenie i najlepsze sposoby wdrożenia go do optymalizacji swojej witryny. Oto nasze podejście do całego tematu krok po kroku .

Zaczynamy od bardziej szczegółowej definicji pliku robots.txt

Boty wyszukiwarek potrzebują instrukcji dotyczących przeszukiwania i indeksowania wewnętrznych stron Twojej witryny . Tutaj do gry wchodzą pliki robots.txt. Ten plik określa strukturę Twoich stron, dzięki czemu są łatwe do odczytania i oceny przez boty wyszukiwarek.

Zazwyczaj plik robots.txt można znaleźć w katalogu głównym. Wiadomo również, że ten katalog jest głównym folderem całej witryny . Zanim przejdziemy do edycji pliku robots.txt w WordPressie, najpierw musimy nauczyć się go rozpoznawać. Oto przykład, jak wygląda typowy plik robots.txt:

| 1 2 3 4 5 6 7 8 | Klient użytkownika: [nazwa klienta użytkownika] Disallow: [ciąg adresu URL, którego nie należy indeksować] Klient użytkownika: [nazwa klienta użytkownika] Zezwól: [ciąg adresu URL do zindeksowania] Mapa witryny: [URL Twojej mapy witryny XML] |

Sam plik oferuje dużo miejsca na personalizację, na przykład zezwalanie/nie zezwalanie na określone adresy URL lub dodawanie wielu plików map witryn . Tak więc, jeśli masz adres URL, którego nie chcesz, aby roboty wyszukiwarek indeksowały i pozycjonowały, musisz zabronić go za pomocą pliku robots.txt. Oto przykład zezwalania/nie zezwalania robotom wyszukiwarek na indeksowanie określonych adresów URL:

| 1 2 3 4 5 6 | Agent użytkownika: * Zezwól: /wp-content/uploads/ Disallow: /wp-content/plugins/ Nie zezwalaj: /wp-admin/ Mapa witryny: https://example.com/sitemap_index.xml |

Na koniec dodajemy naszą mapę witryny do miksu, dzięki czemu adres URL jest widoczny dla robotów wyszukiwarek.

Znaczenie posiadania pliku robots.txt w WordPress

Ważne jest, aby zrozumieć, że nawet jeśli nie masz pliku robots.txt, roboty wyszukiwarek będą nadal indeksować Twoje strony . Jednak będą indeksować je wszystkie. Nie będzie można ustalić, które strony powinny, a które nie powinny być indeksowane.

W przypadku świeżych witryn WP może to nie stanowić zbyt dużego problemu. Jednak w przypadku witryn z nieskończoną zawartością będziesz chciał mieć lepszą kontrolę nad sposobem ich przeszukiwania i indeksowania . Plik robots.txt zapewnia właściwy sposób na utrzymanie witryny WordPress i sposób, w jaki widzą ją boty wyszukiwarek.

Dlaczego jest to takie ważne na początek?

Każda witryna ma określony limit indeksowania – tak działają boty wyszukiwarek. Oznacza to, że boty będą indeksować Twoją witrynę po jednej stronie na raz. Jeśli nie zakończą indeksowania wszystkich Twoich stron podczas jednej sesji, wznowią indeksowanie następnym razem. I to jest coś, co może znacznie spowolnić indeksację Twojej witryny ( szybkość indeksowania ) .

Jednak edytując plik robots.txt w WordPressie, aby uniemożliwić indeksowanie niektórych stron , oszczędzasz przydział indeksowania . Najczęstsze i niepotrzebne strony, których użytkownicy WP zwykle nie zezwalają, obejmują strony administracyjne WordPress, wtyczki i motywy. Po wyeliminowaniu tych stron dajesz robotom więcej miejsca na indeksowanie innych odpowiednich stron w Twojej witrynie.

Jak powinien wyglądać idealny plik robots.txt w WordPressie?

Popularne blogi wybierają uproszczony przykład pliku robots.txt – postaci, która różni się w zależności od potrzeb tej witryny:

| 1 2 3 4 5 | Agent użytkownika: * Uniemożliwić: Mapa witryny: https://www.example.com/post-sitemap.xml Mapa witryny: https://www.example.com/page-sitemap.xml |

Ten przykład pokazuje, jak zezwolić botom na indeksowanie całej zawartości, podając w procesie link do mapy witryny XML witryny.

Jest to jednak zalecany formularz dla użytkowników witryny WordPress, jak edytować plik robots.txt w WordPress :

| 1 2 3 4 5 6 7 8 9 | Agent użytkownika: * Zezwól: /wp-content/uploads/ Disallow: /wp-content/plugins/ Nie zezwalaj: /wp-admin/ Nie zezwalaj: /readme.html Nie zezwalaj: /odsyłaj/ Mapa witryny: https://www.example.com/post-sitemap.xml Mapa witryny: https://www.example.com/page-sitemap.xml |

Tutaj wyraźnie widać, że boty mają indeksować wszystkie obrazy i pliki WP . Jednak uniemożliwia również robotom wyszukiwarek indeksowanie następujących elementów:

- Pliki wtyczek WP

- Obszar administracyjny WP

- Plik readme WP

- Linki afiliacyjne

Powodem, dla którego powinieneś dodać link do mapy witryny XML, jest ułatwienie botom znajdowania wszystkich stron w Twojej witrynie.

Jak stworzyć i edytować plik robots.txt w WordPressie

Jak każdy WordPress, istnieją wszechstronne rozwiązania dla każdego zadania. Tak więc w rzeczywistości istnieją dwa sposoby na utworzenie pliku robots.txt w WordPress:

Rozwiązanie nr 1: Używanie Yoast SEO do edycji pliku robots.txt w WordPress

Jeśli korzystasz z wtyczki Yoast SEO, masz szczęście! Wtyczka zawiera generator plików robots.txt . Za pomocą tego generatora możesz tworzyć i edytować plik robots.txt bezpośrednio z pulpitu nawigacyjnego roli administratora.

Wszystko, co musisz zrobić, to przejść do strony SEO >> Narzędzia jako administrator . Tam kliknij link Edytor plików. Strona, do której prowadzi, powinna zawierać istniejący plik robots.txt. A jeśli tak się nie stanie, Yoast SEO wygeneruje dla Ciebie plik. Niektóre wersje Yoast SEO wygenerują domyślny plik w następującej formie:

| 1 2 | Agent użytkownika: * Uniemożliwić: / |

Gdy tak się stanie, upewnij się, że usuniesz ten tekst , ponieważ w przeciwnym razie zablokuje to wszystkim botom indeksowanie Twojej witryny. Po usunięciu tekstu domyślnego pamiętaj o wprowadzeniu własnej wersji skryptu robots.txt. Możesz skorzystać z szablonu, który udostępniliśmy wcześniej.

Po zakończeniu edycji pliku wystarczy kliknąć opcję „ Zapisz plik robots.txt ” i zapisać zmiany.

Rozwiązanie nr 2: Używanie FTP do ręcznej edycji pliku robots.txt w WordPress

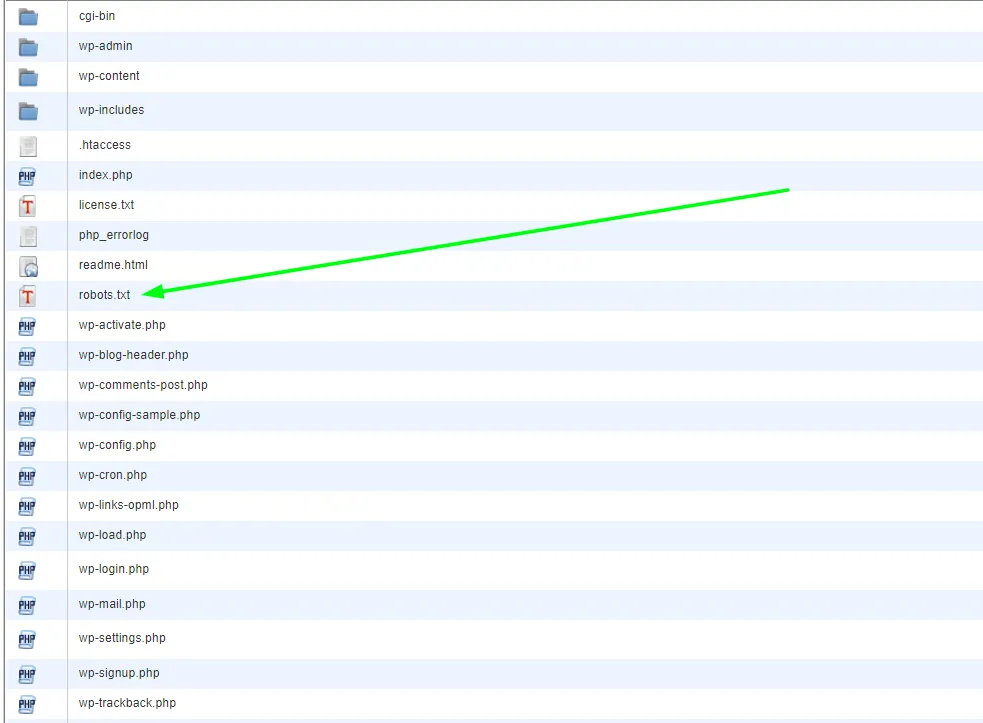

To szczególne podejście wymaga użycia klienta FTP do edycji pliku. Pierwszą rzeczą, którą chcesz zrobić, to użyć klienta FTP do połączenia się z kontem hostingowym WordPress . Tam znajdziesz plik robots.txt w folderze głównym swojej witryny.

Jeśli nie możesz znaleźć pliku robots.txt, oznacza to, że Twoja witryna WP najprawdopodobniej go nie ma. Jeśli tak jest, możesz śmiało je utworzyć. Biorąc pod uwagę fakt, że plik robots.txt jest zwykłym plikiem tekstowym , można go po prostu pobrać, a następnie edytować w dowolnym zwykłym edytorze, takim jak Notatnik lub TextEdit . Po edycji pliku możesz po prostu przesłać go z powrotem do folderu głównego witryny.

Po edycji pliku robots.txt w WordPressie przetestuj go

Testowanie jest zawsze kolejnym logicznym krokiem po edycji. Jest to szczególnie ważne w przypadkach, które dotyczą pliku robots.txt, z powodów, o których wspomnieliśmy wcześniej. Nie martw się – istnieją narzędzia, których możesz użyć, aby to przetestować. Najbardziej polecamy Google Search Console .

Utwórz konto, jeśli go nie masz, a po zalogowaniu przejdź do starej witryny konsoli wyszukiwania Google . Mając przed sobą stary interfejs, musisz uruchomić tester pliku robots.txt . Narzędzie znajduje się w menu „ Przeszukuj ”. To narzędzie automatycznie pobierze plik robots.txt Twojej witryny i zaznaczy wszelkie znalezione błędy.

Końcowe przemyślenia

Podsumowując, posiadanie pliku robots.txt jest bardzo ważnym narzędziem w promowaniu przyczyny twoich strategii SEO. Dlatego nauka tworzenia i edytowania pliku robots.txt w WordPressie jest zdecydowanie krokiem naprzód . W przypadku dodatkowych pytań lub samouczków dotyczących WordPressa odwiedź naszego bloga lub skontaktuj się z nami bezpośrednio.