WordPressでRobots.txtファイルを編集する方法

公開: 2019-09-09今週は、WPの初心者ユーザーが持つもう1つのクエリ、つまりWordPressでrobots.txtファイルを編集する方法に取り組みます。 この背後にある理由は十分に単純です-それはあなたのSEOの努力に利益をもたらします。 robots.txtファイルは、検索エンジンのクロールボットのウェブサイトガイドとして機能するため、SEOの非常に強力なツールです。 そのため、WordPressの専門家は、WordPressの重要性と、サイトの最適化にそれを実装するための最善の方法を認識しています。 ここでは、トピック全体を段階的に説明します。

まず、robots.txtファイルのより詳細な定義から始めます。

検索エンジンボットは、サイトの内部ページをクロールしてインデックスを作成する方法についての指示を必要とします。 そこでrobots.txtファイルが登場します。 このファイルはページの構造をレイアウトし、検索エンジンボットがページを読みやすく評価しやすくします。

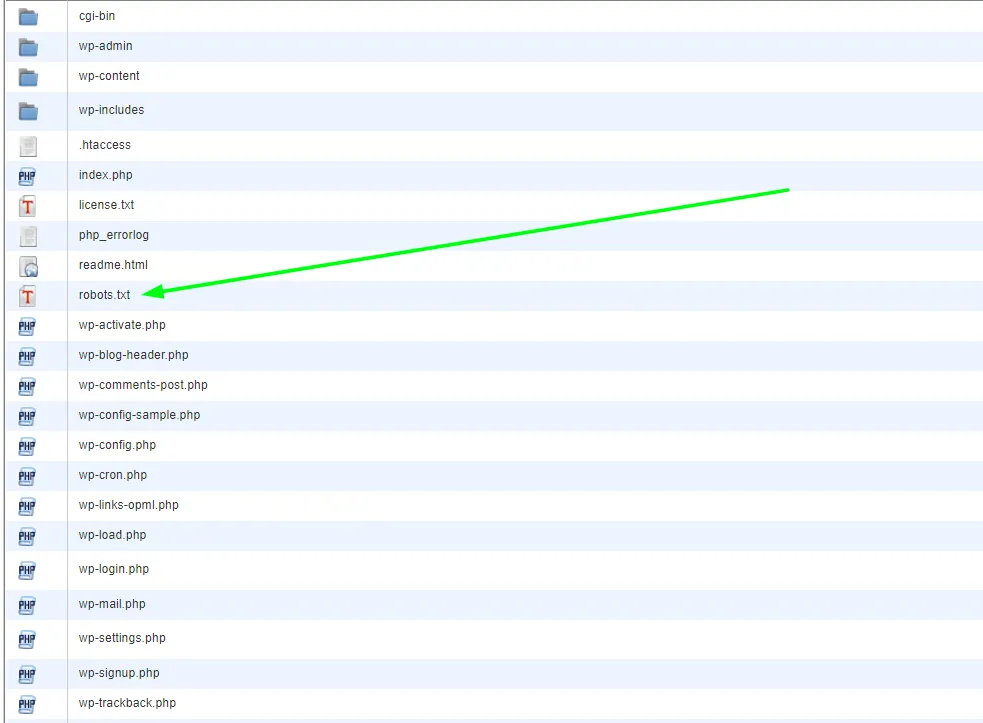

通常、robots.txtファイルはルートディレクトリに保存されています。 このディレクトリは、Webサイト全体のメインフォルダとしても知られています。 WordPressでrobots.txtファイルを編集する方法に入る前に、まずそれを認識する方法を学ぶ必要があります。 それで、これは典型的なrobots.txtファイルがどのように見えるかの例です:

| 1 2 3 4 5 6 7 8 | ユーザーエージェント:[ユーザーエージェント名] 禁止:[URL文字列はクロールされません] ユーザーエージェント:[ユーザーエージェント名] 許可:[クロールされるURL文字列] サイトマップ:[XMLサイトマップのURL] |

ファイル自体は、特定のURLを許可/禁止したり、複数のサイトマップファイルを追加したりするなど、カスタマイズのための十分なスペースを提供します。 したがって、検索エンジンボットがクロールしてランク付けしたくないURLがある場合は、robots.txtを介してそれを禁止する必要があります。 検索エンジンボットが特定のURLをクロールすることを許可/禁止する例を次に示します。

| 1 2 3 4 5 6 | ユーザーエージェント: * 許可:/ wp-content / uploads / 禁止:/ wp-content / plugins / 禁止:/ wp-admin / サイトマップ:https://example.com/sitemap_index.xml |

最後に、サイトマップをミックスに追加して、URLを検索エンジンボットに表示できるようにします。

WordPressにrobots.txtファイルを含めることの重要性

理解しておくべき重要なことは、robots.txtファイルがなくても、検索エンジンボットがページをクロールすることです。 ただし、それらはすべてクロールします。 クロールする必要があるページとクロールしないページを注文することはできません。

新しいWPWebサイトの場合、これは大きすぎたり問題になったりしない可能性があります。 ただし、コンテンツが無限にあるサイトの場合は、クロールとインデックス作成の方法をより適切に制御する必要があります。 robots.txtファイルは、WordPress Webサイトを維持する適切な方法と、検索エンジンボットがそれをどのように認識するかを提供します。

そもそも、なぜこれがそれほど重要なのですか?

各Webサイトにはクロールクォータがあります。これが検索エンジンボットの機能です。 これは、ボットが一度に1ページずつWebサイトをクロールすることを意味します。 1回のセッション中にすべてのページのクロールを完了できなかった場合、次回はクロールを再開します。 そして、これはあなたのサイトのインデックス作成(インデックス作成率)を大幅に遅くする可能性があるものです。

ただし、 WordPressでrobots.txtファイルを編集して特定のページのクロールを禁止すると、クロールクォータが保存されます。 WPユーザーが通常許可しない最も一般的で不要なページには、WordPress管理ページ、プラグイン、およびテーマが含まれます。 これらのページを削除すると、クローラーにサイト上の他の関連ページをインデックスに登録するためのより多くのスペースが与えられます。

WordPressの完璧なrobots.txtファイルはどのように見えるべきですか?

人気のあるブログサイトは、robots.txtファイルの単純な例を選択します。この形式は、そのサイトのニーズに応じて異なります。

| 1 2 3 4 5 | ユーザーエージェント: * 禁止: サイトマップ:https://www.example.com/post-sitemap.xml サイトマップ:https://www.example.com/page-sitemap.xml |

この例は、ボットがすべてのコンテンツにインデックスを付けて、プロセス中のWebサイトのXMLサイトマップへのリンクを与える方法を示しています。

ただし、これはWordPressWebサイトユーザーがWordPressでrobots.txtファイルを編集する方法として推奨されるフォームです。

| 1 2 3 4 5 6 7 8 9 | ユーザーエージェント: * 許可:/ wp-content / uploads / 禁止:/ wp-content / plugins / 禁止:/ wp-admin / 禁止:/readme.html 禁止:/ refer / サイトマップ:https://www.example.com/post-sitemap.xml サイトマップ:https://www.example.com/page-sitemap.xml |

ここでは、ボットがすべてのWPイメージとファイルにインデックスを付けるように指示されていることがはっきりとわかります。 ただし、検索エンジンボットが次のインデックスを作成することも禁止されています。

- WPプラグインファイル

- WP管理エリア

- WPreadmeファイル

- アフィリエイトリンク

XMLサイトマップにリンクを追加する必要がある理由は、ボットがサイト上のすべてのページを見つけやすくするためです。

WordPressでrobots.txtファイルを作成および編集する方法

すべてのWordPressと同様に、タスクごとに用途の広いソリューションがあります。 したがって、WordPressでrobots.txtを作成するには、実際には2つの方法があります。

解決策1:YoastSEOを使用してWordPressでrobots.txtファイルを編集する

Yoast SEOプラグインを使用している場合は、幸運です。 プラグインにはrobots.txtファイルジェネレータが付属しています。 また、このジェネレーターを使用して、管理者ロールダッシュボードから直接robots.txtファイルを作成および編集できます。

あなたがしなければならないのは、管理者としてSEO>>ツールページに行くことです。 そこで、[ファイルエディタ]リンクをクリックします。 表示されるページには、既存のrobots.txtファイルが含まれている必要があります。 そうでない場合は、YoastSEOがファイルを生成します。 Yoast SEOの一部のバージョンでは、次の形式のデフォルトファイルが生成されます。

| 1 2 | ユーザーエージェント: * 禁止:/ |

これが発生したら、このテキストを必ず削除する必要があります。そうしないと、すべてのボットがWebサイトをクロールできなくなります。 デフォルトのテキストを削除したら、robots.txtスクリプトの独自のバージョンを入力してください。 以前に共有したテンプレートを使用できます。

ファイルの編集が完了したら、[ robots.txtファイルを保存]をクリックして変更を保存するだけです。

解決策2:FTPを使用してWordPressでrobots.txtファイルを手動で編集する

この特定のアプローチでは、FTPクライアントを使用してファイルを編集する必要があります。 したがって、最初に実行したいのは、FTPクライアントを使用してWordPressホスティングアカウントに接続することです。 そこに到達すると、Webサイトのルートフォルダにrobots.txtファイルがあります。

robots.txtファイルが見つからない場合は、WPサイトにファイルがない可能性があります。 この場合は、先に進んで作成できます。 robots.txtファイルはプレーンテキストファイルであるため、ダウンロードして、メモ帳やテキストエディットなどのプレーンエディタで編集できます。 ファイルを編集したら、それをWebサイトのルートフォルダーにアップロードし直すだけです。

WordPressでrobots.txtファイルを編集したら、必ずテストしてください

テストは常に編集に続く次の論理的なステップです。 また、前述の理由により、robots.txtが関係する場合はこれが特に重要です。 心配しないでください–これをテストするために使用できるツールがあります。 私たちが最もお勧めするのはGoogle検索コンソールです。

アカウントをお持ちでない場合はアカウントを作成し、ログインしたら、古いGoogle検索コンソールのウェブサイトに切り替えます。 古いインターフェースが目の前にある場合は、robots.txtテスターを起動する必要があります。 このツールは、 [クロール]メニューの下にあります。 このツールは、Webサイトのrobots.txtファイルを自動的にプルアップし、検出したエラーを強調表示します。

最終的な考え

結論として、robots.txtファイルを持つことは、SEO戦略の原因を促進する上で非常に重要なツールです。 したがって、 WordPressでrobots.txtファイルを作成および編集する方法を学ぶことは、間違いなく一歩前進です。 WordPressに関するその他の質問やチュートリアルについては、ブログにアクセスするか、直接お問い合わせください。