Cum să editați un fișier Robots.txt în WordPress

Publicat: 2019-09-09Săptămâna aceasta, abordăm o altă întrebare pe care o au utilizatorii WP începători - cum să editați un fișier robots.txt în WordPress. Motivul din spatele acestui lucru este destul de simplu - vă avantajează eforturile SEO . Un fișier robots.txt este un instrument incredibil de puternic în SEO, deoarece funcționează ca un ghid pentru site-ul web pentru roboții de accesare cu crawlere ale motoarelor de căutare . De aceea, experții WordPress recunosc importanța acestuia și cum să o implementeze cel mai bine în optimizarea site-ului lor. Iată-ne , pas cu pas, abordarea întregului subiect .

Începem cu o definiție mai detaliată a fișierului robots.txt

Boții motoarelor de căutare au nevoie de instrucțiuni despre cum să acceseze cu crawlere și să indexeze paginile interioare ale site-ului dvs. Aici intră în joc fișierele robots.txt. Acest fișier prezintă structura paginilor dvs., făcându-le ușor de citit și evaluat de către roboții motoarelor de căutare.

De obicei, puteți găsi fișierul robots.txt stocat în directorul rădăcină. Acest director este, de asemenea, cunoscut a fi folderul principal al întregului site web . Înainte de a înțelege cum să edităm un fișier robots.txt în WordPress, trebuie mai întâi să învățăm cum să-l recunoaștem. Deci, iată un exemplu despre cum arată un fișier robots.txt tipic:

| 1 2 3 4 5 6 7 8 | Agent utilizator: [nume agent utilizator] Nu permiteți: [Șirul URL nu trebuie accesat cu crawlere] Agent utilizator: [nume agent utilizator] Permiteți: [șirul URL să fie accesat cu crawlere] Harta site-ului: [URL-ul sitemapului dvs. XML] |

Fișierul în sine oferă mult spațiu pentru personalizare, cum ar fi permisiunea/interzicerea anumitor adrese URL sau adăugarea mai multor fișiere sitemap . Deci, dacă aveți o adresă URL pe care nu doriți ca roboții motoarelor de căutare să o acceseze cu crawlere și să o clasifice, trebuie să o interziceți prin robots.txt. Iată un exemplu de a permite/interzice roboții motoarelor de căutare să acceseze cu crawlere anumite adrese URL:

| 1 2 3 4 5 6 | Agent utilizator: * Permite: /wp-content/uploads/ Nu permiteți: /wp-content/plugins/ Nu permiteți: /wp-admin/ Harta site-ului: https://example.com/sitemap_index.xml |

În cele din urmă, adăugăm sitemap-ul nostru la amestec, făcând adresa URL vizibilă pentru roboții motoarelor de căutare.

Importanța de a avea un fișier robots.txt în WordPress

Lucrul important de înțeles este că, chiar dacă nu aveți un fișier robots.txt, roboții motoarelor de căutare tot vor accesa cu crawlere paginile dvs. Cu toate acestea, le vor târî pe toate. Nu veți putea comanda paginile pe care ar trebui să le acceseze cu crawlere.

Pentru site-urile web WP proaspete, acest lucru s-ar putea să nu prezinte prea mare sau o problemă. Cu toate acestea, pentru acele site-uri cu conținut nesfârșit, veți dori să aveți un control mai bun asupra modului în care este accesat cu crawlere și indexat . Un fișier robots.txt oferă o modalitate adecvată de a vă menține site-ul WordPress și modul în care îl văd roboții motoarelor de căutare.

De ce este asta atât de important, pentru început?

Fiecare site web are o cotă de accesare cu crawlere - așa funcționează roboții motoarelor de căutare. Aceasta înseamnă că roboții vor accesa cu crawlere site-ul dvs. o pagină la un moment dat. Dacă nu reușesc să termine accesarea cu crawlere a tuturor paginilor dvs. în timpul unei sesiuni, va relua accesarea cu crawlere data viitoare. Și acesta este ceva care poate încetini semnificativ indexarea site - ului dvs. ( rata de indexare ) .

Cu toate acestea, atunci când editați un fișier robots.txt în WordPress pentru a interzice accesarea cu crawlere a anumitor pagini , vă salvați cota de accesare cu crawlere . Cele mai comune și inutile pagini pe care utilizatorii WP le interzic de obicei includ pagini de administrare WordPress, pluginuri și teme. Odată ce eliminați aceste pagini, le oferiți crawlerilor mai mult spațiu pentru a indexa alte pagini relevante de pe site-ul dvs.

Cum ar trebui să arate fișierul robots.txt perfect din WordPress?

Site-urile de blog populare optează pentru un exemplu simplist al fișierului robots.txt – un formular care variază în funcție de nevoile site-ului respectiv:

| 1 2 3 4 5 | Agent utilizator: * Nu permiteți: Harta site-ului: https://www.example.com/post-sitemap.xml Harta site-ului: https://www.example.com/page-sitemap.xml |

Acest exemplu arată cum să le permiteți roboților să indexeze tot conținutul, oferindu-i un link către harta site-ului XML în acest proces.

Cu toate acestea, acesta este formularul recomandat pentru utilizatorii site-ului WordPress cum să editeze un fișier robots.txt în WordPress :

| 1 2 3 4 5 6 7 8 9 | Agent utilizator: * Permite: /wp-content/uploads/ Nu permiteți: /wp-content/plugins/ Nu permiteți: /wp-admin/ Nu permiteți: /readme.html Nu permiteți: /refer/ Harta site-ului: https://www.example.com/post-sitemap.xml Harta site-ului: https://www.example.com/page-sitemap.xml |

Aici, puteți vedea clar că roboții sunt instruiți să indexeze toate imaginile și fișierele WP . Cu toate acestea, de asemenea, nu permite roboților motoarelor de căutare să indexeze următoarele:

- Fișierele plugin WP

- Zona de administrare WP

- Fișierul readme WP

- Link-uri afiliate

Motivele pentru care ar trebui să adăugați un link la harta site-ului dvs. XML este acela de a face mai ușor pentru roboți să găsească toate paginile de pe site-ul dvs.

Cum să creați și să editați un fișier robots.txt în WordPress

La fel ca toate WordPress, există soluții versatile pentru fiecare sarcină. Deci, există de fapt două moduri de a crea un robots.txt în WordPress:

Soluția #1: Utilizarea Yoast SEO pentru a edita un fișier robots.txt în WordPress

Dacă utilizați pluginul Yoast SEO, aveți noroc! Pluginul vine cu un generator de fișiere robots.txt . Și puteți folosi acest generator pentru a crea și edita fișierul robots.txt direct din tabloul de bord al rolului de administrator.

Tot ce trebuie să faceți este să accesați pagina SEO >> Tools ca administrator . Odată ajuns acolo, faceți clic pe linkul Editor de fișiere. Pagina către care vă duce ar trebui să conțină fișierul robots.txt existent. Și în caz că nu, Yoast SEO va genera un fișier pentru tine. Unele versiuni ale Yoast SEO vor genera un fișier implicit în următoarea formă:

| 1 2 | Agent utilizator: * Nu permite: / |

Odată ce se întâmplă acest lucru, ar trebui să vă asigurați că ștergeți acest text , deoarece altfel va bloca toți roboții să acceseze cu crawlere site-ul dvs. După ce eliminați textul implicit, asigurați-vă că ați introdus propria versiune a scriptului robots.txt. Puteți folosi șablonul pe care l-am distribuit mai devreme.

După ce ați finalizat editarea fișierului, trebuie pur și simplu să faceți clic pe „ Salvați fișierul robots.txt ” și să stocați modificările.

Soluția #2: Utilizarea FTP pentru a edita manual un fișier robots.txt în WordPress

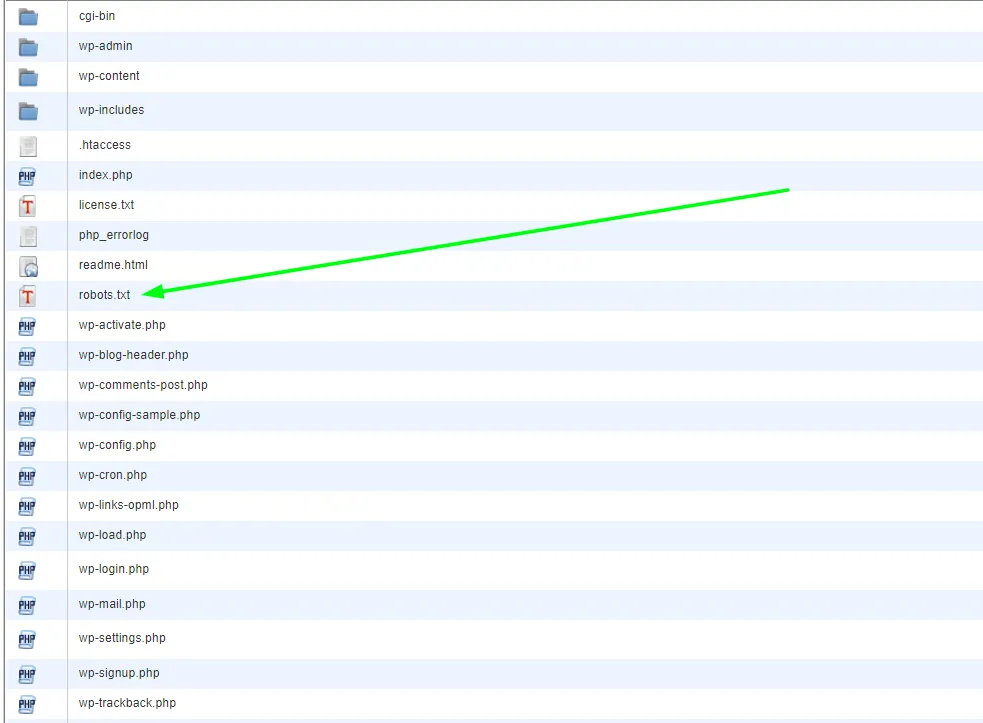

Această abordare particulară necesită utilizarea unui client FTP pentru a edita fișierul. Deci, primul lucru pe care doriți să-l faceți este să utilizați un client FTP pentru a vă conecta la contul dvs. de găzduire WordPress . Odată ajuns acolo, veți găsi fișierul robots.txt în folderul rădăcină al site-ului dvs. web.

Dacă nu puteți găsi un fișier robots.txt, atunci site-ul dvs. WP cel mai probabil nu are unul. Dacă acesta este cazul, puteți continua și crea unul. Având în vedere faptul că fișierul robots.txt este un fișier text simplu , puteți pur și simplu să îl descărcați și apoi să îl editați în orice editor simplu, cum ar fi Notepad sau TextEdit . Odată ce editați fișierul, puteți pur și simplu să-l încărcați înapoi în folderul rădăcină al site-ului dvs. web.

După ce editați un fișier robots.txt în WordPress, asigurați-vă că îl testați

Testarea este întotdeauna următorul pas logic după editare. Și acest lucru este deosebit de important în cazurile care implică robots.txt, din motivele pe care le-am menționat anterior. Nu vă faceți griji - există instrumente pe care le puteți utiliza pentru a testa acest lucru. Cel mai recomandat este Google Search Console .

Creați un cont dacă nu aveți unul și, odată conectat, treceți la vechiul site web al consolei de căutare Google . Odată ce aveți interfața veche în fața dvs., va trebui să lansați testerul robots.txt . Instrumentul se află sub meniul „ Crawl ”. Acest instrument va extrage automat fișierul robots.txt al site-ului dvs. și va evidenția orice erori pe care le găsește.

Gânduri finale

În concluzie, a avea un fișier robots.txt este un instrument foarte important în promovarea cauzei strategiilor tale SEO. Prin urmare, a învăța cum să creați și să editați un fișier robots.txt în WordPress este cu siguranță un pas înainte . Pentru orice întrebări sau tutoriale suplimentare când vine vorba despre WordPress, vizitați blogul nostru sau contactați-ne direct.