Как редактировать файл Robots.txt в WordPress

Опубликовано: 2019-09-09На этой неделе мы рассмотрим еще один вопрос, который возникает у начинающих пользователей WP — как отредактировать файл robots.txt в WordPress. Причина этого достаточно проста — это приносит пользу вашим усилиям по SEO . Файл robots.txt — невероятно мощный инструмент в SEO, потому что он работает как руководство по веб-сайту для поисковых роботов . Вот почему эксперты WordPress признают его важность и то, как лучше всего внедрить его в оптимизацию своего сайта. Здесь мы пошагово рассмотрим всю тему .

Начнем с более подробного определения файла robots.txt.

Боты поисковых систем нуждаются в инструкциях о том, как сканировать и индексировать внутренние страницы вашего сайта . Именно здесь в игру вступают файлы robots.txt. В этом файле представлена структура ваших страниц, что упрощает их чтение и оценку ботами поисковых систем.

Обычно файл robots.txt можно найти в корневом каталоге. Этот каталог также известен как основная папка всего вашего веб-сайта . Прежде чем мы перейдем к редактированию файла robots.txt в WordPress, нам сначала нужно научиться его распознавать. Итак, вот пример того, как выглядит типичный файл robots.txt:

| 1 2 3 4 5 6 7 8 | Агент пользователя: [имя агента пользователя] Запретить: [строка URL не должна сканироваться] Агент пользователя: [имя агента пользователя] Разрешить: [строка URL для сканирования] Карта сайта: [URL вашего файла Sitemap в формате XML] |

В самом файле достаточно места для настройки, например разрешения/запрета определенных URL-адресов или добавления нескольких файлов карты сайта . Итак, если у вас есть URL-адрес, который вы не хотите, чтобы поисковые роботы сканировали и ранжировали, вам нужно запретить его через robots.txt. Вот пример разрешения/запрета роботам поисковых систем сканировать определенные URL-адреса:

| 1 2 3 4 5 6 | Пользовательский агент: * Разрешить: /wp-content/uploads/ Запретить: /wp-content/plugins/ Запретить: /wp-admin/ Карта сайта: https://example.com/sitemap_index.xml |

Наконец, мы добавляем нашу карту сайта в смесь, делая URL-адрес видимым для роботов поисковых систем.

Важность наличия файла robots.txt в WordPress

Важно понимать, что даже если у вас нет файла robots.txt, роботы поисковых систем все равно будут сканировать ваши страницы . Тем не менее, они будут ползать по ним всем. Вы не сможете указать, какие страницы они должны и не должны сканировать.

Для свежих веб-сайтов WP это может быть не слишком большой проблемой. Однако для сайтов с бесконечным содержанием вам потребуется лучше контролировать его сканирование и индексацию . Файл robots.txt обеспечивает правильный способ обслуживания вашего веб-сайта WordPress и то, как его видят боты поисковых систем.

Почему это так важно для начала?

У каждого веб-сайта есть квота сканирования — так работают боты поисковых систем. Это означает, что боты будут сканировать ваш сайт по одной странице за раз. Если им не удастся завершить сканирование всех ваших страниц за один сеанс, они возобновят сканирование в следующий раз. А это то, что может значительно замедлить индексацию вашего сайта ( скорость индексации ) .

Однако, когда вы редактируете файл robots.txt в WordPress, чтобы запретить сканирование определенных страниц , вы сохраняете свою квоту сканирования . Наиболее распространенные и ненужные страницы, которые пользователи WP обычно запрещают, включают страницы администрирования WordPress, плагины и темы. Как только вы удалите эти страницы, вы предоставите поисковым роботам больше места для индексации других релевантных страниц вашего сайта.

Как должен выглядеть идеальный файл robots.txt в WordPress?

Популярные сайты блогов выбирают упрощенный пример файла robots.txt — форма, которая варьируется в зависимости от потребностей этого сайта:

| 1 2 3 4 5 | Пользовательский агент: * Запретить: Карта сайта: https://www.example.com/post-sitemap.xml Карта сайта: https://www.example.com/page-sitemap.xml |

В этом примере показано, как разрешить ботам индексировать весь контент, предоставляя ему ссылку на XML-карту сайта веб-сайта в процессе.

Тем не менее, это рекомендуемая форма для пользователей веб-сайта WordPress, как редактировать файл robots.txt в WordPress :

| 1 2 3 4 5 6 7 8 9 | Пользовательский агент: * Разрешить: /wp-content/uploads/ Запретить: /wp-content/plugins/ Запретить: /wp-admin/ Запретить: /readme.html Запретить: /см./ Карта сайта: https://www.example.com/post-sitemap.xml Карта сайта: https://www.example.com/page-sitemap.xml |

Здесь вы можете ясно видеть, что ботам приказано индексировать все изображения и файлы WP . Однако он также запрещает роботам поисковых систем индексировать следующее:

- Файлы плагинов WP

- админка WP

- Файл readme для WP

- Партнерские ссылки

Причина, по которой вам следует добавить ссылку на XML-карту сайта, заключается в том, чтобы упростить роботам поиск всех страниц на вашем сайте.

Как создать и отредактировать файл robots.txt в WordPress

Как и во всем WordPress, для каждой задачи есть универсальные решения. Итак, на самом деле есть два способа создать robots.txt в WordPress:

Решение № 1. Использование Yoast SEO для редактирования файла robots.txt в WordPress

Если вы используете плагин Yoast SEO, вам повезло! Плагин поставляется с генератором файлов robots.txt . И вы можете использовать этот генератор для создания и редактирования файла robots.txt непосредственно из вашей панели администратора.

Все, что вам нужно сделать, это перейти на страницу SEO >> Tools в качестве администратора . Оказавшись там, нажмите на ссылку «Редактор файлов». Страница, на которую он ведет, должна содержать существующий файл robots.txt. А если это не так, Yoast SEO сгенерирует для вас файл. Некоторые версии Yoast SEO будут генерировать файл по умолчанию в следующем виде:

| 1 2 | Пользовательский агент: * Запретить: / |

Как только это произойдет, вы должны обязательно удалить этот текст , потому что в противном случае он заблокирует сканирование вашего сайта всеми ботами. Удалив текст по умолчанию, не забудьте ввести собственную версию скрипта robots.txt. Вы можете использовать шаблон, которым мы поделились ранее.

После завершения редактирования файла вам просто нужно нажать « Сохранить файл robots.txt » и сохранить изменения.

Решение № 2. Использование FTP для ручного редактирования файла robots.txt в WordPress

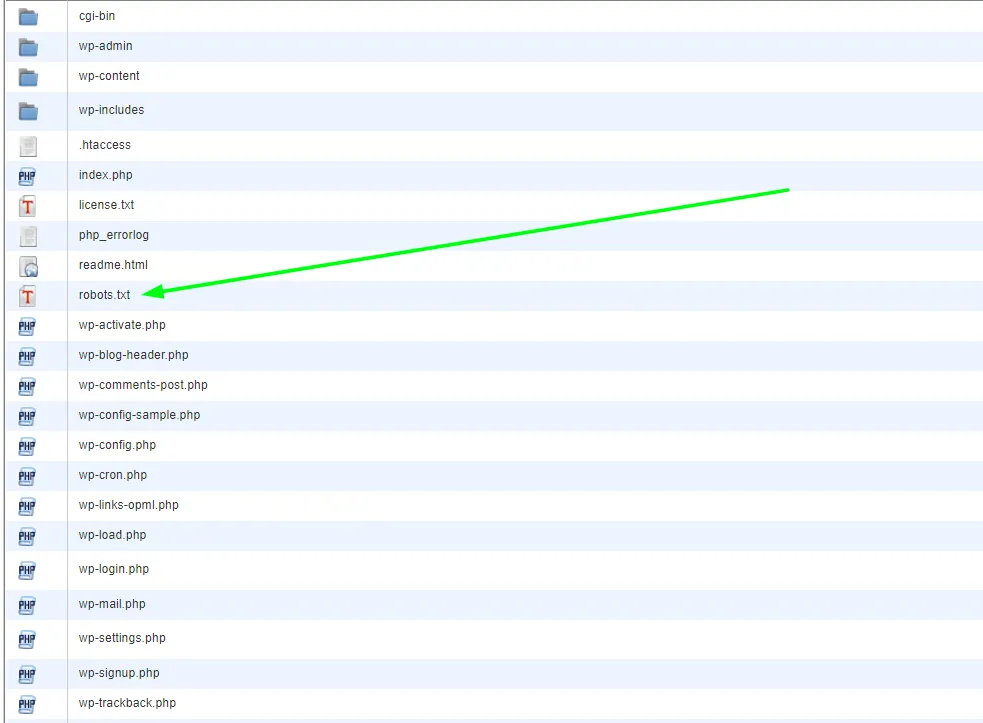

Этот конкретный подход требует использования FTP-клиента для редактирования файла. Итак, первое, что вы хотите сделать, это использовать FTP-клиент для подключения к вашей учетной записи хостинга WordPress . Оказавшись там, вы найдете файл robots.txt в корневой папке вашего сайта.

Если вы не можете найти файл robots.txt, скорее всего, на вашем сайте WP его нет. Если это так, вы можете пойти дальше и создать его. Учитывая тот факт, что файл robots.txt представляет собой простой текстовый файл , вы можете просто загрузить его, а затем отредактировать в любом обычном редакторе, таком как Блокнот или TextEdit . Отредактировав файл, вы можете просто загрузить его обратно в корневую папку вашего веб-сайта.

Как только вы отредактируете файл robots.txt в WordPress, обязательно протестируйте его.

Тестирование всегда является следующим логическим шагом после редактирования. И это особенно важно в случаях, связанных с robots.txt, по причинам, которые мы упоминали ранее. Не беспокойтесь — есть инструменты, которые вы можете использовать, чтобы проверить это. Больше всего мы рекомендуем Google Search Console .

Создайте учетную запись, если у вас ее нет, и после входа перейдите на старый веб-сайт консоли поиска Google . Как только перед вами окажется старый интерфейс, вам нужно будет запустить тестер robots.txt . Инструмент находится в меню « Сканирование ». Этот инструмент автоматически извлечет файл robots.txt вашего веб-сайта и выделит все найденные ошибки.

Последние мысли

В заключение, наличие файла robots.txt — очень важный инструмент для продвижения ваших стратегий SEO. Следовательно, научиться создавать и редактировать файл robots.txt в WordPress — это, безусловно, шаг вперед . Если у вас есть дополнительные вопросы или руководства по WordPress, посетите наш блог или свяжитесь с нами напрямую.