So bearbeiten Sie eine Robots.txt-Datei in WordPress

Veröffentlicht: 2019-09-09Diese Woche beschäftigen wir uns mit einer weiteren Frage, die Anfänger von WP haben – wie man eine robots.txt-Datei in WordPress bearbeitet. Der Grund dafür ist einfach genug – es kommt Ihren SEO-Bemühungen zugute . Eine robots.txt-Datei ist ein unglaublich leistungsfähiges SEO-Tool, da sie als Website-Leitfaden für Suchmaschinen-Crawler-Bots fungiert . Aus diesem Grund erkennen WordPress-Experten seine Bedeutung und wissen, wie sie es am besten in die Optimierung ihrer Website integrieren können. Hier ist unsere Schritt-für-Schritt-Anleitung zum gesamten Thema .

Wir beginnen mit einer genaueren Definition der robots.txt-Datei

Suchmaschinen-Bots benötigen Anweisungen zum Crawlen und Indizieren der inneren Seiten Ihrer Website . Hier kommen robots.txt-Dateien ins Spiel. Diese Datei legt die Struktur Ihrer Seiten fest, sodass sie von Suchmaschinen-Bots leicht gelesen und bewertet werden können.

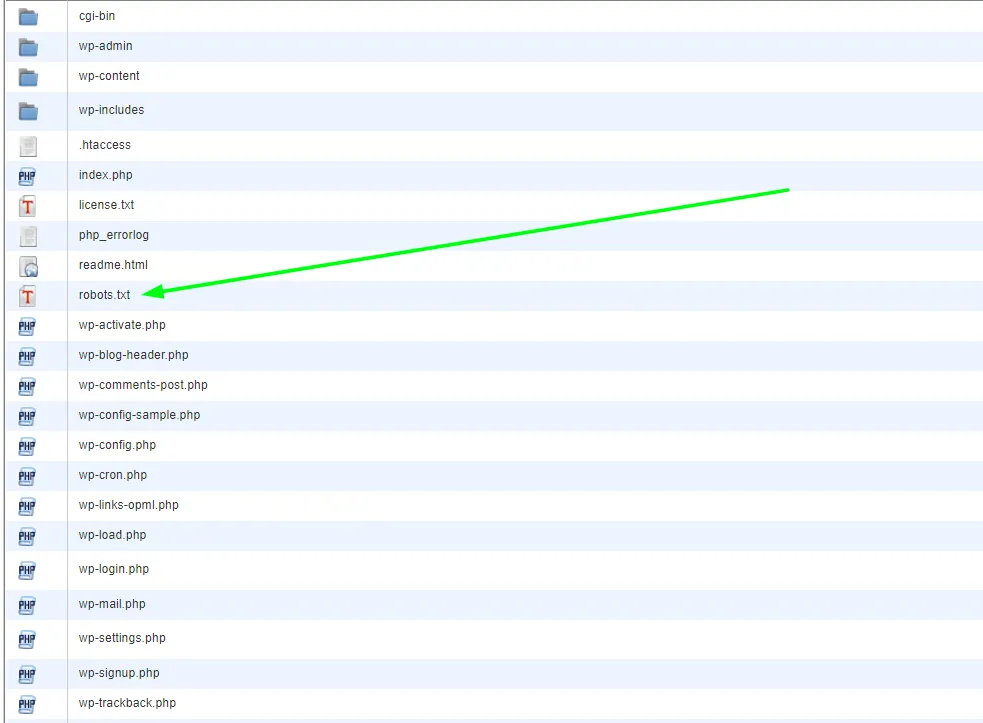

Sie finden die robots.txt-Datei normalerweise im Stammverzeichnis gespeichert. Dieses Verzeichnis ist auch als Hauptordner Ihrer gesamten Website bekannt . Bevor wir uns damit befassen, wie man eine robots.txt-Datei in WordPress bearbeitet, müssen wir zuerst lernen, wie man sie erkennt. Hier ist also ein Beispiel dafür, wie eine typische robots.txt-Datei aussieht:

| 1 2 3 4 5 6 7 8 | Benutzeragent: [Name des Benutzeragenten] Disallow: [URL-String soll nicht gecrawlt werden] Benutzeragent: [Name des Benutzeragenten] Zulassen: [zu crawlende URL-Zeichenfolge] Sitemap: [URL Ihrer XML-Sitemap] |

Die Datei selbst bietet viel Platz für Anpassungen, z. B. das Zulassen/Verbieten bestimmter URLs oder das Hinzufügen mehrerer Sitemap-Dateien . Wenn Sie also eine URL haben, die von Suchmaschinen-Bots nicht gecrawlt und gerankt werden soll, müssen Sie sie über robots.txt verbieten. Hier ist ein Beispiel dafür, wie Suchmaschinen-Bots das Crawlen bestimmter URLs erlauben/verbieten:

| 1 2 3 4 5 6 | User-Agent: * Zulassen: /wp-content/uploads/ Nicht zulassen: /wp-content/plugins/ Nicht zulassen: /wp-admin/ Sitemap: https://example.com/sitemap_index.xml |

Zuletzt fügen wir dem Mix unsere Sitemap hinzu, wodurch die URL für Suchmaschinen-Bots sichtbar wird.

Die Wichtigkeit einer robots.txt-Datei in WordPress

Es ist wichtig zu verstehen, dass selbst wenn Sie keine robots.txt-Datei haben, Suchmaschinen-Bots trotzdem Ihre Seiten crawlen . Sie werden jedoch alle kriechen. Sie können nicht anordnen, welche Seiten gecrawlt werden sollen und welche nicht.

Für frische WP-Websites stellt dies möglicherweise kein allzu großes Problem dar. Bei Websites mit endlosen Inhalten möchten Sie jedoch besser kontrollieren können, wie sie gecrawlt und indexiert werden . Eine robots.txt-Datei bietet eine angemessene Möglichkeit, Ihre WordPress-Website zu pflegen und wie Suchmaschinen-Bots sie sehen.

Warum ist das so wichtig, um damit anzufangen?

Jede Website hat eine Crawling-Quote – so funktionieren Suchmaschinen-Bots. Das bedeutet, dass Bots Ihre Website Seite für Seite durchsuchen. Wenn sie das Crawlen aller Ihrer Seiten während einer Sitzung nicht abschließen, setzen sie das Crawlen beim nächsten Mal fort. Und das ist etwas, das die Indizierung Ihrer Website erheblich verlangsamen kann ( Indexierungsrate ) .

Wenn Sie jedoch eine robots.txt-Datei in WordPress bearbeiten, um bestimmte Seiten vom Crawling auszuschließen , sparen Sie Ihr Crawling-Kontingent . Die häufigsten und unnötigsten Seiten, die WP-Benutzer normalerweise nicht zulassen, sind WordPress-Admin-Seiten, Plugins und Themes. Sobald Sie diese Seiten eliminieren, geben Sie Crawlern mehr Platz, um andere relevante Seiten auf Ihrer Website zu indizieren.

Wie sollte die perfekte robots.txt-Datei in WordPress aussehen?

Beliebte Blog-Sites entscheiden sich für ein vereinfachtes Beispiel der robots.txt-Datei – ein Format, das je nach den Anforderungen dieser Site variiert:

| 1 2 3 4 5 | User-Agent: * Nicht zulassen: Sitemap: https://www.example.com/post-sitemap.xml Sitemap: https://www.example.com/page-sitemap.xml |

Dieses Beispiel zeigt, wie man es Bots erlaubt, alle Inhalte zu indizieren und ihm dabei einen Link zur XML-Sitemap der Website zu geben.

Dies ist jedoch die empfohlene Form für Benutzer von WordPress-Websites zum Bearbeiten einer robots.txt-Datei in WordPress :

| 1 2 3 4 5 6 7 8 9 | User-Agent: * Zulassen: /wp-content/uploads/ Nicht zulassen: /wp-content/plugins/ Nicht zulassen: /wp-admin/ Nicht zulassen: /readme.html Nicht zulassen: /referieren/ Sitemap: https://www.example.com/post-sitemap.xml Sitemap: https://www.example.com/page-sitemap.xml |

Hier können Sie deutlich sehen, dass Bots angewiesen werden, alle WP-Bilder und -Dateien zu indizieren . Es verbietet jedoch auch Suchmaschinen-Bots, Folgendes zu indizieren:

- WP-Plugin-Dateien

- WP-Adminbereich

- WP-Readme-Datei

- Affiliate-Links

Der Grund, warum Sie Ihrer XML-Sitemap einen Link hinzufügen sollten, besteht darin, Bots das Auffinden aller Seiten auf Ihrer Website zu erleichtern.

So erstellen und bearbeiten Sie eine robots.txt-Datei in WordPress

Wie bei WordPress gibt es vielseitige Lösungen für jede Aufgabe. Es gibt also tatsächlich zwei Möglichkeiten, eine robots.txt in WordPress zu erstellen:

Lösung Nr. 1: Mit Yoast SEO eine robots.txt-Datei in WordPress bearbeiten

Wenn Sie das Yoast SEO-Plugin verwenden, haben Sie Glück! Das Plugin wird mit einem robots.txt-Dateigenerator geliefert . Und Sie können diesen Generator verwenden, um die robots.txt-Datei direkt von Ihrem Admin-Rollen-Dashboard aus zu erstellen und zu bearbeiten.

Alles, was Sie tun müssen, ist, als Administrator auf die Seite SEO >> Tools zu gehen . Klicken Sie dort auf den Link Datei-Editor. Die Seite, zu der es Sie führt, sollte die vorhandene robots.txt-Datei enthalten. Und falls dies nicht der Fall ist, generiert Yoast SEO eine Datei für Sie. Einige Versionen von Yoast SEO generieren eine Standarddatei in der folgenden Form:

| 1 2 | User-Agent: * Nicht zulassen: / |

Sobald dies passiert, sollten Sie diesen Text unbedingt löschen, da er sonst alle Bots daran hindert, Ihre Website zu crawlen. Stellen Sie nach dem Entfernen des Standardtexts sicher, dass Sie Ihre eigene Version des robots.txt-Skripts eingeben. Sie können die zuvor freigegebene Vorlage verwenden.

Sobald Sie die Bearbeitung der Datei abgeschlossen haben, müssen Sie nur noch auf „ robots.txt-Datei speichern“ klicken und Ihre Änderungen speichern.

Lösung Nr. 2: Verwenden von FTP zum manuellen Bearbeiten einer robots.txt-Datei in WordPress

Dieser spezielle Ansatz erfordert die Verwendung eines FTP-Clients zum Bearbeiten der Datei. Das erste, was Sie tun möchten, ist , einen FTP-Client zu verwenden, um eine Verbindung zu Ihrem WordPress-Hosting-Konto herzustellen . Dort finden Sie die robots.txt-Datei im Stammordner Ihrer Website.

Wenn Sie keine robots.txt-Datei finden können, dann hat Ihre WP-Site höchstwahrscheinlich keine. Wenn dies der Fall ist, können Sie fortfahren und eine erstellen. Da es sich bei der robots.txt-Datei um eine einfache Textdatei handelt, können Sie sie einfach herunterladen und dann in einem einfachen Editor wie Notepad oder TextEdit bearbeiten. Nachdem Sie die Datei bearbeitet haben, können Sie sie einfach wieder in den Stammordner Ihrer Website hochladen.

Nachdem Sie eine robots.txt-Datei in WordPress bearbeitet haben, stellen Sie sicher, dass Sie sie testen

Das Testen ist immer der nächste logische Schritt nach der Bearbeitung. Und dies ist aus den zuvor erwähnten Gründen besonders wichtig in Fällen, in denen die robots.txt-Datei involviert ist. Keine Sorge – es gibt Tools, mit denen Sie dies testen können. Am meisten empfehlen wir die Google Search Console .

Erstellen Sie ein Konto, falls Sie noch keines haben, und wechseln Sie nach der Anmeldung zur alten Website der Google-Suchkonsole . Sobald Sie die alte Benutzeroberfläche vor sich haben, müssen Sie den robots.txt-Tester starten . Das Tool befindet sich im Menü „ Crawl “. Dieses Tool ruft automatisch die robots.txt-Datei Ihrer Website auf und hebt alle gefundenen Fehler hervor.

Abschließende Gedanken

Zusammenfassend lässt sich sagen, dass eine robots.txt-Datei ein sehr wichtiges Werkzeug ist, um die Sache Ihrer SEO-Strategien voranzutreiben. Daher ist es definitiv ein Schritt nach vorne, zu lernen, wie man eine robots.txt-Datei in WordPress erstellt und bearbeitet . Für weitere Fragen oder Tutorials zu WordPress besuchen Sie unseren Blog oder kontaktieren Sie uns direkt.