Wie KI-Audio zu MIDI die moderne Musikproduktion neu verkabelt

Veröffentlicht: 2026-02-10Warum KI-Audio zu MIDI jetzt wichtig ist

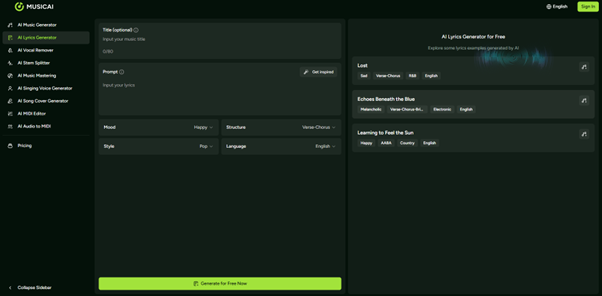

KI und Musikproduktion kollidieren auf ganz praktische Weise: Die Umwandlung von chaotischem Audio in sauberes MIDI ist endlich für alltägliche Produzenten nutzbar. Anstatt Melodien oder Akkorde manuell zu transkribieren, können Sie mit einem KI-Audio-zu-MIDI-Konverter summen, ein Riff aufnehmen oder einen Loop einfügen und erhalten im Gegenzug bearbeitbare MIDI-Noten. Plattformen wie MusicAI treiben dies noch weiter voran, indem sie Audio in MIDI in eine umfassendere KI-Musikerstellungssuite einbinden, sodass Ideenerfassung und Arrangement live an einem Ort stattfinden.

In einer Zeit, in der Musiker zwischen DAWs, Kurzvideos und Spielen wechseln, ist das wichtig. MIDI ist immer noch die flexibelste „Sprache“ von Musiksoftware, und AI-Audio zu MIDI wird zur Brücke zwischen spontanen Aufnahmen und strukturierten digitalen Arrangements. Für Entwickler, die Geschwindigkeit wollen, ohne auf Kontrolle zu verzichten, ist diese Brücke der Ort, an dem die meisten Innovationen stattfinden.

Was Audio zu MIDI tatsächlich bewirkt

Im Kern übersetzt die Audio-zu-MIDI-Konvertierung kontinuierliche Klänge – Gesang, Gitarren, Synthesizer-Linien – in diskrete Notendaten, die virtuelle Instrumente verstehen. Anstatt Wellenformen zu speichern, speichert eine MIDI-Datei Tonhöhe, Timing, Geschwindigkeit und manchmal auch Akkordinformationen, die Sie später frei bearbeiten können. Das bedeutet, dass eine gesungene Zeile zu einem Streicherabschnitt oder ein Gitarrenriff zu einem Synthesizer-Bass werden kann, ohne dass es wiederholt werden muss.

Moderne KI-gesteuerte Konverter, einschließlich der Audio-zu-MIDI-Funktion in MusicAI, analysieren Tonhöhe, Rhythmus und sogar Akkorde, um eine saubere MIDI-Darstellung der Quelle zu erzeugen. Branchenführer weisen darauf hin, dass auf maschinellem Lernen basierende Tools im Vergleich zu frühen, rein algorithmischen Konvertern eine deutlich höhere Genauigkeit aufweisen, insbesondere bei monophonem Material. Während für dichte Mischungen kein Werkzeug perfekt ist, wird die Lücke zwischen Idee und bearbeitbarem MIDI von Jahr zu Jahr kleiner.

Wo traditionelle Arbeitsabläufe zu kurz kommen

Vor AI Audio to MIDI hatten Produzenten drei Möglichkeiten: manuelle Transkription, langsame „Slice to MIDI“-Workflows oder einfach aufgeben und neu aufnehmen. Das manuelle Klicken von Noten in eine Pianorolle ist präzise, aber äußerst zeitaufwändig, insbesondere bei schnellen Improvisationen oder komplexen Rhythmen. Die „Slice to new MIDI track“-Funktionen in DAWs sind leistungsstark, funktionieren aber am besten für Drums, nicht für Melodielinien oder Akkorde mit anhaltendem Ausdruck.

Berichte über Arbeitsabläufe in der Musikproduktion zeigen, dass Produzenten immer noch unverhältnismäßig viel Zeit mit sich wiederholender Bearbeitung statt mit Sounddesign oder Arrangement verbringen. Das ist genau der Zeitaufwand, den AI Audio to MIDI reduzieren soll. Auch Community-Diskussionen spiegeln dies wider: Benutzer erwähnen immer wieder, dass ein gutes Audio-zu-MIDI-Tool „Stunden an Transkription spart“ und das Neukomponieren aus Samples weitaus praktischer macht.

In der Audio-zu-MIDI-Engine von MusicAI

Das spezielle Audio-zu-MIDI-Tool von MusicAI konzentriert sich auf drei Säulen: umfassende Unterstützung von Audioformaten, detaillierte Musikanalyse und sauberer Export. Sie können gängige Formate wie WAV, MP3, FLAC oder OGG hochladen, sodass es sowohl für Studioaufnahmen als auch für schnelle Telefonaufnahmen geeignet ist. Nach dem Hochladen analysiert die KI des Systems Tonhöhe, Rhythmus und Akkordstrukturen und generiert dann eine bearbeitbare MIDI-Datei, die den Kerninhalt der Musik erfasst.

Laut der eigenen Dokumentation von MusicAI ist die Engine auf melodische Genauigkeit und Akkorderkennung abgestimmt und nicht nur auf grobe Noten-Ein/Aus-Ereignisse. Dadurch eignet es sich zum Transkribieren von Melodien, zum Reharmonisieren von Ideen oder zum Extrahieren von Mustern aus Ihren eigenen Aufnahmen, ohne sich in der Bereinigung zu verlieren. Während sehr verrauschte oder dichte Mischungen weiterhin eine Herausforderung darstellen, gilt das Tool als eine der zuverlässigeren webbasierten Audio-zu-MIDI-Optionen für Entwickler, die sowohl Geschwindigkeit als auch nutzbare Musikdaten wünschen.

Praktischer Test: Verwendung von MusicAI für Audio zu MIDI

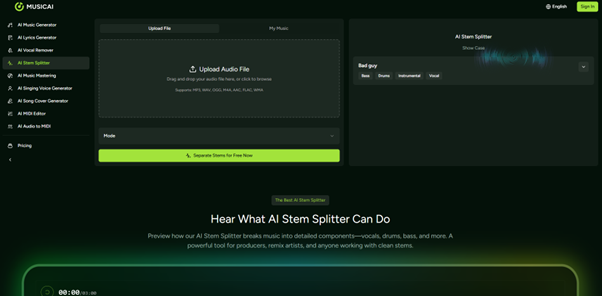

Um zu sehen, wie dies in einen realen Arbeitsablauf passt, wurde eine kurze Testsitzung mit der Audio-zu-MIDI-Funktion von MusicAI an drei Arten von Quellmaterial durchgeführt: einer gesummten Melodie, einem einfachen Klavierloop und einer geschäftigeren Gitarrenprogression. Der Vorgang war unkompliziert: Ziehen Sie die Audiodatei per Drag-and-Drop, warten Sie, bis die KI-Analyse abgeschlossen ist, und laden Sie dann das resultierende MIDI zur Verwendung in einer DAW herunter.

Bei einer einzeiligen, gesummten Melodie war die Transkriptionsgenauigkeit hoch: Die Tonhöhenerkennung war größtenteils korrekt, es waren nur wenige Timing-Anpassungen in der DAW-Pianorolle erforderlich. Für einen sauberen Piano-Loop erfasste das Tool sowohl den Rhythmus als auch die Grundakkorde gut genug, um den Teil mit verschiedenen virtuellen Instrumenten neu zu orchestrieren. Der komplexe Gitarrenverlauf war der schwierigste Fall; Während der Hauptharmoniksatz verwendbar war, wurden einige innere Noten vereinfacht oder falsch erkannt, was die bekannte Einschränkung widerspiegelt, dass dichtes polyphones Audio nach wie vor das schwierigste Szenario für jeden Konverter ist.

Schritt für Schritt: Konvertieren von Audio in MIDI mit MusicAI

Die Verwendung des Audio-zu-MIDI-Workflows von MusicAI ähnelt eher einer einfachen Web-App als der Konfiguration eines Plugins oder DAW-Makros. Der typische Ablauf sieht so aus:

- Öffnen Sie die spezielle Audio To MIDI-Seite in Ihrem Browser und melden Sie sich an.

- Ziehen Sie eine WAV-, MP3-, FLAC- oder OGG-Datei in den Upload-Bereich.

- Lassen Sie die KI-Engine Tonhöhe, Rhythmus und harmonische Inhalte analysieren.

- Laden Sie die resultierende MIDI-Datei herunter und importieren Sie sie zur Bearbeitung und Klangauswahl in Ihre DAW.

Dieser dreistufige Ablauf – Hochladen, Analysieren, Herunterladen – gleicht Mustern ab, die bei modernen KI-Audiotools zu beobachten sind. Die Stärke von MusicAI liegt jedoch darin, dass Audio zu MIDI zusammen mit Text-zu-Musik, Text-zu-Lied und anderen Erstellungsfunktionen in einem Arbeitsbereich untergebracht ist. Dadurch ist es einfacher, von einer konvertierten MIDI-Skizze zu einem vollständigen Arrangement überzugehen oder es mit KI-generierten Backing-Tracks zu kombinieren, ohne mit mehreren Diensten jonglieren zu müssen.

Wo MusicAI Audio to MIDI glänzt (und wo nicht)

Aus Sicht der Stärken bietet die Audio-zu-MIDI-Funktion von MusicAI Geschwindigkeit, Zugänglichkeit und integrierten Kontext mit dem Rest der Plattform. Es ist browserbasiert, erfordert keine Installation und unterstützt mehrere Audioformate, was ideal für Entwickler ist, die zwischen mobilen Aufnahmen und Studiositzungen wechseln. Bei monophonen Linien und relativ sauberen Spuren ist das generierte MIDI genau genug, um hochwertige virtuelle Instrumente mit nur geringfügigen Bearbeitungen anzusteuern.

Auf der anderen Seite unterliegt MusicAI den gleichen Einschränkungen wie andere KI-Audio-zu-MIDI-Tools: Komplexe, verrauschte oder stark verarbeitete Audiodaten können immer noch Artefakte oder fehlende Noten erzeugen. Und obwohl KI die Transkriptionszeit drastisch verkürzt, ersetzt sie nicht das musikalische Urteilsvermögen – Sie müssen dennoch Timing, Stimmführung und Dynamik verfeinern, um sie an die Produktion anzupassen. Für Benutzer, die eine „perfekte Punktzahl mit einem Klick“ erwarten, wird jedes aktuelle Tool, nicht nur MusicAI, nicht ausreichen, ein Punkt, der von unabhängigen Leitfäden und Vergleichen von Konvertierungssoftware bestätigt wird.

Wer profitiert am meisten von AI Audio zu MIDI?

Audio zu MIDI ist besonders wertvoll für Produzenten und Songwriter, die Ideen außerhalb ihrer DAW starten – auf Telefonen, Klavieren oder Gitarren – und einen schnellen Weg in strukturierte Sessions suchen. Die Implementierung von MusicAI eignet sich für YouTuber, die KI bereits für die Text-zu-Musik- oder Textgenerierung nutzen und nun ihre eigenen Aufnahmen in dasselbe Ökosystem einbringen möchten. Es eignet sich auch gut für Pädagogen und Studenten: Die Konvertierung von Übungsaufnahmen in MIDI bietet eine klare Möglichkeit, Timing und Tonhöhengenauigkeit zu analysieren.

Marktanalysen von MIDI-Software deuten auf eine wachsende Nutzerbasis von Heimstudiomusikern und Hobbymusikern hin, wobei die weltweiten Einnahmen aus MIDI-Software auf Hunderte Millionen Dollar geschätzt werden und voraussichtlich mit der Verbreitung zugänglicher Tools wachsen werden. KI-gestützte Funktionen wie Audio zu MIDI sind ein natürlicher nächster Schritt in diesem Trend und machen professionelle Arbeitsabläufe für Entwickler zugänglich, die keinen traditionellen Theorie- oder Notationshintergrund haben.

Warum KI-Audio zu MIDI für die Branche wichtig ist

Auf einer breiteren Ebene liegt Audio zu MIDI an der Schnittstelle von KI, Skalierbarkeit von Inhalten und rechtesicherer Erstellung. Berichte über die Einführung von KI-Musik machen deutlich, dass Musikschaffende sich Tools wünschen, die die Ideenfindung beschleunigen, ohne sie an Black-Box-Ausgaben zu binden, die sie nicht bearbeiten können. MIDI ist von Natur aus bearbeitbar, daher entspricht die Verwendung von KI zur Erzeugung von MIDI statt nur fertiger Audiodaten diesem Wunsch nach Kontrolle und Transparenz.

Da immer mehr Plattformen im KI-Musikbereich konkurrieren, werden Funktionen wie die Audio-zu-MIDI-Funktion von MusicAI eher zu Unterscheidungsmerkmalen als zu Add-ons. Sie helfen Kreativen dabei, ihre eigenen Aufnahmen in neue Arrangements umzuwandeln, KI-generierte Inhalte anzupassen und projektübergreifend eine konsistente Klangidentität beizubehalten – und das alles auf einem Markt, von dem Analysten erwarten, dass er im nächsten Jahrzehnt stetig wächst. In diesem Zusammenhang ist KI-Audio zu MIDI weniger eine Neuheit als vielmehr eine grundlegende Fähigkeit für die nächste Generation hybrider Mensch-KI-Musikworkflows.