Kafka: Mikro Hizmetlerde Mesaj Aracıları İçin Harika Bir Seçim

Yayınlanan: 2022-11-19Kafka, dağıtılmış bir akış platformudur. Genellikle günlük toplama, gerçek zamanlı akış işleme ve olay kaynağı belirleme için kullanılır. Son zamanlarda Kafka, mikro hizmetler için bir mesaj aracısı olarak popülerlik kazanıyor. Kafka, ActiveMQ veya RabbitMQ gibi geleneksel bir mesaj kuyruğu değildir. Tüm mesajları saklayan merkezi bir sunucusu yoktur. Bunun yerine, bir yayınla-abone ol modeli kullanır. Mesajlar konularda saklanır ve her konunun birden fazla bölümü olabilir. Kafka yüksek düzeyde kullanılabilir ve ölçeklenebilirdir. Günde milyarlarca mesajı işleyebilir. Kafka da çok hızlıdır. Mesajları gerçek zamanlı olarak işleyebilir. Kafka, mikro hizmetler için bir mesaj aracısı oluşturmak için mükemmel bir seçimdir. Yüksek düzeyde kullanılabilir, ölçeklenebilir ve hızlıdır.

Gerçek zamanlı bir mesajlaşma sistemi olan Kafka bunu mümkün kılıyor. Veri akışları parazite karşı korunur ve dağıtılabilir veya hataya dayanıklı olabilir. Kafka Veri Entegrasyon Veriyolu , çok çeşitli üretici ve tüketicinin veri paylaşmasını sağlayan bir veri alışverişi protokolüdür. Kafka'nın yetenekleri, uygulamanızın sonunda veri arabelleği görevi gören MongoDB ve RDS'nin yeteneklerine benzer.

SQL tabanlı bir betik dili olan KSQL, Apache Kafka'da gerçek zamanlı akış verilerini analiz etmek ve işlemek için kullanılır. KSQL, veri toplama, filtreleme, birleştirme, oturum oluşturma, pencereleme vb. gibi Akış İşleme etkinliklerini gerçekleştirmenize izin vermesi amaçlanan Akış İşleme için bir Etkileşimli Çerçeve içerir.

Apache Kafka'nın gösterdiği gibi mükemmel bir mesaj aracısından daha fazlasıdır. Çerçeve uygulaması, onu bir veritabanında kullanıma uygun hale getiren bir dizi veritabanı benzeri özelliğe sahiptir. Sonuç olarak, artık ilişkisel veritabanlarına güvenmek yerine iş olayı kaydı olarak hizmet vermektedir.

Kafka uygulaması , verileri MongoDB'den basit ve verimli bir şekilde aktararak zamandan ve enerjiden tasarruf sağlar. Kuruluşların diğer abonelere büyük miktarda veri yayınlamasının yanı sıra birden çok veri akışını yönetmesi için MongoDB gereklidir. Kafka MongoDB Bağlantı hizmeti, geliştiricilerin popüler bir endüstri aracı olan MongoDB ile birden çok eşzamansız akış oluşturmasına olanak tanır.

Bir veritabanında, Apache Kafka bir model görevi görür. Yüzlerce şirket bunu ACID garantileri sağlamak ve görev açısından kritik görevleri gerçekleştirmek için kullanıyor. Ancak çoğu durumda Kafka, diğer veritabanları kadar rekabetçi değildir.

Kafka Ne Tür Veritabanıdır?

Kafka, mesajları depolamak ve almak için kullanılan bir veritabanı türüdür. Ölçeklenebilir ve hataya dayanıklı olacak şekilde tasarlanmış dağıtılmış bir sistemdir.

Apache Software Foundation'ın Kafka projesinin bir parçası olan Scala ve Java ile yazılmış açık kaynaklı bir akış işleme platformudur. Bilgisayar bilimindeki bir akış, zaman içinde kullanıma sunulan bir bilgi öğeleri koleksiyonudur. Akışlar, bir konveyör bandında birer birer işlenen öğeler olarak tanımlanabilir. Akışlar, en temel biçimleriyle, görünüşte alakasız olaylar dizisi olabilir. Olay kaynağı oluşturma kavramları, geliştiricilerin alışık olduğu veri ambarı oluşturma ve veri analizi kavramlarından farklıdır. Kafka'yı veritabanı olarak nasıl kullanırım? Blue, anlaşmaya evet diyen şirkettir.

Team Red'e göre, programcılar geleneksel veritabanlarından Kafka'ya geçtiklerinde büyük bir hata yapıyorlar. Martin Kleppmann'a göre, Team Red'in Kafka'nın herkes için olduğu mesajı patronluk taslıyor. Team Red'in Kafka ve akışlarla ilgili sorunu, geliştiricilerin RDMS'leri çöpe atmasıyla ilgili bir sorun yaşamalarıdır. Kalıcı bir olay günlüğü sunulduğunda, her zaman tarihsel bağlamına sahip olacak ve bu da denetlemeyi kolaylaştıracaktır. Veritabanı yönetiminin sayısız avantajı vardır, ancak aynı zamanda en zor yönlerinden biridir. Geleneksel veritabanı tamamen farklı iki şekilde çalışır: okuma ve yazma işlemlerini birleştirir. Programcılar için, çoğaltılan verileri birden çok tablo arasında korumak ve senkronize etmek çok önemlidir.

Ölçek siz ilerledikçe deseni değiştirir. Akışlar, okuyucuların ve yazarların endişeleri arasındaki net bir ayrımla ayırt edilir. Kafka'nın bir dosyaya ne kadar hızlı yazdığı ile Elastic Search'ün güncellemeleri dosyaya ne kadar hızlı gönderebildiği arasında bir ilişki yoktur. Sonuç olarak, Kafka kullanıcıları çeşitli gerçekleştirilmiş görünümler oluşturmak için günlükleri işler. Gerçekleştirilmiş görünümlerin uygun bir önbelleğe alma mekanizması olarak çalışmasını sağlamak, bazı ön maliyetleri gerektirir. Gerçekleştirilmiş görünümler, kendi verilerini depolamanın ve ölçeklemenin yanı sıra, altyapının önemli bileşenleridir. İşletmelerin %99'u için DBMS'ler en iyi temeldir.

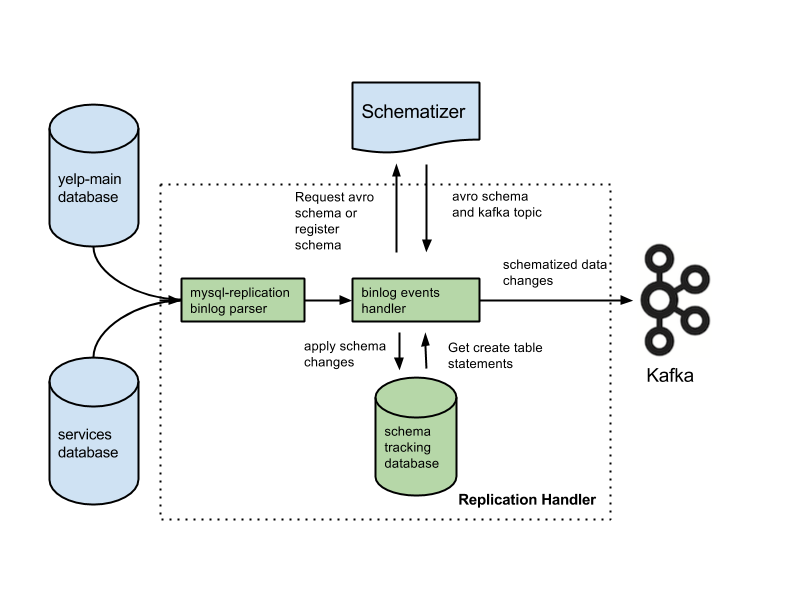

Başvurunuz bu kategoride olabilir ve geçmişinize göre yeni bir mimariye hak kazanabilirsiniz. Veritabanlarını günlüklerle değiştirirseniz, birçok kritik özellik kaybolacaktır. Özellikler, eşzamanlılık sorunlarına yardımcı olan yabancı anahtar kısıtlamaları, atomik (ya hep ya hiç) işlemleri ve prosedürel izolasyon tekniklerini içerir. Arjun, uygulamanızın bütünlüğünün her zaman korunduğunu varsayar. Çoğu kişinin doğal karşıladığı temel özellikler, siz akışlar üzerinde çalışırken ekstra sorumluluklar haline gelir. Amacı yazılı ifadeden ayırmak çok önemlidir. Yaygın bir yapılandırma, bir Change Data Capture sistemiyle birlikte Kafka'yı kullanmaktır.

Team Red'e göre, veritabanlarının veri bütünlüğü özellikleri, veri kontrolünü sağlamak için kritik öneme sahiptir. İşlemlerin dikkate alınabilmesi için geleneksel veritabanlarından izole edilmesi gerekir. Sonuç olarak, tek bir yazı maliyetli olabilir. Uygulamanız pahalı yazma işlemlerinin hacmiyle başa çıkmakta zorlanıyorsa, daha geleneksel bir veritabanına geçmek zorunda kalabilirsiniz. Team Red, Kafka'nın önünde bir veritabanı kullanmanın en iyi özelliklerini azalttığından bahsetmiyor.

Bu tasarımın avantajları, geleneksel mesajlaşma sistemlerine göre önemlidir. Kafka'nın ilk avantajı, çok sayıda isteği işleyebilmesidir. Ayrıca, veriler yalnızca ihtiyaç duyulduğunda diske yazıldığı için, Kafka çok büyük miktarda veriyi işleyebilir.

SQL Server, araçlar kategorisine giren bir Veritabanı aracıdır. Bu el tipi cihaz çok yönlü ve güvenilirdir, ancak bazen kullanımı zor olabilir. Kafka ve Azure son derece yetenekli platformlardır, ancak Azure küçültülürken Kafka büyütülür.

SQL Server, büyük miktarda veri depolamaya ihtiyaç duyan işletmeler için mükemmel bir araçtır, ancak hızlı ölçeklendirmeye veya yüksek veri hacmine ihtiyaç duyanlar için en iyi seçenek olmayabilir. Performanstan ödün vermeden büyük miktarda veriyi işlemesi gereken işletmeler için Kafka, SQL Server'dan daha iyi bir seçimdir.

Kafka: Zaman Serisi Telemetrisi İçin Dağıtılmış Bir Depolama Sistemi

Konu tabanlı bir model kullanan Kafka Dağıtılmış Depolama Sistemi, verileri depolar. Veriler, ilişkisel bir veritabanı yerine Konu tabanlı bir Kafka veritabanı modelinde saklanabilir. Bir kuyruğun yaptığı gibi olmasa da, bir Kafka Konusundaki bir kuyruğa benzer şekilde davranır. Bir Zaman Serisi Veritabanı yerine Kafka çerçevesinde çok sayıda zaman serisi depolayabilir.

Kafka ve Mongodb Arasındaki Fark Nedir?

Dağıtılmış bir sisteme dayalı, dağıtılmış, bölümlenmiş ve çoğaltılmış bir taahhüt günlüğü hizmetidir. Eşsiz tasarımına rağmen, bir mesajlaşma sisteminin önemli bir bileşenidir. MongoDB ise “Dev fikirlerin veri tabanı” olarak tanımlanıyor.

Kafka kutudan çıkar çıkmaz kuyruğa almayı desteklemediğinden, onu sistemin tüketici versiyonuna hacklemeniz gerekir. İlişkisel bir veritabanı gerekiyorsa, başka bir araç daha fazla kullanılabilir. MongoDB, kullanım kolaylığı ve esnekliği de dahil olmak üzere çeşitli nedenlerle mükemmel bir seçimdir. Apache'nin kullanıcı desteği mevcuttur. Confluent, Linkedin'de Kafka projesiyle aynı zamanda oluşturulmuş bir Kafka'ya (eğer ödemeye istekliyse) sahiptir. Otomatik yedeklemeler gerçekleştiren ve kümeyi otomatik olarak ölçeklendiren bir satıcıya sahip olmak son derece uygundur. MongoDB'yi bilen bir sistem yöneticiniz veya DBA'nız yoksa, MongoDB barındırma konusunda uzmanlaşmış bir üçüncü taraf kullanmak iyi bir fikirdir.

Kafka, en temel haliyle, mesajları kuyruğa almamıza izin vermeyi amaçlamaktadır. Cassandra'nın depolama motoru, verileriniz ne kadar büyük olursa olsun sürekli olarak yazılmasını sağlar. MongoDB, analitik için yerel Hadoop desteğinin yanı sıra özel bir harita/küçültme uygulaması sağlarken Cassandra sağlamaz. Maliyet genellikle makul olduğundan, sizin tarafınızdan veya başka bir sağlayıcı tarafından barındırılması fark etmez.

Kafka'ya Karşı Geleneksel Veritabanı Sistemleri

Kafka ile geleneksel bir veri tabanı sistemi arasında birkaç fark olduğunu not etmek önemlidir.

Kafka bir akış platformu olduğundan, önemli bir ön işlem gerektirmeden yüksek oranda veri alımını işleyebilir.

Veriler, Kafka çalıştırılırken disk okumaları yerine kuyruk okumaları tarafından tüketilir.

Sayfa önbelleğe almanın kullanılması, Kafka için gidiş-dönüş veritabanı ziyaretlerine olan ihtiyacı azaltır.

Aşağı yöndeki müşterilere veri göndermek için Kafka pub/sub mesajlaşmasını kullanır.

Kafka Veritabanı Nedir?

Kafka, genellikle akış verilerini depolamak için kullanılan bir veritabanıdır. Ölçeklenebilir ve hataya dayanıklı olacak şekilde tasarlanmış dağıtılmış bir sistemdir. Kafka, genellikle gerçek zamanlı veri hatları ve akış uygulamaları oluşturmak için kullanılır. Yüksek verim ve düşük gecikme ile başa çıkabilir.

Kafka gibi bir mesaj komisyoncusunun popülaritesi son yıllarda arttı. Taraftarlara göre Kafka, veri yönetiminde bir paradigma değişikliğidir. Birincil veri deponuz olarak Kafka kullanmanın size yalıtım sağlamadığını unutmamak çok önemlidir. Veritabanı sistemlerinin karşılaştığı her sorun gelecekte çözülecektir. Bilgisayar korsanları, otonom mimarilerdeki kusurlardan yararlanarak verileri çalabilir. İki kullanıcı aynı ürünü aynı anda satın almaya çalışırsa, ikisi de başarılı olur ve her ikisinin de envanteri biter. Gaslight cihazlarını çalıştırırken zamanda yolculuk özelliklerini kullanan bu mimariler, olay güdümlü mimarilere dayanır.

Büyük hacimli verileri yönetmek, Kafka'nın mükemmel bir kullanımıdır. İşlemler yine de geleneksel bir DBMS kullanılarak izole edilmelidir. Kabul kontrolü için OLTP veritabanlarını, olay oluşturma için CDC'yi ve veritabanınızı tersyüz etmek için görünümler göründükçe model aşağı akış kopyalarını kullanın.

Kafka, büyük miktarda veriyi depolamak ve günlük olarak işlemek için de kullanılabilir. Büyük verileri toplu veya akış modunda işleyebilme yeteneği, diğer yöntemlere göre bir avantajdır. Kafka işlemi , örneğin birden çok sunucudan günlük dosyalarını almak ve bunları bir veritabanında veya arama dizininde depolamak için kullanılabilir. Verileri gerçek zamanlı olarak işlemek için kullanılabilen bir akış API'si de mevcuttur.

Kafka vs Sql

Genel olarak, Kafka ve MySQL iki türe ayrılır: Mesaj Kuyrukları ve Veritabanı Uygulamaları. Çoğu geliştirici Kafka'yı yüksek verimli, dağıtılmış ve ölçeklenebilir bir çözüm olarak görürken, MySQL basitliği, performansı ve kullanım kolaylığı nedeniyle en popüler olarak görülüyor.

Kafka'da pub-sub mesajlaşma, büyük hacimli verileri işleyebilen dağıtılmış, hataya dayanıklı, yüksek verimli bir sistemdir. MySQL, görev açısından kritik ve ağır yüklü üretim sistemlerinde kullanılması amaçlanan dünyanın en popüler açık kaynak veritabanıdır. Geliştirmeler, yüksek iş hacmi, dağıtılmış mimarisi ve ölçeklenebilirliği nedeniyle Kafka'nın MySQL'den daha güçlü olduğunu düşünüyor; SQL, Ücretsiz ve Kolay ise MySQL kullanıcılarının tercih etmesinin başlıca nedenleridir. Veritabanı yönetim sistemleri (DBMS'ler) ile uygulamalı deneyim kazanmak istiyorsanız PostgreSQL'i öneririm. Vital Beats'te, komut satırını desteklemeye devam ederken etkili veri yönetimi ile yedekleme arasında istenen dengeyi elde etmemizi sağladığı için öncelikle Postgres kullanıyoruz. Veritabanınızı şirket içinde veya bulutta barındırmayı planlıyorsanız, ilk iletişim noktası PaaS (Hizmet Olarak Platform) veritabanlarıdır. MongoDB, verileri tek bir belgeyle aynı düzeyde yazdığından, işlemler olmadan tutarlılık zordur.

Amazon DynamoDB ve AWS RedShift'te bulunanlar gibi belge depoları, MongoDB'de bulunan anahtar/değer çiftlerinden (veya sütun depolarından) çok farklıdır. Geliştirme süresi azaldığı için #Nosql veritabanını kullanarak sorgulama yapmak daha hızlı ve kolaydır. Gayrimenkul sektöründe ilk kez çalışan biri olarak, zamanla oldukça verimli olacak bir veritabanı seçmek istiyorum. Aurora Postgres'i AWS üzerinde tek bir bölge dağıtımıyla çalıştırıyorsanız, önerebileceğim en iyi platformlardan biridir. PostgreSQL'i üç bulut ortamında kullanırsanız, çok bölgeli çoğaltmayı daha iyi deneyimleyeceksiniz. Bunları doğru şekilde yapılandırırsanız, bu üç veri tabanından herhangi biri uzun vadede verimli, ölçeklenebilir ve güvenilir bir şekilde çalışacaktır. Uber, daha çevik ve güvenilir bir veri iletim sistemi ihtiyacı da dahil olmak üzere çeşitli nedenlerle Postgres'ten MySql'e geçti.

OPS Platform'un baş teknoloji sorumlusu, Postgres'in hızı ve kullanım kolaylığı nedeniyle ürünleri için uzun vadeli en etkili seçim olduğunu belirtti. MySQL 7.x ile karşılaştırıldığında MySQL 8.0'da işlemler daha hızlı gerçekleştirilir. Veritabanı daha mı güvenli? Şifreleme anahtarını rastgele değiştirmek mümkün müdür? MySQL ve MongoDB en popüler iki açık kaynak veritabanıdır. Verilerin saklanma kolaylığına ek olarak, MongoDB, İçerik Dağıtım Ağı (CDN) yoluyla gelen büyük miktarda veriyi depolamak için kullanılabilir. Postgres'in diğer nesne-ilişkisel veritabanlarına göre birincil avantajı, genişletilebilirlik ve standartlara uygunluk üzerindeki vurgusudur.

Normal B-ağacı ve hash indekslerinin yanı sıra İfade ve Kısmi İndeksler (tablonun sadece bir bölümünü etkileyenler) oluşturulabilir. Redis ve Kafka arasındaki en temel fark, kurumsal mesajlaşma çerçevelerini kullanmalarıdır. Birini seçerken bulutta yerel olan bir teknoloji arıyorum. Hizmet keşfine ek olarak NATS, yük dengeleme, küresel çoklu kümeler ve diğer işlemlerin yerini almak için kullanılabilir. Redis'in yapmadığı tek şey, saf bir mesaj aracısı olarak hizmet etmektir (yazarken). Sonuç olarak, daha çok genel bir bellek içi anahtar/değer deposudur. Kapsamlı bir müzik kütüphanesine sahip olmama rağmen şarkılarım genellikle iki saatten uzun oluyor.

Ses dosyalarını bir veritabanı satırında birkaç saat saklamanın sorunu, kolayca aranamayacak olmalarıdır. Tercih ederseniz, ses dosyalarını Backblaze b2 veya AWS S3 gibi bir bulut depolama hizmetinde saklamayı düşünün. IoT World üzerinde MQTT Broker kullanan bir çözüm var mı? Veri merkezlerinden birinde barındırılır. Şu anda bunları Uyarı ve Alarmla ilgili amaçlar için işliyoruz. Öncelikli hedefimiz, operasyonel karmaşıklığı ve bakım maliyetlerini azaltan daha hafif ürünler kullanmaktır. Apache Kafka'yı bu ek üçüncü taraf API çağrılarıyla entegre edebilseydik ideal olurdu.

RabbitMQ uygulaması, hem yeniden deneme hem de sıraya alma için mükemmel bir seçimdir. Her mesajın birden fazla kullanıcı tarafından işlenmesi gerekmiyorsa RabbitMQ kullanabilirsiniz. Sistemi onaylarla teslim etmek için Kafka'yı kullanmak mantıklı değil. Kalıcı bir olay durumu yöneticisi gibi Kafka olay durumu yöneticisi, bir akış API'si kullanarak çeşitli veri kaynaklarını dönüştürmenize ve sorgulamanıza olanak tanır. RabbitMQ çerçevesi, bire bir yayıncı veya abone (veya tüketici) için idealdir ve birden çok tüketiciyi etkinleştirmek için bir fanout değişiminin yapılandırılabileceğine inanıyorum. Pushnami projesi, canlı verilerin bir veritabanından diğerine nasıl taşınacağını gösterir. Her ön uç (Angular), arka uç (Node.js) ve ön uç (MongoDB) yerel olduğundan, veri alışverişi çok daha kolaydı.

Çeviri katmanından kaçınmak için ilişkisel ve hiyerarşik kısmı atladım. MongoDB nesnelerinde sonlu bir boyut tutmak ve doğru dizinleri kullanmak çok önemlidir. 1960'ların başlarında, en eski elektronik tıbbi kayıtlardan (EMR'ler) bazıları, belge odaklı bir veri tabanı olan MUMPS'u kullanıyordu. Tüm hastane kayıtlarının %40'a kadarını saklayan MongoDB, sağlam bir tıbbi veri tabanı olarak kabul edilir. Ancak, uzun vadede son derece yavaş olan, yerel olarak desteklenmeyen coğrafi sorgulamayı gerçekleştirmek için bazı çok akıllı yöntemler vardır. Amazon Kinesis, yüzbinlerce kaynaktan saniyede yüzbinlerce veri dosyasını işler. RabbitMQ, herhangi bir uygulamadan mesaj gönderip almanızı kolaylaştırır. Apache ActiveMQ hızlıdır, çok çeşitli diller arası istemcileri destekler ve sağlam bir betik dilidir. Hadoop verileri, Spark adlı hızlı ve genel amaçlı bir işleme motoru kullanılarak işlenir.

Kafka Vs Mongodb

Mongodb, onu çeşitli uygulamalar için iyi bir seçim haline getiren birçok özelliğe sahip, belge odaklı güçlü bir veritabanıdır. Kafka, gerçek zamanlı veri hatları ve akış uygulamaları oluşturmak için kullanılabilen yüksek performanslı bir akış platformudur.

Kaynak olarak MongoDB'den diğer MongoDB kaynaklarına veya diğer MongoDB kaynaklarına aktarımlar, Kafka'dan MongoDB'ye uygulamasıyla sorunsuz olabilir. MongoDB Kafka Connector'ın yardımıyla verileri nasıl verimli bir şekilde aktaracağınızı öğreneceksiniz. Bu özellikle, kuruluşunuz için tamamen yeni bir ETL işlem hattı oluşturabilirsiniz. Confluent, kaynak ve alıcı görevi gören çeşitli bağlayıcılar sunarak kullanıcıların ikisi arasında veri aktarımı yapmasına olanak tanır. Debezium MongoDB bağlayıcıları, Kafka MongoDB kullanıcılarının MongoDB veritabanına bağlanmasını sağlayan bu tür bir bağlantı mekanizmasıdır. Confluent Kafka'yı başlatmadan önce, sisteminizde çalıştığından emin olmalısınız. KStream, KSQL gibi işlevleri veya Spark Streaming gibi başka herhangi bir aracı kullanarak verileri Kafka'da analiz edebilirsiniz.

Ambara veri girişi, özel kodun yanı sıra manuel komut dosyalarını da gerektirir. Hevo'nun kodsuz veri boru hattı platformu, kodlama olmadan basit veri boru hattı sistemleri oluşturmanıza olanak tanır. Hevo'nun şeffaf fiyatlandırma platformu, ELT harcamanızın her ayrıntısını gerçek zamanlı olarak görmenizi sağlar. Deneme süresi 14 gün sürer ve 7×24 desteği içerir. Uçtan uca şifreleme, en katı güvenlik sertifikaları kullanılarak yapılır. Hevo, Kafka ve MongoDB verilerinizi 150 farklı veri kaynağına (40 ücretsiz kaynak dahil) güvenli bir şekilde aktarmak için kullanılabilir.

Kafka ve Mongodb Nedir?

MongoDB Kafka bağlayıcısı, Kafka konularındaki verileri bir veri havuzu olarak MongoDB'de tutan ve bu konulardaki değişiklikleri bir veri kaynağı olarak yayınlayan, Confluent tarafından doğrulanmış bir bağlayıcıdır.

Veritabanı Olarak Kafka Kullanmanın Artıları ve Eksileri

Hangi veritabanı Kafka için iyidir? Prensip olarak, Kafka bir veritabanı oluşturmak için kullanılabilir. Sonuç, onlarca yıldır veritabanı yönetim sistemlerini rahatsız eden her büyük sorunun incelenmesi olacaktır. Veritabanı yönetim sistemi (DBMS), verileri düzenleyen ve sorgulayan bir yazılım türüdür. Büyük ölçekli uygulamalar ve birden çok kullanıcı tarafından erişilmesi gereken verileri depolamak için gereklidirler. Bir DBMS iki türe ayrılır: ilişkisel ve ilişkisel olmayan. İlişkisel model, ilişkisel bir VTYS'de bilgileri temsil etmenin standart bir yöntemidir. Popülerdirler çünkü kullanımları basittir ve tablolar halinde düzenlenmiş verileri depolamak için kullanılabilirler. Kullanıcı ilişkisel modelleri olmayan bir DBMS, diğer modelleri kullanan kadar güçlü değildir. Veriler, veri akışları gibi daha verimli bir şekilde düzenlemek için tablolardan başka biçimlerde de saklanır. Kafka modeli , çeşitli amaçlar için kullanılabilen bir veritabanı oluşturmak için kullanılır. Akış işleme, yeni bir veri temsil modeli olan Kafka'nın merkezinde yer alır. Veri yönetim sistemleri (DMS'ler), veri yönetiminin çok önemli bir bileşenidir. Ancak, Kafka'yı veritabanı olarak kullanmak bazen zor olabilir. DBMS'lerin karşılaştığı en yaygın sorunlardan bazıları performans, ölçeklenebilirlik ve güvenilirliktir. Gönderiyi Fivetran'ın CEO'su George Fraser ve Materialize'ın CEO'su Arjun Narayan birlikte yazdı.

Kafka Kalıcılık Veritabanı

Kafka kalıcı veritabanları, verileri bir kafka kümesinde yüksek düzeyde kullanılabilir ve ölçeklenebilir bir şekilde depolamak için bir yol sağlar. Varsayılan olarak kafka, verileri depolamak için bir bellek içi veritabanı kullanır, ancak bu, üretim dağıtımları için uygun değildir. Kafka verileri için daha güvenilir bir depolama seçeneği sağlamak için bir kafka kalıcılık veritabanı kullanılabilir.

LinkedIn, açık kaynaklı Apache kaffef'i 2011'de yarattı. Bu platform, gerçek zamanlı verilerin son derece düşük gecikme süresi ve aktarım hızıyla beslenmesini sağlar. Çoğu durumda, veriler Kafka Connect aracılığıyla harici sistemlerden içe ve dışa aktarılabilir. Yeni çözümler, verimsiz depolama performansı ve sürücülerin yetersiz kullanımı gibi sorunlarda yardımcı olabilir. Mimarinin zorluklarına rağmen yerel flaş, Kafka sistemleri için mükemmel bir seçimdir. Kakfa'daki her konuya yalnızca bir sürücüden erişilebildiğinden, eksik kullanımda bir artış olacaktır. Senkronizasyon da zor olabilir, bu da maliyet ve verimlilik sorunlarına yol açar.

Bir SSD arızalandığında, içindeki veriler tamamen yeniden oluşturulmalıdır. Bu zaman alan prosedür, küme performansını düşürür. Kafka, güvenilirlik ve performans arasındaki dengeyi düzleştirdiği için en çok NVMe/TCP tabanlı depolamaya uygundur.

Kafka Harika Bir Mesajlaşma Sistemidir, Ancak Veri Depolamak İçin Mükemmel Bir Çözüm Değildir

Kafka, veri depolamak için kullanılabilecek mükemmel bir mesajlaşma sistemidir. Kafka'nın tutma seçeneklerinden biri, ömür boyu saklama anlamına gelen -1 tutma süresidir. Bununla birlikte, Kafka'nın güvenilirliği, geleneksel bir veri tabanının güvenilirliğinden çok daha düşüktür. Kafka'nın verileri diskte, sağlama toplamında ve hata toleransı için çoğaltılmış olarak sakladığını unutmamak önemlidir, bu nedenle daha fazla depolanmış veri biriktirmek onu yavaşlatmaz. Kafka, mesaj göndermek ve almak için kullanılabilir, ancak veri depolamak için en iyi seçenek değildir.

Kafka Nedir?

Kafka hızlı, ölçeklenebilir, dayanıklı ve hataya dayanıklı bir yayınla-abone ol mesajlaşma sistemidir. Kafka, LinkedIn, Twitter, Netflix ve Airbnb gibi şirketler tarafından prodüksiyonda kullanılmaktadır.

Kafka'nın sade ve anlaşılır bir tasarımı var. Bir makine kümesinde çalışan ve yatay olarak ölçeklenebilen dağıtılmış bir sistemdir. Kafka, yüksek verim ve düşük gecikme ile başa çıkmak için tasarlanmıştır.

Kafka, gerçek zamanlı veri akış hatları ve uygulamaları oluşturmak için kullanılır. Verileri gerçek zamanlı olarak işlemek ve toplamak için kullanılabilir. Kafka ayrıca olay işleme, günlüğe kaydetme ve denetleme için de kullanılabilir.

LinkedIn, gerçek zamanlı veri akışlarını işlemek için 2011'de Kafka'yı başlattı. Kafka, bugün Fortune 100'ün %80'inden fazlası tarafından kullanılıyor. Kafka Streams API , anında işlemeye izin vermek için tasarlanmış güçlü, hafif bir kitaplıktır. Popüler dağıtılmış veritabanlarına ek olarak Kafka, dağıtılmış bir işlem günlüğünün bir soyutlamasını içerir. Mesajlaşma kuyruklarından farklı olarak Kafka, yüksek oranda uyarlanabilir, hataya dayanıklı, yüksek ölçeklenebilirliğe sahip dağıtılmış bir sistemdir. Örnek olarak, Uber'de yolcu ve sürücü eşleştirmeyi yönetmek veya British Gas'ta gerçek zamanlı analitik sağlamak için kullanılabilir. Birçok mikro hizmet Kafka'ya güvenir. Confluent'in bulutta yerel, eksiksiz ve tamamen yönetilen hizmeti, Kafka'nınkinden üstündür. Confluent, tarihsel ve gerçek zamanlı verileri tek bir birleşik gerçek kaynağında birleştirerek tamamen yeni bir modern, olay odaklı uygulama kategorisi oluşturmayı kolaylaştırır.

Kinesis'in yardımıyla çok çeşitli veri akışlarını işleyebilir, bu da onu güçlü ve çok yönlü bir akış işleme platformu haline getirir. Hızı, basitliği ve çok çeşitli cihazlarla uyumluluğu nedeniyle popüler bir platformdur. Güvenilirliği nedeniyle, en popüler akış platformlarından biridir. Dayanıklılığı sayesinde yüksek hacimli verileri herhangi bir sorun yaşamadan işleyebilir. Ayrıca, yaygın olarak kullanılan ve desteklenen iyi bilinen bir platform olduğu için, onu kullanmaya başlamanıza yardımcı olacak bir ortak veya entegratör bulmak kolaydır. Hem güçlü hem de güvenilir bir akış platformu arıyorsanız, Kinesis mükemmel bir seçimdir.

Kafka: Veritabanlarının Yerini Alan Mesajlaşma Sistemi

Gerçek zamanlı akış veri boru hattı ve uygulamaları oluşturmaya yönelik bir mesajlaşma sistemi olan Kafka kullanılarak, değişen veri ortamına uyum sağlamak için gerçek zamanlı veri akışları yapılabilir. Büyük veriler, Scala ve Java'da yazılmış Kafka kullanılarak gerçek zamanlı olay akışlarıyla işlenir. Bir Kafka bağlantısı bir noktadan diğerine genişletilebilir ve kaynaklar arasında veri göndermek için de kullanılabilir. Etkinlik akışı platformu, etkinliklerin canlı akışını sağlamak için tasarlanmıştır. Veritabanlarını Kafka gibi mesajlaşma çözümleriyle karşılaştırmak haksızlık olur. Kafka'daki özellikler nedeniyle artık veritabanlarına gerek yoktur.

Kafka Bir Veri Tabanı Değildir

Kafka bir veritabanı değildir, ancak genellikle biriyle birlikte kullanılır. Bir sistemin farklı bileşenleri arasında mesaj göndermek için kullanılabilen bir mesaj aracısıdır. Genellikle bir sistemin farklı parçalarını bağımsız olarak ölçeklenebilmeleri için ayırmak için kullanılır.

Apache Kafka'yı bir veritabanıyla değiştirmek mümkündür, ancak kolaylık olması açısından bunu yapmayın. İkinci el, ortadan motorlu bir İtalyan süper otomobil satın alan kahramanların her birinin 10.000 dolar aldığı Top Gear bölümü bana, kahramanların her birine 10.000 dolar verildiği eski bir Top Gear bölümünü hatırlattı. 2011'de LinkedIn, Kafka'yı yayınladı ve bu bölüm aynı yıl yayınlandı. Tam özellikli bir mesajlaşma platformuna yatırım yapmadan minimum düzeyde kalıcı mesajlaşma yapmanızı sağlar. Temel öncül, temel bir kuralın olduğudur. Üretici süreci sırasında kaydedilen her olay için bir tablo (veya grup, koleksiyon, dizin, her neyse) oluşturun. Veri tabanını bir tüketici eşgörünümünden düzenli olarak yoklayın ve işlenirken tüketicinin durumunu güncelleyin.

Modelin sağlıklı çalışabilmesi için üreticilerin ve tüketicilerin aynı anda çalışabilmesi gerekmektedir. Kafka'nın kitabını bir rehber olarak kullanmayı ve kayıtları sadece okumak yerine süresiz olarak saklamayı düşünün. Öte yandan, ayrık tüketici grupları, ekleme sırasında kayıtları çoğaltmak ve ardından tüketimden sonra kayıtları silmek suretiyle uygulanabilir. Kafka, kullanıcı tanımlı veri yelpazesini etkinleştirmek ve birden çok ayrık tüketiciyi desteklemek için kalıcı ofsetler kullanır. Bu işlevi sonlandırmak için sıfırdan bir hizmet geliştirmelisiniz. Zamana dayalı tasfiye kavramını uygulamak zor değil ama çöpçülerin mantığını barındırmak gerekiyor. Kafka'da tüm aktörler (tüketiciler, üreticiler ve yöneticiler) üzerinde ayrıntılı kontroller vardır.

Emtia ve bulut sunucularında saniyede milyonlarca kaydı sorunsuz bir şekilde işleyebilir. Kafka, işlevsel olmayan bir anlamda hem üretici hem de tüketici tarafında yüksek düzeyde verim için optimize edilmiştir. Kafka'yı kullanarak, bu alanda rakipsiz olan, dağıtılmış, yalnızca eklenen bir günlüktür. İletileri tüketim aşamasında kaldıran geleneksel ileti simsarlarının aksine, Kafka iletileri tüketildikten sonra temizlemez. Bir veritabanının iş hacmi ve gecikmesinin, özel donanım ve yüksek düzeyde odaklanmış performans ayarı kullanılarak neredeyse kesinlikle önemli ölçüde iyileştirilmesi gerekecektir. Bir komisyoncudan vazgeçmek ilk bakışta çekici gelebilir. Kafka gibi bir akış etkinliği platformu kullandığınızda, yapımında harcanan muazzam mühendislik çabasından yararlanırsınız.

Bugün devreye almayı seçtiğiniz çözümün sürdürülebilmesini sağlamak için, bunun yüksek bir standartta sürdürülebileceğinden emin olmalısınız. Bir olay deposundaki işlevlerin çoğu, yalnızca bir veritabanı kullanılarak uygulanabilir. Herkese uyan tek bir etkinlik mağazası yoktur; önemsiz olmayan herhangi bir olay deposu, çoğu durumda, neredeyse kesinlikle bir veya daha fazla kullanıma hazır veri tabanı tarafından desteklenen ısmarlama bir uygulamadır. Verimli erişim için veri düzenleme alanında veritabanlarını kullanabilirsiniz, ancak verileri (neredeyse) gerçek zamanlı dağıtmak için bunları kullanmaktan kaçınmalısınız.