Kafka: un'ottima scelta per i broker di messaggi nei microservizi

Pubblicato: 2022-11-19Kafka è una piattaforma di streaming distribuita. Viene spesso utilizzato per l'aggregazione di log, l'elaborazione di flussi in tempo reale e l'origine di eventi. Recentemente, Kafka ha guadagnato popolarità come broker di messaggi per microservizi. Kafka non è una coda di messaggi tradizionale come ActiveMQ o RabbitMQ. Non ha un server centrale che memorizza tutti i messaggi. Utilizza invece un modello di pubblicazione-sottoscrizione. I messaggi vengono archiviati in argomenti e ogni argomento può avere più partizioni. Kafka è altamente disponibile e scalabile. Può gestire miliardi di messaggi al giorno. Kafka è anche molto veloce. Può elaborare i messaggi in tempo reale. Kafka è un'ottima scelta per creare un broker di messaggi per microservizi. È altamente disponibile, scalabile e veloce.

Kafka, che è un sistema di messaggistica in tempo reale, lo rende possibile. I flussi di dati sono protetti dalle interferenze e possono essere distribuiti o tolleranti ai guasti. Il Kafka Data Integration Bus è un protocollo di scambio di dati che consente a un'ampia gamma di produttori e consumatori di condividere i dati. Le capacità di Kafka sono simili a quelle di MongoDB e RDS, che fungono da buffer di dati alla fine dell'applicazione.

KSQL, un linguaggio di scripting basato su SQL, viene utilizzato per analizzare ed elaborare dati di streaming in tempo reale in Apache Kafka . KSQL include un framework interattivo per l'elaborazione dei flussi, che ha lo scopo di consentire all'utente di eseguire attività di elaborazione dei flussi come l'aggregazione dei dati, il filtraggio, l'unione, la creazione di sessioni, il windowing e così via.

È molto più di un eccellente broker di messaggi, come dimostrato da Apache Kafka. L'implementazione del framework ha una serie di funzionalità simili a database che lo rendono adatto per l'uso in un database. Di conseguenza, ora funge da record dell'evento aziendale anziché fare affidamento su database relazionali.

L' applicazione Kafka consente di risparmiare tempo ed energia eseguendo lo streaming di dati da MongoDB in modo semplice ed efficiente. MongoDB è necessario per le aziende per pubblicare grandi quantità di dati ad altri abbonati e gestire più flussi di dati. Il servizio di connessione Kafka MongoDB consente agli sviluppatori di creare più flussi asincroni con MongoDB, che è uno strumento di settore popolare.

In un database, Apache Kafka funge da modello. Centinaia di aziende lo utilizzano per fornire garanzie ACID ed eseguire attività mission-critical. Nella maggior parte dei casi, tuttavia, Kafka non è competitivo come altri database.

Che tipo di database è Kafka?

Kafka è un tipo di database utilizzato per archiviare e recuperare i messaggi. È un sistema distribuito progettato per essere scalabile e tollerante ai guasti.

È una piattaforma di elaborazione del flusso open source scritta in Scala e Java che fa parte del progetto Kafka della Apache Software Foundation. Un flusso in informatica è una raccolta di elementi informativi resi disponibili nel tempo. I flussi possono essere definiti come elementi in un nastro trasportatore che vengono elaborati uno alla volta. I flussi, nella loro forma più elementare, possono essere una serie di eventi apparentemente non correlati. I concetti di sourcing di eventi differiscono dai concetti di data warehousing e analisi dei dati a cui sono abituati gli sviluppatori. Come uso Kafka come database? Blue è l'azienda che dice sì all'affare.

Secondo il Team Red, i programmatori commettono un grosso errore quando passano dai database convenzionali a Kafka. Secondo Martin Kleppmann, il messaggio del Team Red secondo cui Kafka è per tutti è condiscendente. Il problema che il Team Red ha con Kafka e gli stream è che hanno un problema con gli sviluppatori che buttano via gli RDMS. Quando viene presentato un registro permanente degli eventi, avrà sempre il suo contesto storico, facilitando l'audit. L'amministrazione dei database presenta numerosi vantaggi, ma è anche uno degli aspetti più difficili. Il database tradizionale opera in due modi completamente diversi: unisce letture e scritture. È fondamentale per i programmatori mantenere e sincronizzare i dati duplicati su più tabelle.

La scala cambia il modello mentre procedi. Gli stream si distinguono per una chiara distinzione tra le preoccupazioni dei lettori e degli scrittori. Non esiste alcuna relazione tra la velocità con cui Kafka scrive su un file e la velocità con cui Elastic Search può inviarvi aggiornamenti. Di conseguenza, gli utenti di Kafka elaborano i log per generare varie viste materializzate. Far funzionare le viste materializzate come comodo meccanismo di memorizzazione nella cache richiede alcuni costi iniziali. Le viste materializzate, oltre a memorizzare i propri dati e il ridimensionamento, sono componenti importanti dell'infrastruttura. Per il 99% delle aziende, i DBMS sono la base migliore.

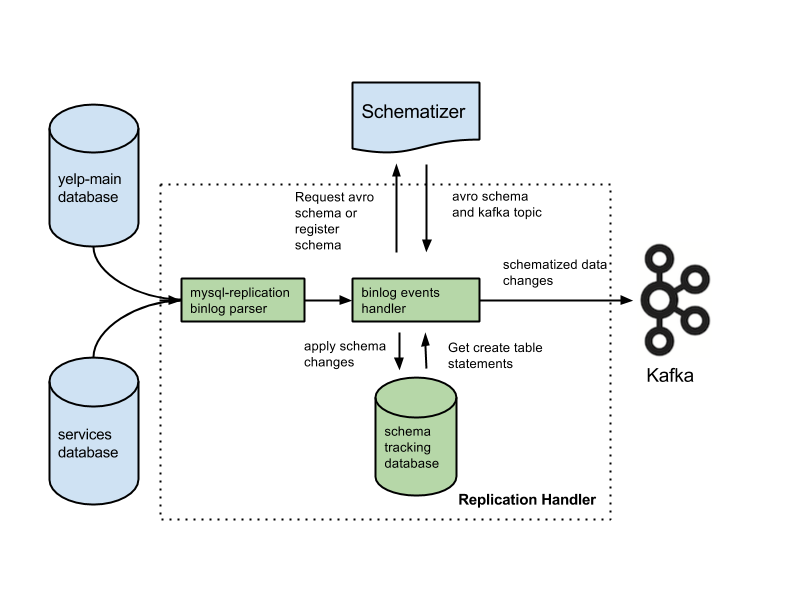

La tua applicazione potrebbe rientrare in questa categoria e potresti avere diritto a una nuova architettura basata sul tuo background. Molte funzionalità critiche andranno perse se si sostituiscono i database con i registri. Le funzionalità includono vincoli di chiave esterna, transazioni atomiche (tutto o niente) e tecniche di isolamento procedurale che aiutano con i problemi di concorrenza. Arjun presuppone che l'integrità della tua applicazione sia mantenuta in ogni momento. Funzionalità di base che la maggior parte delle persone dà per scontate diventano responsabilità extra mentre lavori sugli stream. È fondamentale separare l'intenzione dalla dichiarazione scritta. Una configurazione comune consiste nell'usare Kafka insieme a un sistema Change Data Capture.

Secondo Team Red, le funzionalità di integrità dei dati dei database sono fondamentali per ottenere il controllo dei dati. Le transazioni devono essere isolate dai database convenzionali affinché possano essere prese in considerazione. Di conseguenza, un singolo pezzo di scrittura può essere costoso. Se la tua applicazione fatica a far fronte al volume di scritture costose, potresti essere costretto a migrare a un database più convenzionale. Il Team Red non menziona che l'utilizzo di un database davanti a Kafka riduce le sue migliori caratteristiche.

I vantaggi di questo design sono significativi rispetto ai tradizionali sistemi di messaggistica. Il primo vantaggio di Kafka è che può gestire un numero elevato di richieste. Inoltre, poiché i dati vengono scritti su disco solo quando necessario, Kafka può gestire enormi quantità di dati.

SQL Server è uno strumento di database che rientra nella categoria degli strumenti. Questo dispositivo portatile è versatile e affidabile, ma a volte può essere difficile da usare. Kafka e Azure sono entrambe piattaforme estremamente capaci, ma Kafka viene ridimensionato mentre Azure viene ridimensionato.

SQL Server è uno strumento eccellente per le aziende che richiedono grandi quantità di archiviazione dei dati, ma potrebbe non essere la scelta migliore per coloro che richiedono una scalabilità rapida o un throughput elevato. Per le aziende che devono elaborare grandi quantità di dati senza compromettere le prestazioni, Kafka è una scelta migliore rispetto a SQL Server.

Kafka: un sistema di archiviazione distribuito per la telemetria delle serie temporali

Un sistema di archiviazione distribuito Kafka, che utilizza un modello basato su argomenti, memorizza i dati. I dati possono essere archiviati in un modello basato su argomenti di un database Kafka anziché in un database relazionale. Si comporta in modo simile a una coda in un Kafka Topic , anche se non nello stesso modo di una coda. Può archiviare un gran numero di serie temporali nel framework Kafka anziché in un database delle serie temporali.

Qual è la differenza tra Kafka e MongoDB?

È un servizio di log di commit distribuito, partizionato e replicato basato su un sistema distribuito. Nonostante il suo design unico, è un componente importante di un sistema di messaggistica. MongoDB, d'altra parte, è descritto come "Il database per idee giganti".

Poiché Kafka non supporta l'accodamento predefinito, è necessario inserirlo in una versione consumer del sistema. Se è richiesto un database relazionale, un altro strumento potrebbe essere di maggiore utilità. MongoDB è una scelta eccellente per una serie di motivi, tra cui la facilità d'uso e la flessibilità. Il supporto utente di Apache è disponibile. Confluent ha un Kafka (se disposto a pagare) che è stato creato su Linkedin contemporaneamente al progetto Kafka. Avere un fornitore che esegue backup automatici e ridimensiona automaticamente il cluster è estremamente conveniente. Se non si dispone di un amministratore di sistema o di un DBA che conosca MongoDB, è una buona idea utilizzare una terza parte specializzata nell'hosting di MongoDB.

Kafka, nella sua forma più elementare, ha lo scopo di permetterci di mettere in coda i messaggi. Il motore di archiviazione di Cassandra garantisce la scrittura a tempo costante sui tuoi dati, indipendentemente dalla loro dimensione. MongoDB fornisce un'implementazione di mappatura/riduzione personalizzata nonché il supporto Hadoop nativo per l'analisi, mentre Cassandra no. Non fa differenza se è ospitato da te o da un altro provider perché il costo è generalmente ragionevole.

Kafka vs. Sistemi di database tradizionali

È importante notare che ci sono molte differenze tra Kafka e un sistema di database tradizionale.

Poiché Kafka è una piattaforma di streaming, può gestire un'elevata velocità di acquisizione di dati senza richiedere un'elaborazione preventiva significativa.

I dati vengono consumati dalle letture della coda anziché dalle letture del disco durante l'esecuzione di Kafka.

L'uso della memorizzazione nella cache delle pagine riduce la necessità di visite al database di andata e ritorno per Kafka.

Per inviare i dati a valle ai clienti a valle, Kafka utilizza la messaggistica pub/sub.

Che cos'è il database di Kafka

Kafka è un database che viene spesso utilizzato per archiviare dati in streaming. È un sistema distribuito progettato per essere scalabile e tollerante ai guasti. Kafka viene spesso utilizzato per creare pipeline di dati in tempo reale e app di streaming. Può gestire un throughput elevato e una bassa latenza.

Un broker di messaggi come Kafka è cresciuto in popolarità negli ultimi anni. Secondo i sostenitori, Kafka è un cambio di paradigma nella gestione dei dati. È fondamentale ricordare che l'utilizzo di Kafka come archivio dati principale non fornisce isolamento. Ogni problema riscontrato dai sistemi di database verrà risolto in futuro. Gli hacker possono rubare i dati sfruttando i difetti nelle architetture autonome. Se due utenti tentano di acquistare lo stesso articolo contemporaneamente, entrambi avranno successo e esauriremo l'inventario per entrambi. Queste architetture, che utilizzano funzionalità di viaggio nel tempo durante l'esecuzione di appliance gaslight, si basano su architetture guidate dagli eventi.

La gestione di grandi volumi di dati è un uso eccellente di Kafka. Le transazioni dovrebbero comunque essere isolate utilizzando un DBMS tradizionale. Utilizza i database OLTP per il controllo dell'ammissione, CDC per la generazione di eventi e modella le copie a valle man mano che le viste vengono visualizzate per capovolgere il tuo database.

Kafka può anche essere utilizzato per archiviare grandi quantità di dati ed elaborarli quotidianamente. La capacità di elaborare big data in modalità batch o streaming è un vantaggio rispetto ad altri metodi. Il processo Kafka può essere utilizzato per recuperare i file di registro da più server e archiviarli in un database o in un indice di ricerca, ad esempio. È disponibile anche un'API di streaming che può essere utilizzata per elaborare i dati in tempo reale.

Kafka contro Sql

In generale, Kafka e MySQL sono classificati in due tipi: code di messaggi e applicazioni database. La maggior parte degli sviluppatori considera Kafka una soluzione ad alto throughput, distribuita e scalabile, mentre MySQL è considerato il più popolare per la sua semplicità, prestazioni e facilità d'uso.

La messaggistica Pub-sub su Kafka è un sistema distribuito, tollerante ai guasti e ad alto throughput in grado di gestire grandi volumi di dati. MySQL è il database open source più popolare al mondo, destinato all'uso in sistemi di produzione mission-critical e con carichi pesanti. Gli sviluppi considerano Kafka più potente di MySQL a causa del suo elevato throughput, architettura distribuita e scalabilità; mentre SQL, Free e Easy sono i motivi principali per cui gli utenti MySQL lo preferiscono. Raccomando PostgreSQL se vuoi fare esperienza pratica con i sistemi di gestione dei database (DBMS). In Vital Beats, utilizziamo principalmente Postgres perché ci consente di raggiungere l'equilibrio desiderato tra un'efficace gestione dei dati e il backup, pur continuando a supportare la riga di comando. Se prevedi di ospitare il tuo database in locale o nel cloud, il primo punto di contatto sono i database PaaS (Platform as a Service). Poiché MongoDB scrive i dati sullo stesso livello di un documento, la coerenza è difficile senza transazioni.

Gli archivi di documenti, come quelli che si trovano in Amazon DynamoDB e AWS RedShift, sono molto diversi dalle coppie chiave-valore (o archivi di colonne) che si trovano in MongoDB. È più veloce e più facile eseguire query utilizzando il database #Nosql perché il tempo di sviluppo è ridotto. Come impiegato per la prima volta nel settore immobiliare, vorrei selezionare un database che sarà altamente produttivo nel tempo. Se esegui Aurora Postgres su AWS con una distribuzione in un'unica regione, è una delle migliori piattaforme che raccomando. Se utilizzi PostgreSQL in tre ambienti cloud, sperimenterai una migliore replica in più regioni. Se li configuri correttamente, ognuno di questi tre database funzionerà in modo efficiente, scalabile e affidabile a lungo termine. Uber è passato da Postgres a MySql per una serie di motivi, inclusa la necessità di un sistema di trasmissione dati più agile e affidabile.

Il chief technology officer di OPS Platform ha affermato che Postgres è stata la scelta più efficace a lungo termine per il loro prodotto grazie alla sua velocità e facilità d'uso. Rispetto a MySQL 7.x, le transazioni vengono gestite più rapidamente in MySQL 8.0. Un database è più sicuro? È possibile modificare la chiave di crittografia in modo casuale? MySQL e MongoDB sono i due database open source più popolari. Oltre alla facilità con cui i dati possono essere archiviati, MongoDB può essere utilizzato per archiviare grandi quantità di dati in entrata tramite il Content Distribution Network (CDN). Il vantaggio principale di Postgres rispetto ad altri database relazionali a oggetti è la sua enfasi sull'estensibilità e la conformità agli standard.

È possibile creare indici B-tree e hash regolari, nonché indici di espressione e indici parziali (quelli che interessano solo una parte della tabella). La distinzione più basilare tra Redis e Kafka è il loro uso di framework di messaggistica aziendale. Sto cercando una tecnologia che sia nativa del cloud quando ne scelgo una. Oltre al rilevamento dei servizi, NATS può essere utilizzato per sostituire il bilanciamento del carico, i multicluster globali e altre operazioni. L'unica cosa che Redis non fa è fungere da puro broker di messaggi (al momento della scrittura). Di conseguenza, è più un archivio di valore-chiave in memoria generale. Nonostante abbia una vasta libreria musicale, le mie canzoni durano spesso più di due ore.

Il problema con l'archiviazione di file audio in una riga del database per diverse ore è che non sono facilmente ricercabili. Se preferisci, considera l'archiviazione dei file audio in un servizio di archiviazione cloud come Backblaze b2 o AWS S3. Esiste una soluzione che utilizza MQTT Broker su IoT World? È ospitato in uno dei data center. Attualmente lo stiamo elaborando per scopi relativi ad avvisi e allarmi. Il nostro obiettivo principale è utilizzare prodotti più leggeri che riducano la complessità operativa e i costi di manutenzione. Sarebbe l'ideale se potessimo integrare Apache Kafka con queste ulteriori chiamate API di terze parti.

L'app RabbitMQ è una scelta eccellente sia per riprovare che per mettere in coda. Se non hai bisogno che ogni messaggio venga elaborato da più di un utente, puoi utilizzare RabbitMQ. Non ha senso usare Kafka per consegnare il sistema con le conferme. Il gestore dello stato dell'evento di Kafka, come un gestore dello stato dell'evento persistente, consente di trasformare e interrogare varie fonti di dati utilizzando un'API di flusso. Il framework RabbitMQ è ideale per un editore o abbonato (o consumatore) one-to-one e credo che uno scambio di fanout possa essere configurato per abilitare più consumatori. Il progetto Pushnami dimostra come migrare i dati in tempo reale da un database all'altro. Poiché ogni frontend (Angular), backend (Node.js) e frontend (MongoDB) è nativo, lo scambio di dati è stato molto più semplice.

Per evitare il livello di traduzione, ho saltato la parte relazionale con quella gerarchica. È fondamentale mantenere una dimensione finita negli oggetti MongoDB e utilizzare indici corretti. Già negli anni '60, alcune delle prime cartelle cliniche elettroniche (EMR) utilizzavano MUMPS, un database orientato ai documenti. MongoDB, che memorizza fino al 40% di tutte le cartelle cliniche, è considerato un robusto database medico. Tuttavia, ci sono stati alcuni metodi molto intelligenti per eseguire query geografiche non supportate in modo nativo, che a lungo termine sono estremamente lente. Amazon Kinesis elabora centinaia di migliaia di file di dati al secondo da centinaia di migliaia di fonti. RabbitMQ semplifica l'invio e la ricezione di messaggi da qualsiasi app. Apache ActiveMQ è veloce, supporta un'ampia gamma di client multilingua ed è un solido linguaggio di scripting. I dati Hadoop vengono elaborati utilizzando un motore di elaborazione rapido e generico denominato Spark.

Kafka contro Mongodb

MongoDB è un potente database orientato ai documenti che ha molte caratteristiche che lo rendono una buona scelta per una varietà di applicazioni. Kafka è una piattaforma di streaming ad alte prestazioni che può essere utilizzata per creare pipeline di dati in tempo reale e applicazioni di streaming.

I trasferimenti da MongoDB come origine ad altre origini MongoDB o ad altre origini MongoDB possono essere eseguiti senza problemi con l'applicazione Kafka to MongoDB. Con l'aiuto di MongoDB Kafka Connector, imparerai come trasferire i dati in modo efficiente. Con questa funzione, puoi creare una pipeline ETL completamente nuova per la tua organizzazione. Confluent offre una varietà di connettori che fungono da sorgente e sink, consentendo agli utenti di trasferire i dati tra i due. I connettori Debezium MongoDB sono uno di questi meccanismi di connettività che consente agli utenti di Kafka MongoDB di connettersi al database MongoDB. Prima di poter avviare Confluent Kafka, devi prima assicurarti che sia in esecuzione sul tuo sistema. Utilizzando funzionalità come KStream, KSQL o qualsiasi altro strumento come Spark Streaming, puoi analizzare i dati in Kafka.

L'inserimento dei dati nel magazzino richiede script manuali e codice personalizzato. La piattaforma di pipeline di dati senza codice di Hevo consente di creare semplici sistemi di pipeline di dati senza codifica. La piattaforma di prezzo trasparente di Hevo ti consente di vedere ogni dettaglio della tua spesa ELT in tempo reale. Il periodo di prova dura 14 giorni e include il supporto 24×7. La crittografia end-to-end viene eseguita utilizzando le più rigorose certificazioni di sicurezza. Hevo può essere utilizzato per trasferire in modo sicuro i tuoi dati Kafka e MongoDB a 150 diverse fonti di dati (incluse 40 fonti gratuite).

Cos'è Kafka e Mongodb?

Il connettore MongoDB Kafka è un connettore verificato da Confluent che conserva i dati degli argomenti Kafka come data sink in MongoDB e pubblica le modifiche a tali argomenti come origine dati.

I pro ei contro dell'utilizzo di Kafka come database

Quale database va bene per Kafka? In linea di principio, Kafka può essere utilizzato per creare un database. Il risultato sarà un esame di tutti i principali problemi che hanno afflitto i sistemi di gestione dei database per decenni. Un sistema di gestione di database (DBMS) è un tipo di software che organizza e interroga i dati. Sono necessari per applicazioni su larga scala e per l'archiviazione di dati a cui devono accedere più utenti. Un DBMS è classificato in due tipi: relazionale e non relazionale. Il modello relazionale è un metodo standard per rappresentare le informazioni in un DBMS relazionale. Sono popolari perché sono semplici da usare e possono essere utilizzati per archiviare dati organizzati in tabelle. Un DBMS che non utilizza modelli relazionali non è potente come uno che utilizza altri modelli. I dati vengono archiviati anche in formati diversi dalle tabelle per organizzarli in modo più efficiente, come flussi di dati. Il modello Kafka viene utilizzato per creare un database, che può essere utilizzato per una varietà di scopi. L'elaborazione del flusso è al centro di Kafka, un nuovo modello di rappresentazione dei dati. I sistemi di gestione dei dati (DMS) sono una componente cruciale della gestione dei dati. Tuttavia, a volte l'utilizzo di Kafka come database può essere difficile. Alcuni dei problemi più comuni riscontrati dai DBMS sono le prestazioni, la scalabilità e l'affidabilità. George Fraser, CEO di Fivetran, e Arjun Narayan, CEO di Materialise, hanno co-scritto il post.

Database di persistenza di Kafka

I database di persistenza Kafka forniscono un modo per archiviare i dati in un cluster Kafka in modo altamente disponibile e scalabile. Per impostazione predefinita, kafka utilizzerà un database in memoria per archiviare i dati, ma non è adatto per le distribuzioni di produzione. Un database di persistenza kafka può essere utilizzato per fornire un'opzione di archiviazione più affidabile per i dati kafka.

LinkedIn ha creato l'apache kaffef open source nel 2011. Questa piattaforma consente l'alimentazione di dati in tempo reale con latenza e throughput estremamente bassi. Nella maggior parte dei casi, i dati possono essere importati ed esportati tramite Kafka Connect da sistemi esterni. Nuove soluzioni possono aiutare con problemi come prestazioni di archiviazione inefficienti e sottoutilizzo delle unità. Nonostante le sfide dell'architettura, il flash locale è una scelta eccellente per i sistemi Kafka. Poiché ogni argomento in Kakfa è accessibile solo su un'unità, ci sarà un aumento del sottoutilizzo. Anche la sincronizzazione può essere difficile, con conseguenti problemi di costi ed efficienza.

Quando un SSD si guasta, i dati da esso devono essere completamente ricostruiti. Questa procedura che richiede tempo riduce le prestazioni del cluster. Kafka è più adatto allo storage basato su NVMe/TCP perché appiattisce il compromesso tra affidabilità e prestazioni.

Kafka è un fantastico sistema di messaggistica, ma non una soluzione perfetta per l'archiviazione dei dati

Kafka è un eccellente sistema di messaggistica che può essere utilizzato per archiviare dati. Una delle opzioni di conservazione di Kafka è un tempo di conservazione di -1, che si riferisce a una conservazione a vita. Tuttavia, l'affidabilità di Kafka è di gran lunga inferiore a quella di un database tradizionale. È importante notare che Kafka archivia i dati su disco, checksum e replicati per la tolleranza agli errori, quindi l'accumulo di più dati archiviati non lo rallenta. Kafka può essere utilizzato per inviare e ricevere messaggi, ma non è la scelta migliore per archiviare i dati.

Cos'è Kafka

Kafka è un sistema di messaggistica di pubblicazione-sottoscrizione veloce, scalabile, duraturo e tollerante ai guasti. Kafka è utilizzato nella produzione da aziende come LinkedIn, Twitter, Netflix e Airbnb.

Kafka ha un design semplice e diretto. È un sistema distribuito che gira su un cluster di macchine e può essere scalato orizzontalmente. Kafka è progettato per gestire un throughput elevato e una bassa latenza.

Kafka viene utilizzato per creare pipeline e applicazioni di dati in streaming in tempo reale. Può essere utilizzato per elaborare e aggregare i dati in tempo reale. Kafka può essere utilizzato anche per l'elaborazione degli eventi, la registrazione e il controllo.

LinkedIn ha lanciato Kafka nel 2011 per gestire i feed di dati in tempo reale. Kafka è utilizzato oggi da oltre l'80% delle Fortune 100. Un'API Kafka Streams è una libreria potente e leggera progettata per consentire l'elaborazione al volo. Oltre ai popolari database distribuiti, Kafka include un'astrazione di un log di commit distribuito. A differenza delle code di messaggistica, Kafka è un sistema distribuito altamente adattabile e tollerante ai guasti con un'elevata scalabilità. Ad esempio, potrebbe essere utilizzato per gestire l'abbinamento di passeggeri e conducenti presso Uber o fornire analisi in tempo reale presso British Gas. Molti microservizi si affidano a Kafka. Il servizio cloud-native, completo e completamente gestito di Confluent è superiore a quello di Kafka. Confluent semplifica la creazione di una categoria completamente nuova di applicazioni moderne basate su eventi combinando dati storici e in tempo reale in un'unica fonte di verità unificata.

Con l'aiuto di Kinesis, puoi gestire un'ampia gamma di flussi di dati, rendendola una piattaforma di elaborazione dei flussi potente e versatile. È una piattaforma popolare per la sua velocità, semplicità e compatibilità con un'ampia gamma di dispositivi. A causa della sua affidabilità, è una delle piattaforme di streaming più popolari. Può gestire un volume elevato di dati senza riscontrare problemi grazie alla sua durata. Inoltre, poiché si tratta di una piattaforma ben nota, ampiamente utilizzata e supportata, è semplice trovare un partner o un integratore che ti aiuti a iniziare. Se stai cercando una piattaforma di streaming potente e affidabile, Kinesis è una scelta eccellente.

Kafka: il sistema di messaggistica che sta sostituendo i database

I flussi di dati in tempo reale possono essere adattati al mutevole ambiente dei dati utilizzando Kafka, un sistema di messaggistica per la creazione di pipeline e applicazioni di dati in streaming in tempo reale. I big data vengono elaborati tramite flussi di eventi in tempo reale attraverso l'uso di Kafka, che è scritto in Scala e Java. Una connessione Kafka può essere estesa da un punto all'altro e può anche essere utilizzata per inviare dati tra origini. La piattaforma di streaming degli eventi ha lo scopo di fornire lo streaming live degli eventi. Non è giusto confrontare i database con soluzioni di messaggistica come Kafka. Grazie alle funzionalità di Kafka, i database non sono più necessari.

Kafka non è un database

Kafka non è un database, ma è spesso usato insieme a uno. È un broker di messaggi che può essere utilizzato per inviare messaggi tra diversi componenti di un sistema. Viene spesso utilizzato per disaccoppiare diverse parti di un sistema in modo che possano scalare in modo indipendente.

È possibile sostituire Apache Kafka con un database, ma non farlo per comodità. L'episodio di Top Gear in cui i protagonisti hanno ricevuto $ 10.000 ciascuno per l'acquisto di una supercar italiana usata a motore centrale mi ha ricordato un vecchio episodio di Top Gear in cui i protagonisti ricevevano $ 10.000 ciascuno. Nel 2011, LinkedIn ha rilasciato Kafka e questo episodio è andato in onda lo stesso anno. Ti consente di eseguire il minimo indispensabile di messaggistica persistente senza investire in una piattaforma di messaggistica completa. La premessa fondamentale è che esiste una regola di base. Crea una tabella (o bucket, raccolta, indice, qualunque cosa) per ogni evento che è stato registrato durante il processo di produzione. Esegui regolarmente il polling del database da un'istanza del consumatore, aggiornando lo stato del consumatore mentre viene elaborato.

Affinché il modello funzioni correttamente, produttori e consumatori dovrebbero poter lavorare contemporaneamente. Prendi in considerazione l'utilizzo del libro di Kafka come guida e l'archiviazione dei record a tempo indeterminato anziché semplicemente leggerli. I gruppi di consumatori disgiunti, d'altra parte, potrebbero essere implementati duplicando i record all'inserimento, quindi eliminando i record dopo il consumo. Kafka utilizza offset persistenti per abilitare il data fanning definito dall'utente e supportare più consumatori disgiunti. Per interrompere questa funzionalità, è necessario sviluppare un servizio da zero. Non è difficile implementare il concetto di purga basata sul tempo, ma è necessario ospitare la logica degli spazzini. Su Kafka ci sono controlli capillari su tutti gli attori (consumatori, produttori e amministratori).

Può elaborare milioni di record al secondo su commodity e server cloud senza problemi. Kafka è ottimizzato per alti livelli di produttività sia dal punto di vista del produttore che del consumatore, in senso non funzionale. Utilizzando Kafka, è un registro distribuito di sola aggiunta che non ha rivali in questo campo. A differenza dei tradizionali broker di messaggi che rimuovono i messaggi nella fase di consumo, Kafka non elimina i messaggi dopo che sono stati consumati. La velocità effettiva e la latenza di un database dovranno quasi certamente essere notevolmente migliorate attraverso l'uso di hardware specializzato e un'ottimizzazione delle prestazioni altamente mirata. Fare a meno di un broker può essere allettante a prima vista. Quando utilizzi una piattaforma di eventi in streaming come Kafka, capitalizzi l'enorme sforzo ingegneristico che è stato necessario per la sua costruzione.

Per garantire che qualsiasi soluzione tu scelga di implementare oggi possa essere mantenuta, devi essere certo che possa essere mantenuta a uno standard elevato. La maggior parte delle funzioni in un archivio eventi può essere implementata solo attraverso l'uso di un database. Non esiste un negozio di eventi adatto a tutti; qualsiasi archivio di eventi non banale, nella maggior parte dei casi, è quasi certamente un'implementazione su misura supportata da uno o più database standard. È possibile utilizzare i database nel campo dell'organizzazione dei dati per un recupero efficiente, ma si dovrebbe evitare di utilizzarli per distribuire i dati (quasi) in tempo reale.